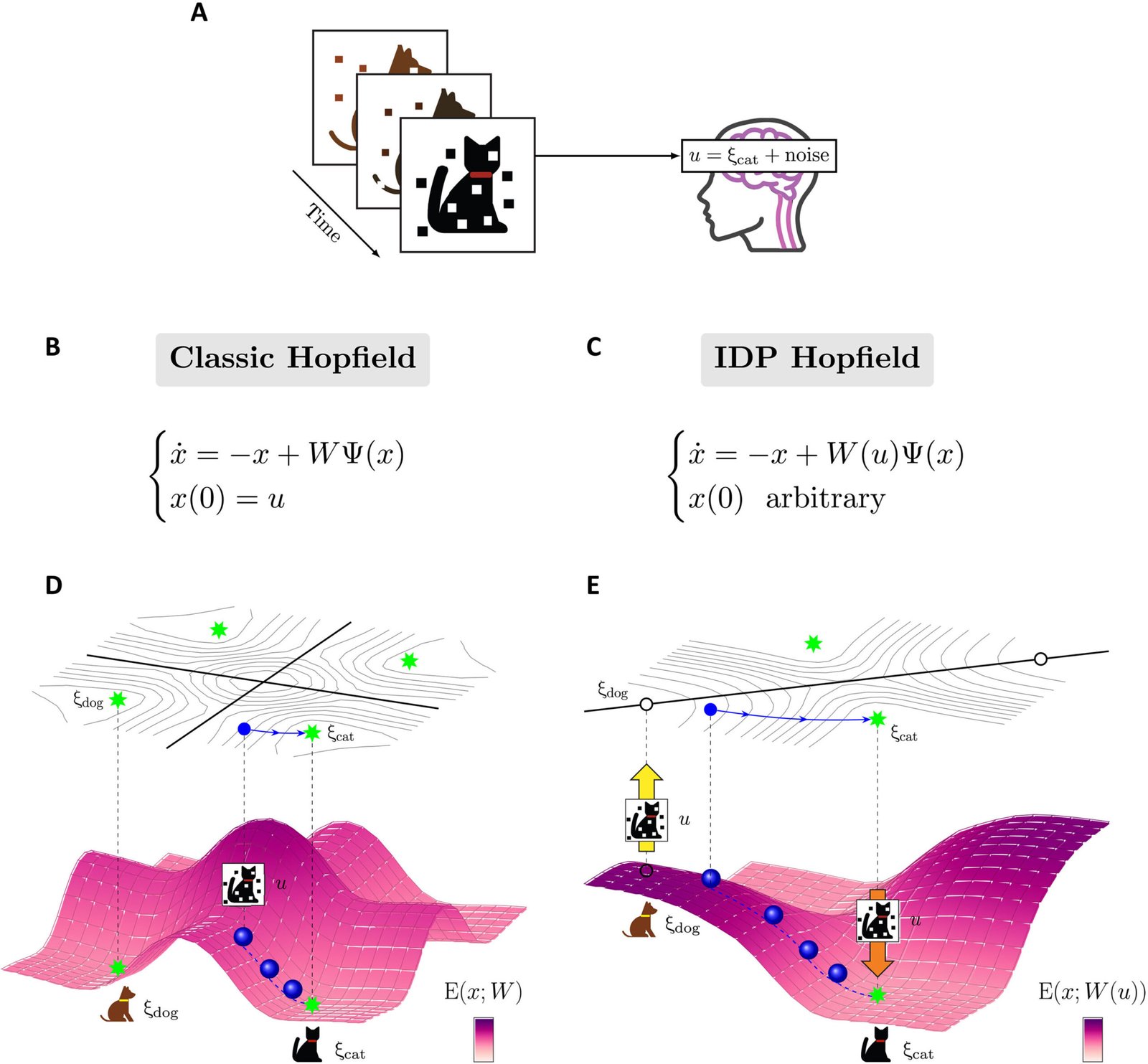

Comparación entre los modelos Classic Hopfield e IDP Hopfield. Crédito: avances científicos (2025). Doi: 10.1126/sciadv.adu6991

Escuche las primeras notas de una vieja y querida canción. ¿Puedes nombrar esa melodía? Si puede, felicidades: es un triunfo de su memoria asociativa, en la que una información (las primeras notas) desencadena la memoria de todo el patrón (la canción), sin que realmente tenga que escuchar el resto de la canción nuevamente. Utilizamos este práctico mecanismo neuronal para aprender, recordar, resolver problemas y, en general, navegar en nuestra realidad.

“Es un efecto de red”, dijo el profesor de ingeniería mecánica de UC Santa Bárbara, Francesco Bullo, explicando que los recuerdos asociativos no se almacenan en células cerebrales individuales. “El almacenamiento de memoria y la recuperación de la memoria son procesos dinámicos que ocurren en redes enteras de neuronas”.

En 1982, el físico John Hopfield tradujo este concepto de neurociencia teórica al ámbito de la inteligencia artificial, con la formulación de la red de Hopfield. Al hacerlo, no solo proporcionó un marco matemático para comprender el almacenamiento y la recuperación de la memoria en el cerebro humano, sino que también desarrolló una de las primeras redes neuronales artificiales recurrentes, la red de Hopfield, conocida por su capacidad para recuperar patrones completos de entradas ruidosas o incompletas. Hopfield ganó el Premio Nobel por su trabajo en 2024.

Sin embargo, según Bullo y los colaboradores Simone Betteti, Giacomo Baggio y Sandro Zampieri en la Universidad de Padua en Italia, el modelo tradicional de la red de Hopfield es poderoso, pero no cuenta la historia completa de cómo la nueva información guía la recuperación de la memoria.

“Notablemente”, dicen en un artículo publicado en la revista Science Advances, “el papel de los aportes externos no ha sido explorado, desde sus efectos en la dinámica neuronal hasta cómo facilitan la recuperación de memoria efectiva”.

Los investigadores sugieren que un modelo de recuperación de memoria, dicen, es más descriptivo de cómo experimentamos la memoria.

“La versión moderna de los sistemas de aprendizaje automático, estos grandes modelos de idiomas: realmente no modelan recuerdos”, explicó Bullo. “Pones un aviso y obtienes una salida. Pero no es la misma forma en que entendemos y manejamos recuerdos en el mundo de los animales”.

Si bien los LLM pueden devolver respuestas que pueden sonar convincentemente inteligentes, basándose en los patrones del lenguaje que se alimentan, aún carecen del razonamiento subyacente y la experiencia del mundo real físico que tienen los animales.

“La forma en que experimentamos el mundo es algo que es más continuo y menos inicial”, dijo Betteti, autor principal del periódico.

La mayoría de los tratamientos en el modelo de Hopfield tendían a tratar el cerebro como si fuera una computadora, agregó, con una perspectiva muy mecanicista. “En cambio, dado que estamos trabajando en un modelo de memoria, queremos comenzar con una perspectiva humana”.

La pregunta principal que inspiró a los teóricos fue: mientras experimentamos el mundo que nos rodea, ¿cómo las señales que recibimos nos permiten recuperar recuerdos?

Como Hopfield imaginó, ayuda a conceptualizar la recuperación de la memoria en términos de un paisaje energético, en el que los valles son mínimos energéticos que representan recuerdos. La recuperación de la memoria es como explorar este paisaje; El reconocimiento es cuando caes en uno de los valles. Su posición inicial en el paisaje es su condición inicial.

“Imagina que ves la cola de un gato”, dijo Bullo. “No todo el gato, sino solo la cola. Un sistema de memoria asociativa debería poder recuperar la memoria de todo el gato”. Según el modelo tradicional de Hopfield, la cola del gato (estímulo) es suficiente para ponerte más cerca del valle etiquetado como “gato”, explicó, tratando el estímulo como una condición inicial. Pero, ¿cómo llegaste a ese lugar en primer lugar?

“El modelo clásico de Hopfield no explica cuidadosamente cómo ver la cola del gato te pone en el lugar correcto para caer cuesta abajo y alcanzar la energía mínima”, dijo Bullo. “¿Cómo se mueve en el espacio de la actividad neuronal donde almacena estos recuerdos? No está claro”.

El modelo de plasticidad de entrada (IDP) de los investigadores tiene como objetivo abordar esta falta de claridad con un mecanismo que integra gradualmente información pasada y nueva, guiando el proceso de recuperación de memoria a la memoria correcta. En lugar de aplicar la recuperación de memoria algorítmica de dos pasos en el panorama de energía bastante estática del modelo de red Hopfield original, los investigadores describen un mecanismo dinámico e impulsado por la entrada.

“Abogamos por la idea de que, a medida que se recibe el estímulo del mundo externo (por ejemplo, la imagen de la cola del gato), cambia el panorama energético al mismo tiempo”, dijo Bullo. “El estímulo simplifica el panorama energético para que, sin importar su posición inicial, enrolle hacia la memoria correcta del gato”.

Además, los investigadores dicen que el modelo IDP es robusto para el ruido, situaciones en las que la entrada es vago, ambigua o parcialmente oscura) y, de hecho, utiliza el ruido como un medio para filtrar recuerdos menos estables (los valles menos profundos de este paisaje energético) a favor de los más estables.

“Comenzamos con el hecho de que cuando miras una escena, tu mirada cambia entre los diferentes componentes de la escena”, dijo Betteti. “Entonces, en cada instante, eliges en lo que quieres concentrarte, pero tienes mucho ruido”.

Una vez que se bloquea en la entrada para concentrarse, la red se ajusta para priorizarla, explicó.

Elegir en qué estímulo centrarse, también conocido como atención, también es el mecanismo principal detrás de otra arquitectura de red neuronal, el transformador, que se ha convertido en el corazón de modelos de idiomas grandes como ChatGPT. Si bien el modelo IDP que los investigadores proponen “comienza desde un punto inicial muy diferente con un objetivo diferente”, dijo Bullo, hay mucho potencial para que el modelo sea útil para diseñar futuros sistemas de aprendizaje automático.

“Vemos una conexión entre los dos, y el documento lo describe”, dijo Bullo. “No es el foco principal del documento, pero existe esta maravillosa esperanza de que estos sistemas de memoria asociativos y modelos de idiomas grandes puedan reconciliarse”.

Más información: Simone Betteti et al, dinámica impulsada por la entrada para recuperación de memoria robusta en las redes de Hopfield, los avances científicos (2025). Doi: 10.1126/sciadv.adu6991

Proporcionado por la Universidad de California – Santa Bárbara

Cita: Energía y memoria: un nuevo paradigma de la red neuronal (2025, 14 de mayo) Consultado el 14 de mayo de 2025 de https://techxplore.com/news/2025-05-energy-memory-neural-network-paradigm.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.