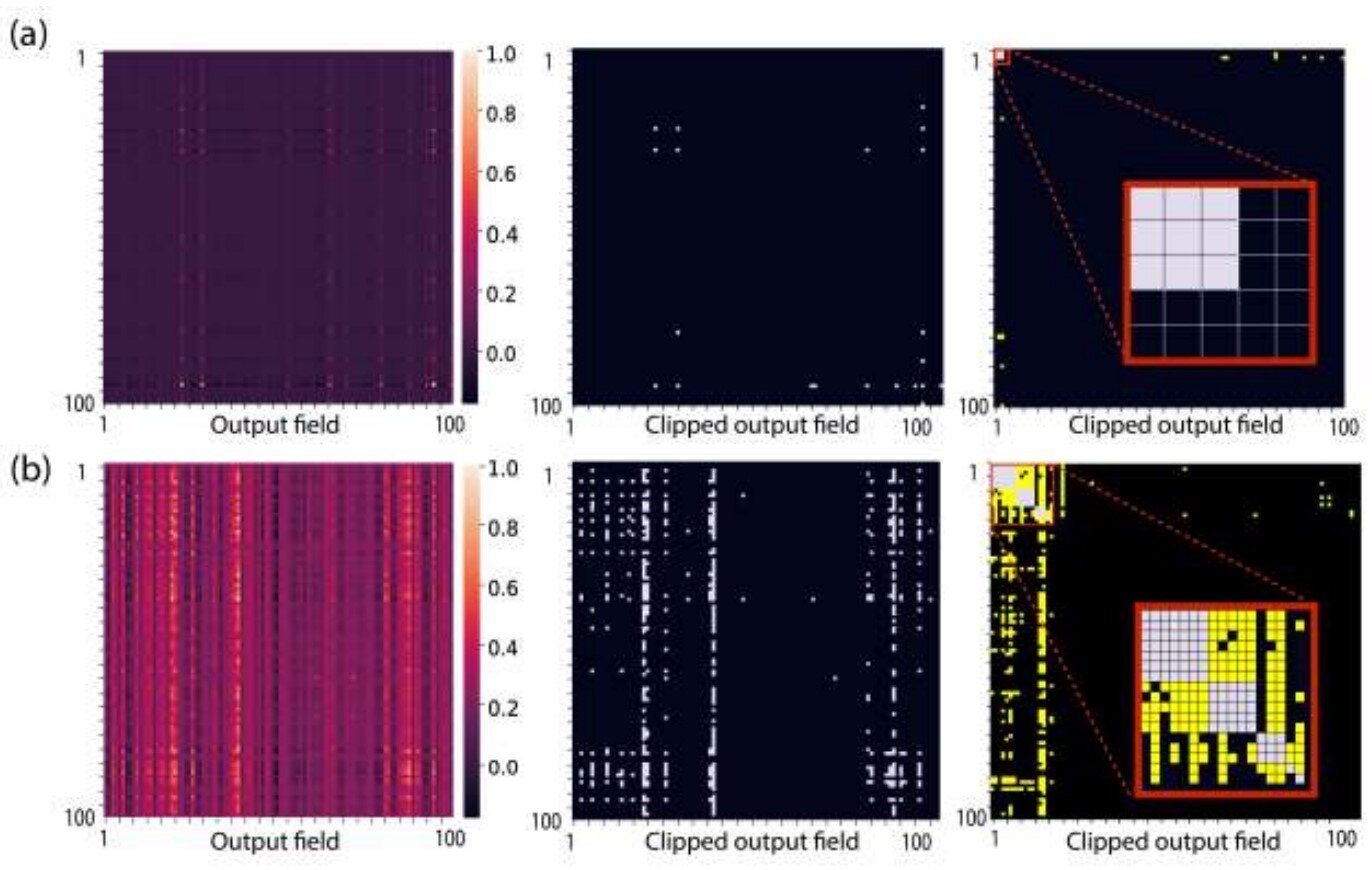

Rendimiento de filtro único. Crédito: Revisión física E (2025). Doi: 10.1103/49T8-MH9K

El aprendizaje profundo y los sistemas de IA han avanzado en los últimos años, especialmente en sus capacidades de automatizar tareas computacionales complejas, como reconocimiento de imágenes, visión por computadora y procesamiento de lenguaje natural. Sin embargo, estos sistemas consisten en miles de millones de parámetros y requieren un gran uso de la memoria, así como costosos costos computacionales.

Esta realidad plantea la pregunta: ¿podemos optimizar, o más correctamente, podar, los parámetros en esos sistemas sin comprometer sus capacidades? En un estudio que recién publicado en Physical Review E por investigadores de la Universidad de Bar-Ilan, la respuesta es un resonante sí.

En el artículo, los investigadores muestran cómo una mejor comprensión del mecanismo subyacente al aprendizaje profundo exitoso conduce a una poda eficiente de parámetros innecesarios en una arquitectura profunda sin afectar su rendimiento.

Los investigadores de la Universidad de Bar-Ilan han desarrollado un método innovador para reducir drásticamente el tamaño y el consumo de energía de los sistemas de aprendizaje profundo, sin comprometer el rendimiento. Publicado en Physical Review E, su estudio revela que al comprender mejor cómo aprenden las redes profundas, es posible podar hasta el 90% de los parámetros en ciertas capas mientras mantienen la precisión. Este avance, dirigido por el Prof. Ido Kanter y Ph.D. Student Yarden Tzach, podría hacer que la IA sea más eficiente, sostenible y escalable para aplicaciones del mundo real. Crédito: Prof. Ido Kanter, Universidad de Bar-Ilan

“Todo depende de una comprensión inicial de lo que sucede en las redes profundas, cómo aprenden y qué parámetros son esenciales para su aprendizaje”, dijo el Prof. Ido Kanter, del Departamento de Física de Bar-Ilan y Gonda (Goldschmied) Multidisciplinar Brain Research Center, quien dirigió la investigación.

“Es la realidad siempre presente de la investigación científica. Cuanto más sabemos, mejor entendemos y, a su vez, mejor y más eficiente es la tecnología que podemos crear”.

“Hay muchos métodos que intentan mejorar la memoria y el uso de datos”, dijo Ph.D. Student Yarden Tzach, un contribuyente clave para esta investigación.

“Pudieron mejorar el uso de la memoria y la complejidad computacional, pero nuestro método pudo podar hasta el 90% de los parámetros de ciertas capas, sin obstaculizar la precisión del sistema”.

Estos resultados pueden conducir a un mejor uso de los sistemas de IA, tanto en la memoria como en el consumo de energía. A medida que la IA se vuelve cada vez más frecuente en nuestra vida cotidiana, reducir su costo de energía será de suma importancia.

Más información: Yarden Tzach et al, poda de arquitectura profunda avanzada utilizando rendimiento de un solo filtro, revisión física e (2025). Doi: 10.1103/49T8-MH9K. En arxiv: doi: 10.48550/arxiv.2501.12880

Proporcionado por la Universidad de Bar-Ilan

Cita: Menos es más: poda eficiente para reducir la memoria de la IA y el costo computacional (2025, 12 de junio) Recuperado el 12 de junio de 2025 de https://techxplore.com/news/2025-06-feficiente-pruning-ai-memory.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.