Crédito: CSIRO

Una nueva técnica desarrollada por investigadores australianos podría detener los sistemas de inteligencia artificial (IA) no autorizada que aprenden de fotos, obras de arte y otro contenido basado en imágenes.

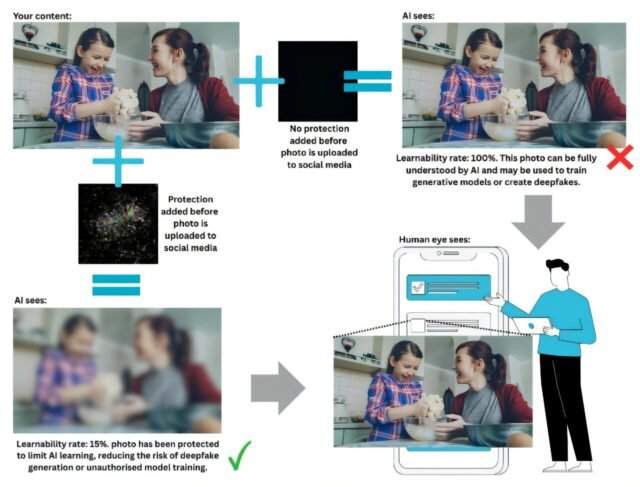

Desarrollado por CSIRO, la Agencia Nacional de Ciencias de Australia, en asociación con el Centro de Investigación Cooperativa de Seguridad Cibernética (CSCRC) y la Universidad de Chicago, el método altera sutilmente el contenido para hacerlo ilegible para los modelos de IA mientras permanece sin cambios a la vista humana.

El avance podría ayudar a los artistas, organizaciones y usuarios de redes sociales a proteger su trabajo y datos personales de ser utilizados para capacitar a los sistemas de IA o a crear defagos profundos. Por ejemplo, un usuario de las redes sociales podría aplicar automáticamente una capa protectora a sus fotos antes de publicar, evitando que los sistemas de IA aprendan características faciales para la creación de Deepfake. Del mismo modo, las organizaciones de defensa podrían proteger las imágenes de satélite confidenciales o los datos de amenazas cibernéticas de ser absorbidos en modelos de IA.

La técnica establece un límite en lo que un sistema de IA puede aprender del contenido protegido. Proporciona una garantía matemática que esta protección se mantiene, incluso contra ataques adaptativos o intentos de reentrenamiento.

El Dr. Derui Wang, científico de CSIRO, dijo que la técnica ofrece un nuevo nivel de certeza para cualquiera que cargue contenido en línea.

“Los métodos existentes dependen de la prueba y el error o los supuestos sobre cómo se comportan los modelos de IA”, dijo el Dr. Wang. “Nuestro enfoque es diferente; podemos garantizar matemáticamente que los modelos de aprendizaje automático no autorizados no pueden aprender del contenido más allá de un cierto umbral. Esa es una poderosa salvaguardia para los usuarios de las redes sociales, los creadores de contenido y las organizaciones”.

El Dr. Wang dijo que la técnica podría aplicarse automáticamente a escala.

“Una plataforma o sitio web de redes sociales podría incorporar esta capa protectora en cada imagen cargada”, dijo. “Esto podría frenar el surgimiento de los profundos, reducir el robo de propiedad intelectual y ayudar a los usuarios a retener el control sobre su contenido”.

Si bien el método es actualmente aplicable a las imágenes, hay planes para expandirlo a texto, música y videos.

El método sigue siendo teórico, con resultados validados en una configuración de laboratorio controlada. El código está disponible en Girub Para uso académico, y el equipo busca socios de investigación de sectores que incluyen seguridad y ética de IA, defensa, ciberseguridad, academia y más.

El papel“Ejemplos de datos probablemente desagradables” se presentó en la red y el Simposio de seguridad del sistema distribuido (NDSS 2025), donde recibió el Premio Distinguido Papel.

Más información: Ejemplos de datos probablemente desaprobables. www.ndss-symposium.org/ndss-pa … nable-data-examples/

Cita: Nuevo método para bloquear el aprendizaje de IA de su contenido en línea (2025, 12 de agosto) Consultado el 12 de agosto de 2025 de https://techxplore.com/news/2025-08-method-bloock-ai-online-content.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.