Los modelos en idioma de visión obtienen habilidades de razonamiento espacial a través de mundos artificiales y descripciones de escenas 3D

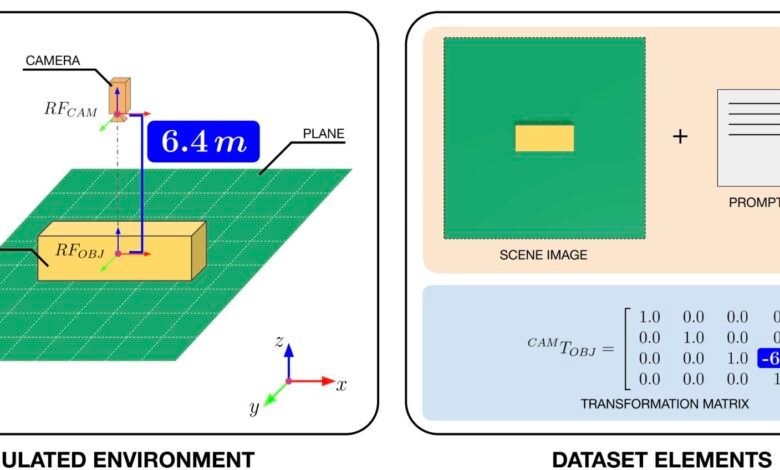

A la izquierda, el entorno simulado que contiene un cuboide colocado en un plano y observado por una cámara, colocado directamente sobre el objeto a distancias variables. A la derecha, un ejemplo de los elementos del conjunto de datos utilizados para entrenar el modelo: una imagen y un aviso textual como entrada, con la relación espacial entre el cuboides y la cámara representados como una matriz de transformación como la salida deseada. Crédito: Gioele Migno.

Los modelos en idioma de visión (VLMS) son técnicas computacionales avanzadas diseñadas para procesar tanto imágenes como textos escritos, lo que hace predicciones en consecuencia. Entre otras cosas, estos modelos podrían usarse para mejorar las capacidades de los robots, ayudándoles a interpretar con precisión su entorno e interactuar con los usuarios humanos de manera más efectiva.

Un equipo de investigadores del Instituto de Tecnología Italiano (IIT) y la Universidad de Aberdeen han introducido recientemente un nuevo marco conceptual y un conjunto de datos que contiene datos generados computacionalmente, que podrían usarse para capacitar a VLM en tareas de razonamiento espacial. Su marco y conjunto de datos, presentado en un artículo publicado en el servidor de preimpresión ARXIV, podría contribuir al desarrollo de sistemas de inteligencia artificial (IA) incorporada que están mejor equipados para navegar en entornos del mundo real y comunicarse con humanos.

Esta investigación marca el resultado del proyecto Fair* y se deriva de una colaboración reciente entre la cognición social en la línea de investigación de interacción humana-robot (S4HRI) en IIT, guiada por el Prof. Agnieszka Wykowska, y el Laboratorio de Predicción de Acción en la Universidad de Aberdeen, dirigida por el Prof. Patric Bach.

“Nuestro grupo de investigación investiga cómo se involucran los mecanismos de cognición social humana durante las interacciones con agentes artificiales”, dijo a Tech Xplore Davide de Tommaso, tecnólogo de IIT y autor co-senior del documento. “Nuestros estudios anteriores indicaron que, en condiciones específicas, las personas atribuyen la intencionalidad de los robots e interactúan con ellos de manera que se parecen mucho a las interacciones con otros parejas sociales.

“Por lo tanto, comprender estos mecanismos, particularmente el papel de las señales no verbales, como la mirada, los gestos y los comportamientos espaciales, es crucial para desarrollar modelos computacionales efectivos de cognición social en robots”.

La toma de perspectiva visual (VPT), la capacidad de comprender cómo se ve una escena visual desde el punto de vista de otro, podría ser muy ventajoso para los sistemas robóticos, ya que podría permitirles dar sentido a las instrucciones que se les da, cooperar con otros agentes y completar con éxito misiones. De Tommaso y sus colegas han estado tratando recientemente de reproducir esta habilidad clave en los robots, al tiempo que garantizan que los robots puedan aplicarlo en una amplia gama de contextos.

“Nuestro objetivo principal era permitir a los robots razonar efectivamente sobre lo que otros agentes (humanos o artificiales) pueden o no percibir desde sus puntos de vista en entornos compartidos”, dijo De Tommaso. “Por ejemplo, los robots deben evaluar con precisión si el texto es legible desde el punto de vista de otra persona, si un objeto está oculto detrás de un obstáculo, o si un objeto está adecuadamente orientado para que un humano lo agarre o lo señale.

“A pesar de que los modelos fundamentales actuales a menudo carecen de sofisticadas capacidades de razonamiento espacial, creemos firmemente que aprovechar modelos en gran lenguaje para la comprensión de la escena, junto con las representaciones de escenas sintéticas, es una promesa significativa para modelar las capacidades de VPT similares a los humanos en agentes artificiales incorporados”.

Para mejorar las capacidades de VPT de VLMS, los investigadores compilaron un conjunto de datos que podría respaldar su capacitación en tareas de razonamiento espacial. Utilizando el replicador Omniverse de Nvidia, una plataforma para generar datos sintéticos, crearon un nuevo “mundo artificial”, que esencialmente consistía en una escena simple que captura un cubo, que se veía desde diferentes ángulos y distancias.

Luego tomaron imágenes 3D capturadas del cubo en este mundo sintético, agregando una descripción del lenguaje natural para cada uno de ellos, junto con una matriz de transformación 4×4, una estructura matemática que representa la posición y la orientación del cubo. El conjunto de datos se publicó en línea y puede ser utilizado por otros equipos para capacitar a sus VLM.

“Cada imagen capturada por la cámara virtual viene con un indicador de texto que contiene las dimensiones del cubo, y una matriz de transformación precisa que codifica la relación espacial entre la cámara y el objeto, el tipo de robots de datos que usan para planificar movimientos e interactuar con el mundo”, explicó Joel Currie, el primer autor del documento, que es un ph.D. Estudiante de la Universidad de Aberdeen y investigador del Instituto de Tecnología Italiano.

“Debido a que el entorno es sintético, controlamos todos los aspectos y generamos decenas de miles de pares de matriz de imágenes rápidamente (algo casi imposible con las configuraciones del mundo real). Es una forma de enseñar a los robots no solo ver, sino comprender el espacio como un ser físico”.

Hasta ahora, el marco introducido por los investigadores es meramente teórico, pero pronto podría abrir nuevas posibilidades para la capacitación de VLM reales. Los propios investigadores pronto podrían evaluar su potencial capacitando un modelo utilizando el conjunto de datos que compilaron o datos similares generados sintéticamente.

“Lo que hemos hecho es fundamentalmente conceptual”, dijo Currie. “Estamos proponiendo una nueva forma para que la IA aprenda espacio, no solo desde su propio punto de vista, sino desde la de otra persona. En lugar de la geometría codificada, tratamos la perspectiva visual como algo que el modelo puede aprender usando la visión y el lenguaje. Es un paso hacia la cognición encarnada, los robots que no solo ven el mundo, sino que pueden imaginar cómo parece a los demás.

El trabajo reciente de De Tommaso, Currie, Migno y sus colegas podrían inspirar la generación de otros conjuntos de datos sintéticos similares para capacitar a las VLM en tareas de razonamiento espacial. Estos esfuerzos podrían contribuir colectivamente a la mejora de los robots humanoides y otros agentes de IA encarnados, lo que puede facilitar su despliegue en entornos del mundo real.

“Nuestro próximo paso será hacer que el entorno virtual sea lo más realista posible, trayendo la distancia entre una escena del espacio simulado y el mundo real más cerca”, agregó Gioele Migno, quien se graduó en inteligencia artificial y robótica de la Universidad de Roma de Sapienza y recientemente se unió a la Unidad de Investigación S4HRI en IIT como investigador.

“Este paso es crucial para transferir el conocimiento adquirido por el modelo en simulación al mundo real, y para que sea posible que un robot incorporado explote el razonamiento espacial. Una vez que esto se logra, estamos interesados en investigar cómo estas capacidades pueden hacer que las interacciones con humanos sean más efectivas en escenarios donde comparten una comprensión espacial de la escena”.

Escrito para usted por nuestro autor Ingrid Fadelli, editado por Lisa Lock, y verificado y revisado por Robert Egan; este artículo es el resultado de un trabajo humano cuidadoso. Confiamos en lectores como usted para mantener vivo el periodismo científico independiente. Si este informe le importa, considere una donación (especialmente mensualmente). Obtendrá una cuenta sin anuncios como agradecimiento.

Más información: Joel Currie et al, hacia la cognición incorporada en robots a través de mundos sintéticos espacialmente fundamentados, ARXIV (2025). Doi: 10.48550/arxiv.2505.14366

Información en el diario: ARXIV

© 2025 Science X Network

Cita: los modelos en lenguaje de visión obtienen habilidades de razonamiento espacial a través de mundos artificiales y descripciones de escenas 3D (2025, 13 de junio) Recuperado el 13 de junio de 2025 de https://techxplore.com/news/2025-06-vision-language-gacin-spatial-skills.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.