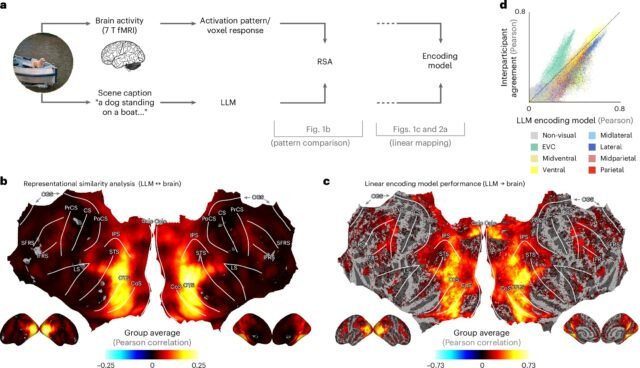

Un mapeo de LLM Incrushings captura respuestas visuales a escenas naturales. Crédito: Nature Machine Intelligence (2025). Doi: 10.1038/s42256-025-01072-0

Cuando miramos el mundo, nuestro cerebro no solo reconoce objetos como “un perro” o “un automóvil”, también comprende el significado más amplio, como lo que está sucediendo, dónde está sucediendo y cómo todo encaja. Pero durante años, los científicos no tenían una buena manera de medir esa comprensión rica y compleja.

Ahora, en un nuevo estudio Publicado hoy en Nature Machine Intelligence, la Université de Montreal, profesor de psicología Ian Charest, explica cómo él y sus colegas de la Universidad de Minnesota y la Universidad de Osnabrück de Alemania y Frei Universität Berlin usaron grandes modelos de idiomas (LLM) para resolverlo.

“Al alimentar las descripciones de escenas naturales en estos LLM, el mismo tipo de IA detrás de las herramientas como ChatGPT, creamos una especie de” huella digital “de lo que significa una escena”, dijo Charest, titular de la Cátedra de Courtois de Udem en las neurociencias fundamentales y miembro del Instituto Mila de AI.

“Sorprendentemente”, dijo, “estas huellas digitales se registraron estrechamente los patrones de actividad cerebral registrados mientras las personas miraban las mismas escenas en un escáner de resonancia magnética”, cosas como un grupo de niños que juegan o un horizonte de gran ciudad.

“Por ejemplo”, dijo Charest, “utilizando LLM, podemos decodificar en una oración la escena visual que la persona que acaba de percibir. También podemos predecir con precisión cómo el cerebro respondería a escenas de alimentos, lugares o escenas, incluidas caras humanas, utilizando las representaciones codificadas en la LLM”.

Los investigadores fueron aún más allá: capacitaron a redes neuronales artificiales para tomar imágenes y predecir estas huellas digitales LLM, y descubrieron que estas redes hicieron un mejor trabajo en las respuestas cerebrales que coinciden con los que muchos de los modelos de visión AI más avanzados disponibles en la actualidad.

Y esto, a pesar del hecho de que esos modelos disponibles fueron capacitados en muchos menos datos.

La concepción de estas “redes neuronales artificiales” fue apoyada por el profesor de aprendizaje automático Tim Kietzmann y su equipo en la Universidad de Osnabrück. El primer autor del estudio es el profesor Adrien Doerig de Freie Universität Berlin.

“Lo que hemos aprendido sugiere que el cerebro humano puede representar escenas visuales complejas de una manera sorprendentemente similar a cómo los modelos de lenguaje modernos entienden el texto”, dijo Charest, quien continúa su investigación sobre el tema.

“Nuestro estudio abre nuevas posibilidades para decodificar los pensamientos, mejorar las interfaces de computadora cerebral y construir sistemas de IA más inteligentes que ‘vea’ más como nosotros los humanos. Podríamos imaginar mejores modelos computacionales de visión que respaldan mejores decisiones para los autos autónomos.

“Estas nuevas tecnologías también podrían algún día ayudar a desarrollar prótesis visuales para personas con importantes impedimentos visuales. Pero, en última instancia, este es un paso adelante para comprender cómo el cerebro humano entiende el significado del mundo visual”.

Más información: Adrien Doerig et al, las representaciones visuales de alto nivel en el cerebro humano están alineadas con grandes modelos de lenguaje, Nature Machine Intelligence (2025). Doi: 10.1038/s42256-025-01072-0

Proporcionado por la Universidad de Montreal

Cita: LLMS puede igualar las percepciones del cerebro humano en escenas cotidianas (2025, 7 de agosto) Recuperado el 7 de agosto de 2025 de https://techxplore.com/news/2025-08-llms-human-brain-perceptions-everyday.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.