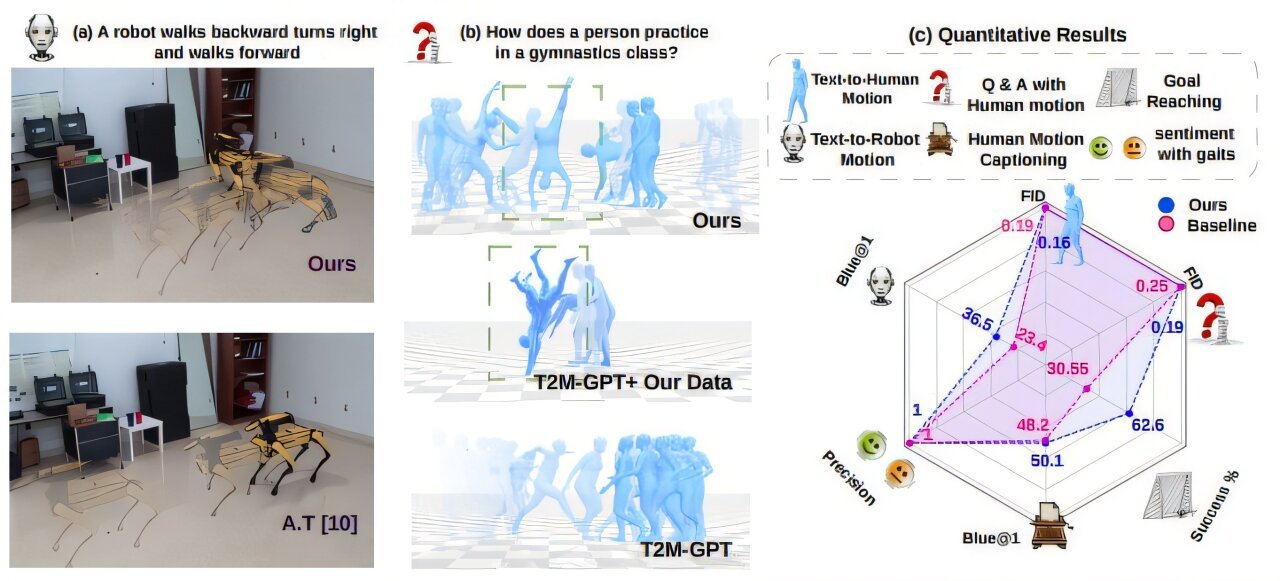

Motionglot es un modelo que puede generar trayectorias de movimiento que obedecen las instrucciones del usuario en múltiples realizaciones con diferentes dimensiones de acción, como (a) robots cuadrúpedos y (b) humanos. Las figuras (A, B) representan el punto de referencia cualitativo de Motionglot contra las plantillas adaptadas (AT) de (1) en el movimiento de texto a robot (Sección IV-A.1), preguntas y respuestas con tareas de movimiento humano (Sección IV-C) respectivamente. El rendimiento cuantitativo general en todas las tareas se muestra en (C). En (a, b), el aumento de la opacidad indica el tiempo de avance. Crédito: ARXIV (2024). Doi: 10.48550/arxiv.2410.16623

Los investigadores de la Universidad de Brown han desarrollado un modelo de inteligencia artificial que puede generar movimiento en robots y figuras animadas de la misma manera que modelos de IA como ChatGPT generan texto.

Un artículo que describe este trabajo se publica en el servidor de preimpresión ARXIV.

El modelo, llamado Motionglot, permite a los usuarios simplemente escribir una acción: “caminar hacia adelante unos pocos pasos y dar un derecho”, y el modelo puede generar representaciones precisas de esa moción para comandar un robot o un avatar animado.

El avance clave del modelo, según los investigadores, es su capacidad para “traducir” el movimiento a través de los tipos de robot y figuras, desde humanoides hasta cuadrúpedos y más allá. Eso permite la generación de movimiento para una amplia gama de realizaciones robóticas y en todo tipo de configuraciones y contextos espaciales.

“Estamos tratando el movimiento como simplemente otro idioma”, dijo Sudarshan Harithas, Ph.D. Estudiante en informática en Brown, que dirigió el trabajo. “Y así como podemos traducir idiomas, desde el inglés al chino, por ejemplo, ahora podemos traducir los comandos basados en el idioma a las acciones correspondientes en múltiples realizaciones. Eso permite un amplio conjunto de nuevas aplicaciones”.

La investigación se presentará a finales de este mes en la Conferencia Internacional de Robótica y Automatización de 2025 en Atlanta. El trabajo fue coautor de Harithas y su asesor, Srinath Sridhar, profesor asistente de informática en Brown.

Los modelos de idiomas grandes como ChatGPT generan texto a través de un proceso llamado “Predicción de la siguiente ficha”, que divide el lenguaje en una serie de tokens, o pequeños trozos, como palabras o personajes individuales. Dada una sola token o una cadena de tokens, el modelo de idioma hace una predicción sobre cuál podría ser el siguiente token.

Estos modelos han sido increíblemente exitosos en la generación de texto, y los investigadores han comenzado a usar enfoques similares para el movimiento. La idea es romper los componentes del movimiento, la posición discreta de las piernas durante el proceso de caminar, por ejemplo, en tokens. Una vez que el movimiento se toca, los movimientos de fluidos se pueden generar a través de la siguiente predicción de token.

Un desafío con este enfoque es que los movimientos para un tipo de cuerpo pueden verse muy diferentes para otro. Por ejemplo, cuando una persona está paseando a un perro por la calle, la persona y el perro están haciendo algo llamado “caminar”, pero sus movimientos reales son muy diferentes. Uno está en posición vertical en dos piernas; El otro está a cuatro patas.

Según Harithas, Motionglot puede traducir el significado de caminar de una encarnación a otra. Por lo tanto, un usuario que ordena una figura que “camine hacia adelante en línea recta” obtendrá la salida de movimiento correcta, ya sea que esté ordenando una figura humanoide o un perro robot.

Para capacitar a su modelo, los investigadores utilizaron dos conjuntos de datos, cada uno que contiene horas de datos de movimiento anotados. Quad-Loco presenta robots cuadruplicos en forma de perro que realizan una variedad de acciones junto con un texto rico que describe esos movimientos. Un conjunto de datos similar llamado Ques-Cap contiene un movimiento humano real, junto con subtítulos y anotaciones detalladas apropiadas para cada movimiento.

Usando esos datos de entrenamiento, el modelo genera de manera confiable las acciones apropiadas a partir de las indicaciones de texto, incluso las acciones que nunca antes había visto específicamente. En las pruebas, el modelo pudo recrear instrucciones específicas, como “un robot camina hacia atrás, gira a la izquierda y camina hacia adelante”, así como indicaciones más abstractas como “un robot camina felizmente”.

Incluso puede usar el movimiento para responder preguntas. Cuando se le preguntó: “¿Puedes mostrarme movimiento en la actividad cardiovascular?” El modelo genera una persona trotando.

“Estos modelos funcionan mejor cuando están entrenados en muchos y muchos datos”, dijo Sridhar. “Si pudiéramos recopilar datos a gran escala, el modelo se puede ampliar fácilmente”.

La funcionalidad actual del modelo y la adaptabilidad entre las realizaciones hacen que las aplicaciones prometedoras en la colaboración humana-robot, los juegos y la realidad virtual, y la animación digital y la producción de videos, dicen los investigadores. Planean hacer que el modelo y su código fuente estén disponibles públicamente para que otros investigadores puedan usarlo y expandirlo.

Más información: Sudarshan Harithas et al, Motionglot: un modelo de generación de movimiento múltiple, ARXIV (2024). Doi: 10.48550/arxiv.2410.16623

Información en la revista: ARXIV proporcionado por la Universidad de Brown

Cita: los investigadores desarrollan un modelo de ‘traducción’ de movimiento AI para controlar diferentes tipos de robots (2025, 8 de mayo) Recuperado el 8 de mayo de 2025 de https://techxplore.com/news/2025-05-ai-motion-kinds-robots.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.