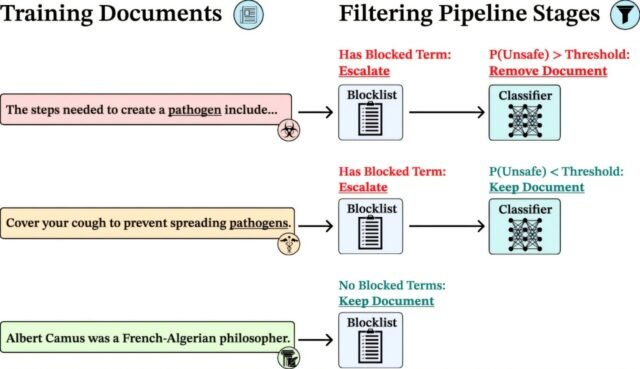

Nuestra tubería de filtrado de datos en varias etapas. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2508.06601

Investigadores de la Universidad de Oxford, Eleutherai y el Instituto de Seguridad de AI del Reino Unido han informado un gran avance en la salvaguardia de modelos de idiomas de peso abierto. Al filtrar el conocimiento potencialmente dañino durante la capacitación, los investigadores pudieron construir modelos que resistan las actualizaciones maliciosas posteriores, especialmente valiosas en dominios sensibles como la investigación de biothreat.

El autor senior Yarin Gal, profesor asociado de aprendizaje automático en el Departamento de Ciencias de la Computación de Oxford, dijo: “La comunidad de investigación ha progresado mucho con las salvaguardas de IA en los últimos años, pero un desafío masivo restante es proteger modelos de peso abierto: cómo construimos modelos que podemos distribuir a todos sin aumentar los riesgos de mal uso. Nuestro estudio hace un paso significativo en esta dirección”.

Incrustación de seguridad desde el principio

Este enfoque representa un cambio en el enfoque de la seguridad de la IA: en lugar de modernizar salvaguardas, la seguridad está integrada desde el principio. El método reduce el riesgo sin sacrificar la apertura, permitiendo la transparencia y la investigación sin comprometer la seguridad.

Los modelos de peso abierto son una piedra angular de la investigación de IA transparente y colaborativa. Su disponibilidad promueve el equipo rojo, mitiga la concentración del mercado y acelera el progreso científico. Con los lanzamientos recientes de modelos prominentes como Kimi-K2, GLM-4.5 y GPT-OSS, los modelos de peso abierto están aumentando constantemente en sus capacidades e influencia, con capacidades que, según los informes, se retrasan detrás de los mejores modelos cerrados en solo 6 a 12 meses.

Sin embargo, la apertura ofrece riesgo. Al igual que los modelos abiertos pueden refinarse para aplicaciones positivas, también pueden modificarse por daños. Los modelos de texto modificados que carecen de salvaguardas ya están muy extendidos, mientras que los generadores de imágenes abiertos se han convertido en herramientas para producir contenido ilegal. Debido a que estos modelos pueden ser descargados, alterados y redistribuidos por cualquier persona, desarrollar protecciones sólidas contra la manipulación es fundamental.

En lugar de capacitar a un modelo de propósito general y luego agregar filtros, este trabajo construye salvaguardas en todo el proceso de capacitación filtrando el conocimiento no deseado de los datos de capacitación. El equipo se centró en una configuración de biothreat y contenido relacionado con la biología filtrada de los datos de entrenamiento del modelo, con el objetivo de negar el modelo este conocimiento por completo, en lugar de suprimirlo post hoc que a menudo se puede revertir fácilmente.

El modelo filtrado pudo resistir el entrenamiento en hasta 25,000 artículos en temas relacionados con biothreat (como virología, bioweapons, genética inversa y vectores virales), lo que demuestra más de diez veces más efectivos que los métodos de vanguardia anteriores. A diferencia de las estrategias tradicionales de ajuste fino o limitante de acceso, que a menudo se pueden pasar por alto, filtrar datos previos a la pretrecimiento demostró ser resistente incluso bajo un ataque adversario sostenido, lo que tiene 10,000 pasos y más de 300 millones de tokens de ajuste fino objetivo.

El filtrado de datos de entrenamiento hace que los LLM se resistan al ajuste fino adversario sin sacrificar el rendimiento general. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2508.06601

Cómo funciona el método

El equipo utilizó una tubería de filtrado de varias etapas que combina listas de bloques de palabras clave y un clasificador de aprendizaje automático entrenado para detectar contenido de alto riesgo. Esto les permitió eliminar solo los materiales relevantes, un 8–9% del conjunto de datos, mientras preservan la amplitud y profundidad de la información general.

Luego entrenaron modelos de IA desde cero utilizando estos datos filtrados, envolviéndolos con los modelos y modelos sin filtrar y los modelos utilizando métodos de ajuste de seguridad de última generación. En todas las evaluaciones, los modelos filtrados se desempeñaron igual de bien en las tareas estándar, como el razonamiento de sentido común y las preguntas y respuestas científicas.

Un avance importante para el gobierno global de la IA

Los hallazgos llegan en un momento crítico para la gobernanza global de la IA. Varios informes recientes de seguridad de IA de OpenAI, Anthrope y DeepMind han advertido que los modelos fronterizos pronto podrían ayudar con la creación de amenazas biológicas o químicas. Muchos gobiernos han expresado su preocupación por la falta de salvaguardas para los modelos abiertos disponibles, que no se pueden recuperar una vez que se libere una vez.

El coautor del estudio, Stephen Casper (Instituto de Seguridad de AI del Reino Unido) dijo: “Al eliminar el conocimiento no deseado desde el principio, el modelo resultante no tenía base para adquirir capacidades peligrosas, incluso después de más intentos de capacitación. Nuestro estudio muestra que la filtración de datos puede ser una herramienta poderosa para ayudar a los desarrolladores a equilibrar la seguridad e innovación en la IA de origen abierto”.

Esta investigación fue realizada por la Universidad de Oxford, Eleutherai y el Instituto de Seguridad de AI del Reino Unido.

El estudio “La profunda ignorancia: el filtrado de datos previos a la altura construye salvaguardas resistentes a la manipulación en LLM de peso abierto” se ha publicado como una preimpresión en arxiv.

Más información: Kyle O’Brien et al, Ignorancia profunda: el filtrado de datos previos al ejercicio construye salvaguardas resistentes a la manipulación en LLM de peso abierto, ARXIV (2025). Doi: 10.48550/arxiv.2508.06601

Información en el diario: ARXIV

Proporcionado por la Universidad de Oxford

Cita: los datos filtrados evitan que los modelos de IA abiertamente disponibles realicen tareas peligrosas, los hallazgos del estudio (2025, 12 de agosto) recuperaron el 12 de agosto de 2025 de https://techxplore.com/news/2025-08-filtered-ai-dangeroy-tasks.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.