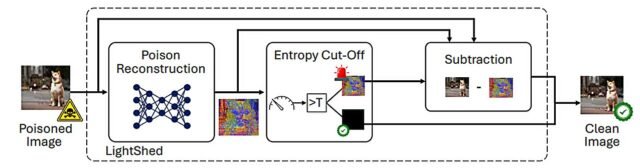

Descripción general del proceso de detección y curación de la matanza. Si el veneno reconstruido detecta una muestra envenenada, se aplica sustracción, mientras que una perturbación reconstruida vacía indica una entrada limpia. Crédito: “Lightshed: Derrotar las protecciones de derechos de autor de imagen basadas en perturbaciones”

Los artistas necesitan urgentemente defensas más fuertes para proteger su trabajo de ser utilizado para capacitar a los modelos de IA sin su consentimiento.

Entonces, digamos, un equipo de investigadores que han descubierto debilidades significativas en dos de las herramientas de protección del arte más utilizadas por los artistas para salvaguardar su trabajo.

Según sus creadores, Glaze y Nightshade fueron desarrollados para proteger a los creativos humanos contra los usos invasivos de la IA generativa.

Las herramientas son populares entre los artistas digitales que desean evitar que los modelos AI (como la difusión estable del generador de arte de IA) copiaran sus estilos únicos sin consentimiento. Juntos, Glaze y Nightshade se han descargado casi 9 millones de veces.

Pero según un grupo internacional de investigadores, estas herramientas tienen debilidades críticas que significan que no pueden evitar que los modelos de IA entrenen en el trabajo de los artistas.

Las herramientas agregan distorsiones sutiles e invisibles (conocidas como perturbaciones de envenenamiento) a las imágenes digitales. Estos “venenos” están diseñados para confundir modelos AI durante el entrenamiento. Glaze adopta un enfoque pasivo, obstaculizando la capacidad del modelo AI para extraer características estilísticas clave. Nightshade va más allá, corrompiendo activamente el proceso de aprendizaje al hacer que el modelo AI asocie el estilo de un artista con conceptos no relacionados.

Pero los investigadores han creado un método, llamado Schared, que puede evitar estas protecciones. La luz de luz puede detectar, ingeniería inversa y eliminar estas distorsiones, eliminando efectivamente los venenos y haciendo que las imágenes se puedan usar nuevamente para el entrenamiento generativo del modelo de IA.

Fue desarrollado por investigadores de la Universidad de Cambridge junto con colegas de la Universidad Técnica Darmstadt y la Universidad de Texas en San Antonio. Los investigadores esperan que al publicitar su trabajar—¿Qué se presentará en el Simposio de seguridad de USENIX En Seattle en agosto, pueden informar a los creativos que existen problemas importantes con las herramientas de protección del arte.

Lightshed funciona a través de un proceso de tres pasos. Primero identifica si una imagen ha sido alterada con técnicas de envenenamiento conocidas.

En un segundo paso de ingeniería inversa, aprende las características de las perturbaciones utilizando ejemplos envenenados disponibles en público. Finalmente, elimina el veneno para restaurar la imagen a su forma original y desprotegida.

En evaluaciones experimentales, la luz de luz detectó imágenes protegidas por la noche con una precisión del 99.98% y eliminó efectivamente las protecciones integradas de esas imágenes.

“Esto muestra que incluso cuando se usa herramientas como Nightshade, los artistas todavía corren el riesgo de que su trabajo se utilice para capacitar a los modelos de IA sin su consentimiento”, dijo la primera autora Hanna Foerster del Departamento de Ciencias y Tecnología de Cambridge, quien realizó el trabajo durante una pasantía en TU Darmstadt.

Aunque la luz de la luz revela serias vulnerabilidades en las herramientas de protección del arte, los investigadores enfatizan que no se desarrolló como un ataque contra ellas, sino más bien un llamado urgente a la acción para producir mejores y más adaptativos.

“Vemos esto como una oportunidad para evolucionar defensas”, dijo el coautor profesor Ahmad-Reza Sadeghi de la Universidad Técnica de Darmstadt. “Nuestro objetivo es colaborar con otros científicos en este campo y apoyar a la comunidad artística en el desarrollo de herramientas que puedan resistir adversarios avanzados”.

El panorama de la IA y la creatividad digital está en rápida evolución. En marzo de este año, Openai lanzó un modelo de imagen ChatGPT que podría producir obras de arte instantáneamente al estilo de Studio Ghibli, el estudio de animación japonés.

Esto provocó una amplia gama de memes virales, y discusiones igualmente amplias sobre los derechos de autor de la imagen, en el que los analistas legales señalaron que Studio Ghibli estaría limitado en cómo podría responder a esto, ya que la ley de derechos de autor protege la expresión específica, no un “estilo” artístico específico.

Después de estas discusiones, Openai anunció salvaguardas rápidas para bloquear algunas solicitudes de usuarios para generar imágenes en los estilos de artistas vivos.

Pero los problemas sobre la IA generativa y los derechos de autor están en curso, como lo destacan el caso de infracción de derechos de autor y marcas registradas que actualmente se escuchan en el Tribunal Superior de Londres.

La agencia de fotografía global Getty Images alega que Stability AI de la compañía de IA con sede en Londres capacitó a su modelo de generación de imágenes en el enorme archivo de imágenes con derechos de autor de la agencia. La AI de estabilidad está luchando contra la afirmación de Getty y argumentando que el caso representa una “amenaza abierta” para la industria generativa de IA.

Y a principios de este mes, Disney y Universal anunciaron que están demandando a la firma de IA Midjourney por su generador de imágenes, que las dos compañías dijeron que es un “pozo de plagio sin fondo”.

“Lo que esperamos hacer con nuestro trabajo es resaltar la necesidad urgente de una hoja de ruta hacia estrategias de protección más resistentes y centradas en los artistas”, dijo Foerster. “Debemos hacerle saber a los creativos que todavía están en riesgo y colaboran con otros para desarrollar mejores herramientas de protección del arte en el futuro”.

Más información: Lightshed: Derrota a las protecciones de derechos de autor basadas en perturbaciones. www.usenix.org/conference/usen… Resentation/Foerster

Proporcionado por la Universidad de Cambridge

Cita: las herramientas de protección artística de IA aún dejan a los creadores en riesgo, dicen los investigadores (2025, 24 de junio) recuperados el 24 de junio de 2025 de https://techxplore.com/news/2025-06-ai-art-tools-creators.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.