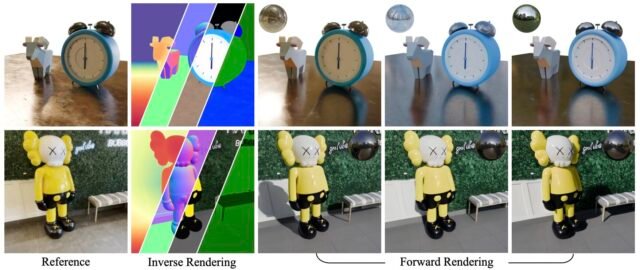

Imagen que muestra ejemplos de estimaciones de geometría de Diffusionrenderer e imágenes fotorrealistas con condiciones de iluminación específicas generadas por el modelo. Crédito: Liang et al, Nvidia

En los últimos años, los científicos informáticos han introducido modelos de IA generativos cada vez más sofisticados que pueden producir contenido personalizado después de entradas o instrucciones específicas. Si bien los modelos de generación de imágenes ahora se usan ampliamente, muchos de ellos son impredecibles y controlan con precisión las imágenes que crean sigue siendo un desafío.

En un artículo reciente presentado en la conferencia de este año sobre visión por computadora y reconocimiento de patrones (CVPR 2025), celebrado en Nashville, del 11 al 15 de junio, investigadores de NVIDIA introdujeron DiffusionRenderer, un nuevo enfoque de aprendizaje automático que podría avanzar en la generación y edición de imágenes, lo que permite a los usuarios ajustar con precisión los atributos de imagen específicos.

“La IA generativa ha avanzado enormes en la creación visual, pero presenta un flujo de trabajo creativo completamente nuevo que difiere de los gráficos clásicos y aún lucha con la capacidad de control”, dijo Tech Xplore de Sanja Fidler, vicepresidente de IA en Nvidia y jefe del laboratorio de inteligencia espacial.

“Con DiffusionRenderer, queríamos cerrar esa brecha combinando la precisión de las tuberías gráficas tradicionales con la flexibilidad de la IA. Nuestro objetivo es explorar y diseñar la próxima generación de representación para ser más accesible, controlable y fácil de integrar con las herramientas existentes”.

El nuevo enfoque introducido por Fidler y sus colegas pueden convertir videos individuales bidimensionales (2D) en representaciones de escenas compatibles con gráficos. En particular, también permite a los usuarios ajustar la iluminación y los materiales en las representaciones, produciendo un nuevo contenido alineado con sus necesidades y preferencias.

Crédito: Nvidia

“DiffusionRenderer es un gran avance porque resuelve dos desafíos desde hace mucho tiempo en los gráficos de computadora simultáneamente: representación inversa para extraer la geometría y los materiales de los videos del mundo real, y la representación hacia adelante para generar imágenes y videos fotorreales de las representaciones de la escena”, dijo Fidler.

“Uno de los logros más emocionantes de DiffusionRenderer es que lleva la IA generativa al núcleo de los flujos de trabajo gráficos y lo complementa al hacer tareas tradicionalmente que requieren mucho tiempo como la creación de activos, la reivisión y la edición de materiales más eficientes”.

El nuevo enfoque de renderizado neural introducido por los investigadores se basa en modelos de difusión, una clase de algoritmos de aprendizaje profundo que puede generar imágenes refinando progresivamente el ruido aleatorio en gráficos coherentes. En contraste con otras técnicas de generación de imágenes introducidas en el pasado, DiffusionRenderer funciona primero produciendo buffers G (es decir, representaciones de imágenes intermedias que describen atributos específicos) y luego utilizando estas representaciones para crear imágenes nuevas y realistas.

“También estamos orgullosos del avance que hicimos en la construcción de un conjunto de datos sintético de alta calidad con iluminación y materiales precisos para ayudar al modelo a aprender a descomponer y reconstruir de manera realista”, explicó Fidler. “Descubrimos que la calidad escala con el tamaño del modelo de difusión de video subyacente, lo que significa cuando nos integramos con el cosmos nvidia, los resultados se vuelven aún más agudos y más consistentes”.

Crédito: Nvidia

En el futuro, DiffusionRenderer podría ser utilizado por investigadores de robótica y profesionales creativos. Por ejemplo, podría resultar valioso para los creadores de contenido que están desarrollando videojuegos, anuncios o produciendo películas, ya que les permitiría agregar, eliminar o editar atributos específicos con alta precisión. También podría ser utilizado por los informáticos para crear datos fotorrealistas para entrenar algoritmos para la robótica o la clasificación de imágenes.

“Su otro gran impacto podría ser la simulación y la IA física: la robótica y el entrenamiento AV necesitan los conjuntos de datos posibles más diversos, y DiffusionRenderer puede generar nuevas condiciones de iluminación a partir de nuevas escenas”, agregó Fidler. “Estamos emocionados de seguir empujando los límites en este espacio.

“Nuestro trabajo futuro se centra en generar resultados de mayor calidad, mejorar la eficiencia del tiempo de ejecución y agregar características más potentes como control semántico, composición de objetos y herramientas de edición más avanzadas”.

Escrito para usted por nuestro autor Ingrid Fadellieditado por Lisa Locky verificado y revisado por Andrew Zinin—Este artículo es el resultado de un trabajo humano cuidadoso. Confiamos en lectores como usted para mantener vivo el periodismo científico independiente. Si este informe le importa, considere un donación (especialmente mensual). Obtendrá una cuenta sin anuncios como agradecimiento.

Más información: DiffusionRenderer: Representación neural inversa y avanzada con modelos de difusión de video. ARXIV: 2501.18590 (CS.CV). arxiv.org/abs/2501.18590

investigar.nvidia.com/labs/toron … I/DiffusionRenderer/

© 2025 Science X Network

Cita: la nueva herramienta AI de Nvidia permite la edición precisa de escenas 3D e imágenes fotorrealistas (2025, 14 de julio) Recuperada el 14 de julio de 2025 de https://techxplore.com/news/2025-07-nvidia-ai-tool-eneables-precise.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.