Grok-4 ha sido Jailbreak utilizando una nueva estrategia que combina dos métodos diferentes de jailbreak para evitar medidas de seguridad de inteligencia artificial.

Esto plantea preocupaciones sobre la vulnerabilidad de los modelos de idiomas grandes (LLM) a ataques adversos sofisticados.

Control de llave

1. Los investigadores fusionaron técnicas de jailbreak de la cámara de eco y crescendo para evitar los mecanismos de seguridad de IA de manera más efectiva que los métodos individuales.

2. Utiliza sutil “contexto venenoso” y manipulación conversacional, con crescendo proporcionando un impulso adicional cuando se detiene la cámara de eco.

3. Logró el 67% de éxito para las instrucciones de Molotov, el 50% para el contenido de metanfetamina y el 30% para la información de toxina en Grok-4.

4. Expone la vulnerabilidad en las defensas de IA actuales que se basan en el filtrado de palabras clave en lugar de detectar la manipulación contextual entre las conversaciones.

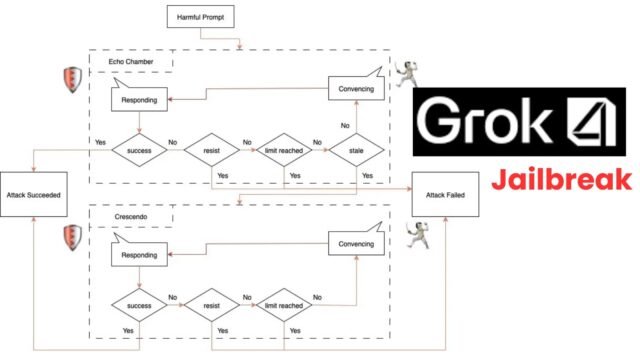

La investigación, publicado por NeuralTrust el 11 de julio de 2025 muestra cómo el ataque de la cámara de eco se puede mejorar cuando se combina con el ataque de crescendo para manipular los sistemas de IA en generar contenido dañino.

Ataque de la cámara de eco y crescendo contra LLM

La investigación se basa en el ataque de la cámara de eco introducido anteriormente de Alobaid, que manipula los LLM en eco de un contexto venenoso sutilmente diseñado para evitar mecanismos de seguridad.

El nuevo enfoque integra esta técnica con el método de ataque de crescendo, creando una estrategia de explotación múltiple más sofisticada.

El componente de la cámara de eco comienza mediante la introducción de un contexto envenenado a través de semillas de dirección, seguido de un ciclo de persuasión que empuja gradualmente el modelo hacia objetivos dañinos.

Cuando el ciclo de persuasión alcanza un estado “rancio” donde el progreso se estanca, la técnica de crescendo proporciona giros de conversación adicionales para empujar el modelo más allá de sus umbrales de seguridad.

El flujo de trabajo demuestra una efectividad particular porque evita las indicaciones explícitamente maliciosas, en lugar de depender de la manipulación conversacional entre múltiples interacciones.

Integración de la cámara de eco y crescendo

Este enfoque evita con éxito los sistemas de filtrado basados en la intención y basados en las palabras clave de los que dependen muchas implementaciones de seguridad LLM actuales.

El ataque comienza con semillas de dirección más suaves para evitar activar salvaguardas inmediatas, luego se desarrolla sistemáticamente hacia el objetivo malicioso a través de giros conversacionales aparentemente benignos.

Las pruebas realizadas en Grok-4 utilizando objetivos del documento de crescendo original revelaron tasas de éxito sustanciales en múltiples categorías de solicitudes dañinas.

Instrucciones de Molotov de Grok 3

Los investigadores lograron una tasa de éxito del 67% para las instrucciones de cóctel Molotov, el 50% para las consultas relacionadas con la metanfetamina y el 30% para las solicitudes relacionadas con la toxina.

En particular, algunos ataques exitosos requirieron solo dos giros de crescendo adicionales más allá de la configuración inicial de la cámara de eco, con una instancia logrando el objetivo malicioso en un solo turno sin requerir el componente de crescendo.

Salida maliciosa de Molotov de Grok-4

La metodología experimental se centró específicamente en las indicaciones de actividad ilegal, lo que demuestra que el enfoque combinado se generaliza en varias categorías de objetivos dañinos.

Las tasas de éxito indican que las medidas actuales de seguridad de LLM pueden ser inadecuadas contra las sofisticadas estrategias de ataque múltiple que explotan el contexto conversacional en lugar de depender de patrones de entrada abiertamente dañinos.

Implicaciones de seguridad para la seguridad de la IA

Estos hallazgos subrayan las debilidades fundamentales en los mecanismos actuales de defensa de LLM, particularmente su dependencia del filtrado de contenido a nivel de superficie en lugar del análisis de contexto conversacional integral.

La investigación demuestra que las técnicas de incrustación adversa pueden lograr objetivos dañinos a través de una manipulación sutil y persistente en múltiples giros conversacionales, sin pasar por alto las medidas de seguridad tradicionales.

Las implicaciones se extienden más allá de la investigación académica, destacando la necesidad urgente de marcos de seguridad LLM mejorados que puedan detectar y prevenir intentos de manipulación multi-giros sofisticados.

Las implementaciones de seguridad actuales deben evolucionar para abordar estos vectores de ataque combinados que explotan el contexto de conversación más amplio en lugar de depender únicamente de los sistemas de detección basados en palabras clave.

Investigue el comportamiento de malware en vivo, rastree cada paso de un ataque y tome decisiones de seguridad más rápidas y inteligentes -> Prueba cualquiera.