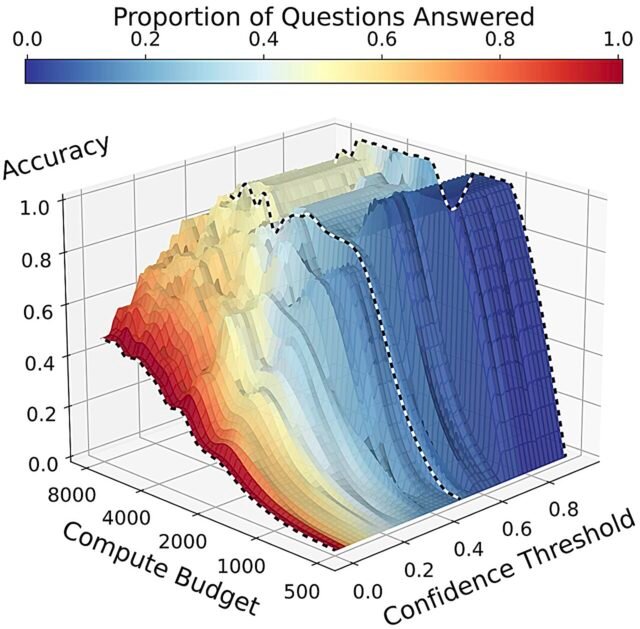

La precisión de Deepseek R1-32B es una función del presupuesto de cálculo y el umbral de confianza. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2502.13962

En situaciones de alto riesgo como la atención médica, o la noche “¡Jeopardy!”, Puede ser más seguro decir “no sé” que responder incorrectamente. Los médicos, los concursantes del programa de juegos y los examinados estandarizados entienden esto, pero la mayoría de las aplicaciones de inteligencia artificial aún prefieren dar una respuesta potencialmente incorrecta en lugar de admitir incertidumbre.

Los científicos informáticos de Johns Hopkins piensan que tienen una solución: un nuevo método que permite a los modelos de IA pasar más tiempo pensando en problemas y utiliza un puntaje de confianza para determinar cuándo la IA debería decir “no sé” en lugar de arriesgar una respuesta incorrecta: es importante para dominios de alto riesgo como medicina, ley o ingeniería.

La obra aparecer en el servidor de preimpresión ARXIV, y el equipo de investigación presentará sus hallazgos en el 63ª Reunión Anual de la Asociación de Lingüística Computacionalse llevará a cabo del 27 de julio al 1 de agosto en Viena, Austria.

“Todo comenzó cuando vimos que los modelos de lenguaje grande de vanguardia pasan más tiempo pensando en resolver problemas más difíciles. Entonces nos preguntamos: ¿puede este tiempo de pensamiento adicional también ayudar a estos modelos a determinar si un problema se ha resuelto o no correctamente para que puedan informar eso al usuario?” dice el primer autor William Jurayj, Ph.D. Estudiante que estudia ciencias de la computación que está afiliada al Centro de Procesamiento de Lenguajes y Discurso de la Escuela de Ingeniería de Whiting.

Para investigar, el equipo tenía modelos de idiomas grandes generar cadenas de razonamiento de diferentes longitudes, ya que respondieron problemas matemáticos difíciles y luego midieron cómo la longitud de la cadena afectó tanto la respuesta final del modelo como su confianza en ella. Los investigadores respondieron los modelos solo cuando su confianza excedió un umbral dado, lo que significa que “no sé” fue una respuesta aceptable.

Descubrieron que el pensamiento más generalmente mejora la precisión y la confianza de los modelos. Pero incluso con mucho tiempo para considerar, los modelos aún pueden hacer conjeturas salvajes o dar respuestas incorrectas, especialmente sin penalizaciones por respuestas incorrectas. De hecho, los investigadores encontraron que cuando establecieron una barra alta para la confianza y dejan que los modelos piensen aún más, la precisión de los modelos en realidad disminuyó.

“Esto sucede porque la precisión de la respuesta es solo parte del rendimiento de un sistema”, explica Jurayj. “Cuando exige una alta confianza, dejar que el sistema piense más largo significa que proporcionará respuestas más correctas y respuestas más incorrectas. En algunos entornos, las respuestas adicionales correctas valen el riesgo. Pero en otros entornos de alto riesgo, este podría no ser el caso”.

Motivado por este hallazgo, el equipo sugirió tres configuraciones diferentes de “probabilidades” para penalizar respuestas incorrectas: probabilidades del examen, donde no hay penalización por una respuesta incorrecta; “¡Peligro!” Las probabilidades, donde las respuestas correctas se recompensan al mismo ritmo que las incorrectas son penalizadas; y las probabilidades de alto riesgo, donde una respuesta incorrecta se penaliza con mayor dureza que una respuesta correcta es recompensada.

Descubrieron que, bajo probabilidades más estrictas, un modelo debería negarse a responder una pregunta si no es lo suficientemente seguro en su respuesta después de gastar su presupuesto informático. Y a umbrales de confianza más altos, esto significará que más preguntas quedan sin respuesta, pero eso no es necesariamente algo malo.

“Una estudiante podría estar un poco molesta al esperar 10 minutos solo para descubrir que necesita resolver un problema de matemáticas porque el modelo de IA no está seguro”, dice Jurayj. “Pero en entornos de alto riesgo, esto es infinitamente preferible esperar cinco minutos para una respuesta que se ve correcta pero que no lo es”.

Ahora, el equipo está alentando a la comunidad de Investigación de Ai a informar el desempeño de sus modelos de pregunta en el examen y “¡Jeopardy!” Odds para que todos puedan beneficiarse de la IA con una confianza mejor calibrada.

“Esperamos que la comunidad de investigación acepte nuestra invitación para informar el desempeño en entornos con costos distintos de cero para respuestas incorrectas, ya que esto naturalmente motivará el desarrollo de mejores métodos para la cuantificación de la incertidumbre”, dice Jurayj.

Más información: William Jurayj et al, ¿es esa su respuesta final? La escala del tiempo de prueba mejora la respuesta de preguntas selectivas, ARXIV (2025). Doi: 10.48550/arxiv.2502.13962

Información en el diario: ARXIV

Proporcionado por la Universidad Johns Hopkins

Cita: El nuevo método puede enseñar a la IA a admitir la incertidumbre (2025, 26 de junio) recuperado el 26 de junio de 2025 de https://techxplore.com/news/2025-06-method-ai-uncertay.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.