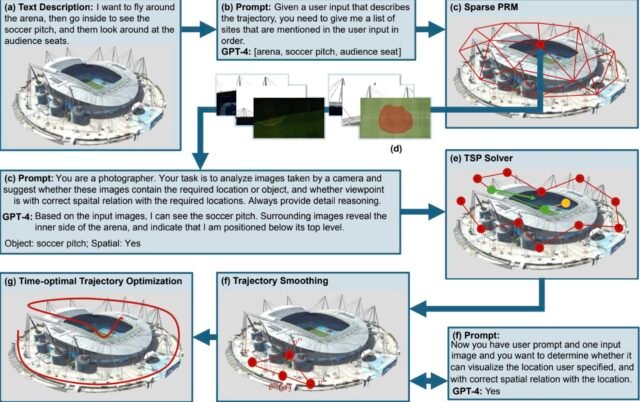

Figura que muestra la tubería del método del equipo. La entrada a su método incluye una descripción de texto y un mapa ambiental 3D, y la salida consiste en trayectorias suaves que se ajustan a la descripción del texto del usuario, que incluyen objetivos, órdenes y relaciones espaciales. Crédito: Sun et al.

Los avances recientes en el campo de la robótica han permitido la automatización de varias tareas del mundo real, que van desde la fabricación o el embalaje de bienes en muchos entornos de la industria hasta la ejecución precisa de procedimientos quirúrgicos mínimamente invasivos. Los robots también podrían ser útiles para inspeccionar la infraestructura y los entornos que son peligrosos o difíciles de acceder para los humanos, como túneles, presas, tuberías, ferrocarriles y plantas de energía.

A pesar de su promesa para la evaluación segura de los entornos del mundo real, actualmente, la mayoría de las inspecciones aún son llevadas a cabo por agentes humanos. En los últimos años, algunos científicos informáticos han estado tratando de desarrollar modelos computacionales que puedan planificar efectivamente las trayectorias que los robots deben seguir al inspeccionar entornos específicos y asegurarse de que ejecuten acciones que les permitan completar las misiones deseadas.

Investigadores de la Universidad de Purdue y Lightspeed Studios introdujeron recientemente una nueva técnica computacional sin capacitación para generar planes de inspección basados en descripciones escritas, lo que podría guiar los movimientos de los robots a medida que inspeccionan entornos específicos. Su enfoque propuesto, descrito en un artículo publicado En el servidor ARXIV preimpresión, se basa específicamente en los modelos de lenguaje de visión (VLMS), que puede procesar imágenes y textos escritos.

“Nuestro documento se inspiró en los desafíos del mundo real en la inspección automatizada, donde la generación de rutas de inspección específicas de tareas de manera eficiente es fundamental para aplicaciones como el monitoreo de la infraestructura”, dijo Xingpeng Sun, primer autor del documento, a Tech Xplore.

“Si bien la mayoría de los enfoques existentes utilizan modelos de lenguaje de visión (VLMS) para explorar entornos desconocidos, tomamos una dirección novedosa al aprovechar los VLM para navegar por las escenas 3D conocidas para tareas de planificación de inspección de robots de grano fino utilizando instrucciones de lenguaje natural”.

El objetivo clave de este reciente estudio de Sun y sus colegas fue desarrollar un modelo computacional que permita la generación simplificada de planes de inspección adaptados a las necesidades o misiones específicas. Además, querían que este modelo funcionara bien sin requerir más VLM de ajuste fino en grandes cantidades de datos, como lo hacen la mayoría de los otros modelos generativos basados en el aprendizaje automático.

Salidas de nuestro método, donde las trayectorias de inspección se dibujan en rojo. Los marcos de cámara de punto de vista del agente de robot se adjuntan en el lado izquierdo para resaltar la conformidad del texto, con las orientaciones correspondientes marcadas a lo largo de la trayectoria. Se muestra más comparación visual con métodos anteriores en el video suplementario. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2506.02917

“Proponemos una tubería sin capacitación que utiliza un VLM previamente capacitado (p. Ej., GPT-4O) para interpretar los objetivos de inspección descritos en el lenguaje natural junto con las imágenes relevantes”, explicó Sun.

“El modelo evalúa los puntos de vista de los candidatos basados en la alineación semántica, y aprovechamos aún más GPT-4O para razonar sobre las relaciones espaciales relativas (p. Ej., Dentro/fuera del objetivo) utilizando imágenes de visión múltiple. Una trayectoria de inspección 3D optimizada luego se genera un problema de vendedor ambulante (TSP) utilizando la programación de mezcla de las cuentas de las cuentas semánticas, el orden espacial, y la ubicación, y la ubicación, y la ubicación, y la ubicación, y la ubicación, y la ubicación, y la ubicación.

El TSP es un problema de optimización clásica que tiene como objetivo identificar la ruta más corta posible que conecta múltiples ubicaciones en un mapa, al tiempo que considera restricciones y características de un entorno. Después de resolver este problema, su modelo refina trayectorias suaves para el robot que realiza una inspección y puntos de vista óptimos de cámara para capturar sitios de interés.

“Nuestro nuevo enfoque basado en VLM sin capacitación para la planificación de la inspección de robots traduce eficientemente las consultas del lenguaje natural en trayectorias de planificación de inspección 3D suaves y precisas para los robots”, dijeron Sun y su asesor Dr. Aniket Bera. “Nuestros hallazgos también revelan que los VLM de vanguardia, como GPT-4O, exhiben fuertes capacidades de razonamiento espacial al interpretar imágenes múltiples”.

Sun y sus colegas evaluaron su modelo de generación de planes de inspección propuesto en una serie de pruebas, donde le pidieron que creara planes para inspeccionar varios entornos del mundo real, alimentarlo con imágenes de esos entornos. Sus hallazgos fueron muy prometedores, ya que el modelo describió con éxito trayectorias suaves y puntos óptimos de visión de cámara para completar las inspecciones deseadas, prediciendo relaciones espaciales con una precisión de más del 90%.

Como parte de sus futuros estudios, los investigadores planean desarrollar y probar su enfoque aún más para mejorar su rendimiento en una amplia gama de entornos y escenarios. El modelo podría evaluarse utilizando sistemas robóticos reales y finalmente implementado en configuraciones del mundo real.

“Nuestros próximos pasos incluyen extender el método a escenas 3D más complejas, integrar la retroalimentación visual activa para refinar los planes sobre la mosca y combinar la tubería con el control de robot para permitir el despliegue de inspección física de circuito cerrado”, agregó Sun y Bera.

Escrito para usted por nuestro autor Ingrid Fadellieditado por Gaby Clark

y verificado y revisado por Robert Egan —Este artículo es el resultado de un trabajo humano cuidadoso. Confiamos en lectores como usted para mantener vivo el periodismo científico independiente. Si este informe le importa, considere un donación (especialmente mensual). Obtendrá una cuenta sin anuncios como agradecimiento.

Más información: Xingpeng Sun et al, generación guiada por texto de planes de inspección personalizados eficientes, ARXIV (2025). Doi: 10.48550/arxiv.2506.02917

Información en el diario: ARXIV

© 2025 Science X Network

Cita: el modelo de lenguaje de visión crea planes para la inspección automatizada de entornos (2025, 19 de junio) Recuperado el 19 de junio de 2025 de https://techxplore.com/news/2025-06-vision-language-automated-environments.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.