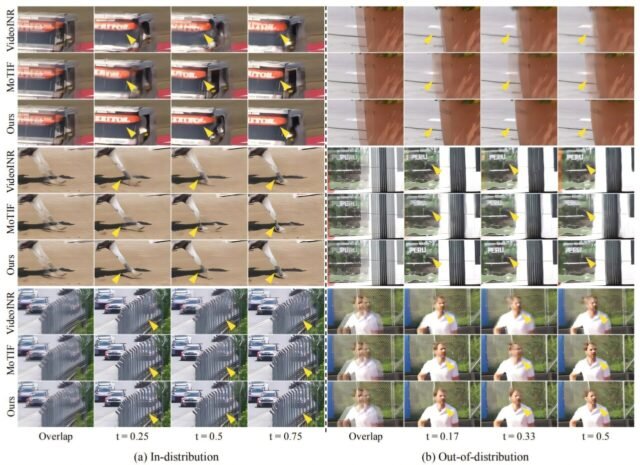

Comparación cualitativa en la interpolación temporal de escala arbitraria. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2501.11043

Un equipo de investigación, dirigido por el profesor Jaejun Yoo de la Escuela de Graduados de Inteligencia Artificial en Unist, ha anunciado el desarrollo de un modelo avanzado de inteligencia artificial (AI), “BF-STVSR (videos espacio-temporales basados en el flujo bidireccional)”, capaz de mejorar simultáneamente la resolución de videos y el marco.

Esta investigación fue dirigida por el primer autor Eunjin Kim, con Hyeonjin Kim como coautor. Sus hallazgos se presentaron en la conferencia sobre visión por computadora y reconocimiento de patrones (CVPR 2025) celebrado en Nashville del 11 al 15 de junio. El estudio es al corriente en el servidor de preimpresión ARXIV.

La resolución y la velocidad de cuadros son factores críticos que determinan la calidad del video. La mayor resolución da como resultado imágenes más nítidas con imágenes más detalladas, mientras que las tasas de cuadros aumentadas aseguran un movimiento más suave sin saltos abruptos.

Las técnicas tradicionales de restauración de video basadas en IA generalmente manejan la resolución y la mejora de la velocidad de cuadro por separado, dependiendo en gran medida de las redes de predicción de flujo óptico previamente capacitados para la estimación de movimiento. El flujo óptico calcula la dirección y la velocidad del movimiento del objeto para generar marcos intermedios. Sin embargo, este enfoque implica cálculos complejos y es propenso a errores acumulados, lo que limita tanto la velocidad como la calidad de la restauración de video.

Por el contrario, “BF-STVSR” introduce métodos de procesamiento de señal adaptados a las características de video, lo que permite que el modelo aprenda el movimiento bidireccional entre los cuadros de forma independiente, sin dependencia de las redes de flujo óptico externos. Al inferir conjuntamente los contornos de los objetos y el flujo de movimiento, el modelo mejora efectivamente la resolución y la velocidad de cuadro simultáneamente, lo que resulta en una reconstrucción de video más natural y coherente.

Aplicando este modelo de IA a videos de baja resolución y baja tasa de marco demostró un rendimiento superior en comparación con los modelos existentes, como lo demuestran las puntuaciones de una relación señal / ruido máxima (PSNR) e índice de similitud estructural (SSIM). Los valores elevados de PSNR y SSIM indican que incluso los videos con movimiento significativo conservan figuras y detalles humanos claros y no distorsionados, produciendo resultados más realistas.

El profesor Yoo explicó: “Esta tecnología tiene aplicaciones amplias, desde restaurar imágenes de cámaras de seguridad o grabaciones de caja negra capturadas con dispositivos de gama baja para mejorar rápidamente los videos de transmisión comprimidos para contenido de medios de alta calidad. También puede beneficiar a los campos como imágenes médicas y realidad virtual (VR)”.

Más información: Eunjin Kim et al, BF-STVSR: Splines B y los mejores amigos de Fourier para Video espacial-temporal de alta fidelidad Super-Resolución, ARXIV (2025). Doi: 10.48550/arxiv.2501.11043

Información en el diario: ARXIV

Proporcionado por unist

Cita: el modelo de IA se transforma en videos borrosos y entrecortados en imágenes claras y sin costuras (2025, 7 de julio) Recuperado el 7 de julio de 2025 de https://techxplore.com/news/2025-07-ai-blarry-choppy-videos-seamless.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.