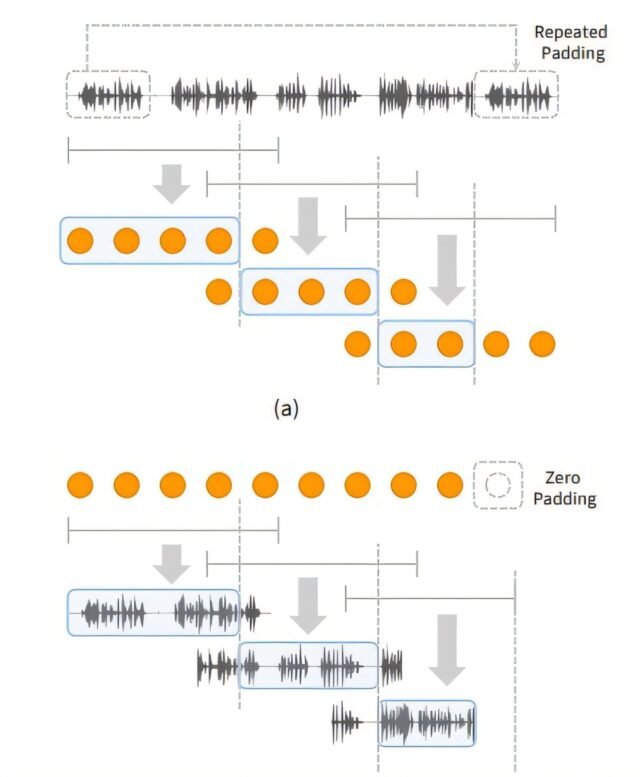

Estrategia de ventanas para (a) Tokenizing y (b) Decodificación del discurso de forma larga para permitir la extrapolación en las longitudes de decodificación. Crédito: ARXIV (2024). Doi: 10.48550/arxiv.2412.18603

Recientemente, los modelos de lenguaje hablado (SLM) se han destacado como tecnología de próxima generación que supera las limitaciones de los modelos de lenguaje basados en texto al aprender el habla humana sin texto para comprender y generar información lingüística y no lingüística.

Sin embargo, los modelos existentes muestran limitaciones significativas en la generación de contenido de larga duración requerido para podcasts, audiolibros y asistentes de voz.

Doctor en Filosofía. El candidato, Sejin Park, del equipo de investigación del profesor Yong Man Ro en la Escuela de Ingeniería Eléctrica del Instituto Avanzado de Ciencia y Tecnología de Corea, ha logrado superar estas limitaciones mediante el desarrollo de “discursos”, que permite una generación de voz consistente y natural sin restricciones de tiempo.

El trabajo ha sido publicado en el servidor de preprint arxiv y está configurado para presentarse como en ICML (Conferencia internacional sobre aprendizaje automático) 2025.

Una ventaja importante de SLM es su capacidad para procesar directamente el habla sin la conversión de texto intermedio, aprovechando las características acústicas únicas de los hablantes humanos, lo que permite la generación rápida de discursos de alta calidad incluso en modelos a gran escala.

Sin embargo, los modelos existentes enfrentaron dificultades para mantener la consistencia semántica y del altavoz para un discurso de larga duración debido al aumento de la “resolución del token del habla” y el consumo de memoria al capturar información muy detallada al romper el habla en fragmentos finos.

SpecheSSM emplea una “estructura híbrida” que coloca alternativamente “capas de atención” centradas en la información reciente y las “capas recurrentes” que recuerdan el flujo narrativo general (contexto a largo plazo). Esto permite que la historia fluya sin problemas sin perder coherencia incluso cuando se genera el discurso durante mucho tiempo.

Además, el uso de la memoria y la carga computacional no aumentan bruscamente con la longitud de entrada, lo que permite el aprendizaje estable y eficiente y la generación del habla de larga duración.

Los discursos procesan efectivamente las secuencias del habla ilimitadas dividiendo los datos del habla en unidades cortas y fijas (Windows), procesando cada unidad de forma independiente y luego combinándolas para crear un discurso largo.

Además, en la fase de generación de discursos, utiliza un modelo de síntesis de audio “no autorgresivo” (tormenta de sonido), que genera rápidamente múltiples partes a la vez en lugar de crear lentamente un carácter o una palabra a la vez, lo que permite la generación rápida de discursos de alta calidad.

Si bien los modelos existentes típicamente evaluaron modelos de habla cortos de aproximadamente 10 segundos, Se Jin Park creó nuevas tareas de evaluación para la generación del habla en función de su conjunto de datos de referencia autovolerado, “Librispeech-Long”, capaz de generar hasta 16 minutos de habla.

En comparación con las PPL (perplejidad), una métrica de evaluación del modelo de habla existente que solo indica la corrección gramatical, propuso nuevas métricas de evaluación como “SC-L (coherencia semántica a lo largo del tiempo” para evaluar la coherencia del contenido a lo largo del tiempo, y “N-MOS-T (puntaje de opinión significativa de naturalidad a lo largo del tiempo)” para evaluar la naturalidad a lo largo del tiempo, capacitando una evaluación más efectiva y precisa.

A través de estas nuevas evaluaciones, se confirmó que el discurso generado por el modelo de lenguaje hablado de SiscalsSM presentó consistentemente individuos específicos mencionados en el aviso inicial, y los nuevos personajes y eventos se desarrollaron de forma natural y contextualmente de manera consistente, a pesar de la generación de larga duración.

Esto contrasta fuertemente con los modelos existentes, que tenden a perder fácilmente su tema y exhibir repetición durante la generación de larga duración.

Sejin Park explicó: “Los modelos de lenguaje hablado existentes tenían limitaciones en la generación de larga duración, por lo que nuestro objetivo era desarrollar un modelo de lenguaje hablado capaz de generar un discurso de larga duración para el uso humano real”.

Agregó: “Se espera que este logro de investigación contribuya en gran medida a varios tipos de creación de contenido de voz y campos de IA de voz como asistentes de voz, manteniendo contenido consistente en contextos largos y respondiendo de manera más eficiente y rápida en tiempo real que los métodos existentes”.

Esta investigación, con Se Jin Park como el primer autor, se realizó en colaboración con Google Deepmind.

Más información: Se Jin Park et al, generación de voz de larga data con modelos de lenguaje hablado, ARXIV (2024). Doi: 10.48550/arxiv.2412.18603

Demo acompañante: Publicaciones de SpeocsSM.

Información en el diario: ARXIV

Proporcionado por el Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST)

Cita: el investigador desarrolla ‘discursos ssm,’ abriendo posibilidades para un asistente de voz de IA de 24 horas (2025, 4 de julio) recuperado el 4 de julio de 2025 de https://techxplore.com/news/2025-07-SPEECHSSMOPOSSIBITICIOS-HOU-AI-VOICE.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.