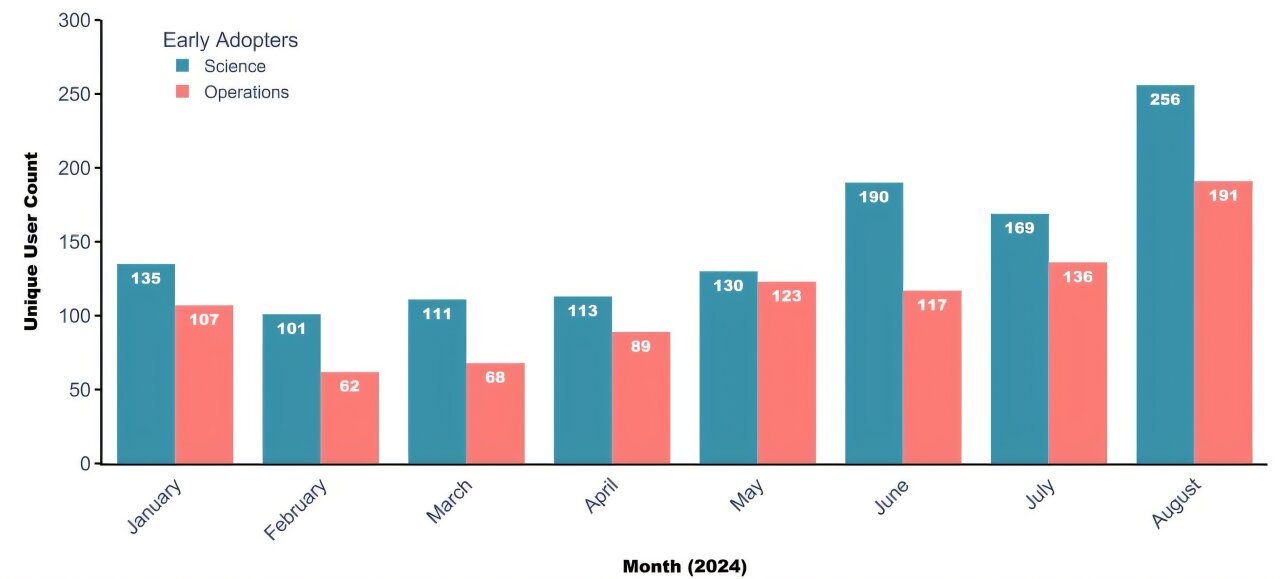

Métricas de uso de ARGO por operaciones y usuarios únicos de ciencias para cada mes desde la implementación inicial. El uso mensual es menos del 10% de todos los empleados de laboratorio. Nota: Este gráfico no captura el uso de los empleados de LLM externos y se basa en datos de telemetría recolectados automáticamente. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2501.16577

Los investigadores investigaron el uso de Argo de Argo por parte de los empleados de Argonne, un chatbot de inteligencia artificial generativo interno.

La inteligencia artificial generativa (IA) se está convirtiendo en una herramienta cada vez más poderosa en el lugar de trabajo. En organizaciones científicas como National Laboratories, su uso tiene el potencial de acelerar el descubrimiento científico en áreas críticas.

Pero con nuevas herramientas vienen nuevas preguntas. ¿Cómo pueden las organizaciones científicas implementar IA generativa de manera responsable? ¿Y cómo los empleados en diferentes roles utilizan IA generativa en su trabajo diario?

Un estudio reciente de la Universidad de Chicago y el Laboratorio Nacional de Argonne del Departamento de Energía de EE. UU. Proporciona uno de los primeros exámenes del mundo real de cómo las herramientas generativas de IA, específicamente grandes modelos de idiomas (LLM), se están utilizando en un entorno de laboratorio nacional.

El estudio no solo destaca el potencial de la IA para mejorar la productividad, sino que también enfatiza la necesidad de una integración reflexiva para abordar las preocupaciones en áreas como la privacidad, la seguridad y la transparencia. El documento se publica en el servidor ARXIV Preprint.

A través de encuestas y entrevistas, los investigadores estudiaron cómo los empleados de Argonne ya están usando LLM, y cómo imaginan usarlos en el futuro, para generar contenido y automatizar los flujos de trabajo. El estudio también rastreó la adopción temprana de ARGO, la interfaz LLM interna del laboratorio publicada en 2024. Según su análisis, los investigadores recomiendan formas en que las organizaciones pueden apoyar el uso efectivo de la IA generativa al tiempo que aborda los riesgos asociados.

El 26 de abril, el equipo presentó sus resultados en la Conferencia de CHI de la Asociación de Machinería de Computación de 2025 sobre factores humanos en sistemas informáticos en Japón.

Argonne y Argo, un estudio de caso

La estructura organizativa de Argonne combinada con la liberación oportuna de Argo hizo del laboratorio un entorno ideal para el estudio. Su fuerza laboral incluye trabajadores de ciencias e ingeniería, así como trabajadores de operaciones en áreas como recursos humanos, instalaciones y finanzas.

“La ciencia es un área donde la colaboración de la máquina humana puede conducir a avances significativos para la sociedad”, dijo Kelly Wagman, Ph.D. Estudiante en informática en la Universidad de Chicago y autor principal en el estudio. “Los trabajadores de la ciencia y las operaciones son cruciales para el éxito de un laboratorio, por lo que queríamos explorar cómo cada grupo se involucra con la IA y dónde se alinean y divergen sus necesidades”.

Si bien el estudio se centró en un laboratorio nacional, algunos de los hallazgos pueden extenderse a otras organizaciones como universidades, firmas de abogados y bancos, que tienen necesidades variadas de los usuarios y desafíos similares de seguridad cibernética.

Los empleados de Argonne trabajan regularmente con datos confidenciales, incluidos resultados científicos no publicados, documentos controlados no clasificados e información patentada. En 2024, el laboratorio lanzó ARGO, que brinda a los empleados acceso seguro a LLMS desde OpenAI a través de una interfaz interna. Argo no almacena ni comparte datos de usuarios, lo que lo convierte en una alternativa más segura a ChatGPT y otras herramientas comerciales.

Argo fue la primera interfaz de IA generativa interna que se desplegó en un laboratorio nacional. Durante varios meses después del lanzamiento de Argo, los investigadores rastrearon cómo se usó en diferentes partes del laboratorio. El análisis reveló una pequeña pero creciente base de usuarios de los trabajadores de la ciencia y las operaciones.

“La tecnología generativa de IA es nueva y rápidamente evoluciona, por lo que es difícil anticipar exactamente cómo las personas la incorporarán a su trabajo hasta que comiencen a usarla. Este estudio proporcionó comentarios valiosos que informan las próximas iteraciones en el desarrollo de Argo”, dijo el ingeniero de software de Argonne, Matthew Dearing, cuyo equipo desarrolla herramientas de IA para apoyar la misión del laboratorio.

Dearing, que tiene una cita conjunta en Uchicago, colaboró en el estudio con Wagman y Marshini Chetty, profesor de informática y líder del Laboratorio de Investigación de Internet de Amyoli en la Universidad.

Colaborando y automatizando con IA

Los investigadores encontraron que los empleados usaban IA generativa de dos maneras principales: como copiloto y como agente de flujo de trabajo. Como copiloto, la IA funciona junto con el usuario, ayudando con tareas como escribir código, estructurar texto o ajustar el tono de un correo electrónico. En su mayor parte, los empleados se adhieren actualmente a las tareas donde pueden verificar fácilmente el trabajo de la IA. En el futuro, los empleados informaron imaginar el uso de copilotos para extraer ideas de grandes cantidades de texto, como la literatura científica o los datos de la encuesta.

Como agente de flujo de trabajo, AI se usa para automatizar tareas complejas, que realiza principalmente por sí sola. Alrededor de una cuarta parte de las respuestas abiertas de la encuesta, divididas de manera uniforme entre las operaciones y los trabajadores científicos, la automatización del flujo de trabajo mencionado, pero los tipos de flujos de trabajo diferían entre los dos grupos. Por ejemplo, los trabajadores de operaciones utilizaron AI para automatizar procesos como buscar bases de datos o rastrear proyectos. Los científicos informaron automatizar los flujos de trabajo para procesar, analizar y visualizar datos.

“La ciencia a menudo implica flujos de trabajo muy a medida con muchos pasos. Las personas descubren que con LLM, pueden crear el pegamento para vincular estos procesos juntos”, dijo Wagman. “Este es solo el comienzo de flujos de trabajo automatizados más complicados para la ciencia”.

Expandir las posibilidades al mitigar los riesgos

Si bien la IA generativa presenta oportunidades emocionantes, los investigadores también enfatizan la importancia de la integración reflexiva de estas herramientas para gestionar los riesgos de la organización y abordar las preocupaciones de los empleados.

El estudio encontró que los empleados estaban significativamente preocupados por la confiabilidad generativa de la IA y su tendencia a alucinar. Otras preocupaciones incluyeron privacidad y seguridad de los datos, excesión excesiva en la IA, impactos potenciales en la contratación e implicaciones para la publicación científica y las citas.

Para promover el uso apropiado de la IA generativa, los investigadores recomiendan que las organizaciones administren de manera proactiva los riesgos de seguridad, establecen políticas claras y ofrezcan capacitación de empleados.

“Sin pautas claras, habrá mucha variabilidad en lo que la gente piensa que es aceptable”, dijo Chetty. “Las organizaciones también pueden reducir los riesgos de seguridad al ayudar a las personas a comprender lo que sucede con sus datos cuando usan herramientas internas y externas, ¿quién puede acceder a los datos? ¿Qué está haciendo la herramienta con él?”

En Argonne, casi 1.600 empleados han asistido a las sesiones generativas de capacitación de IA generativa del laboratorio. Estas sesiones presentan a los empleados Argo y AI generativo y brindan orientación para el uso apropiado.

“Sabíamos que si la gente se sentiría cómoda con Argo, no iba a suceder por sí solo”, dijo Dearing. “Argonne está liderando el camino para proporcionar herramientas generativas de IA y dar forma a la forma en que se integran de manera responsable en los laboratorios nacionales”.

Más información: Kelly B. Wagman et al, usos generativos de IA y riesgos para trabajadores del conocimiento en una organización científica, ARXIV (2025). Doi: 10.48550/arxiv.2501.16577

Información en la revista: ARXIV proporcionado por Argonne National Laboratory

Cita: El estudio explora cómo los trabajadores están utilizando modelos de idiomas grandes y qué significa para las organizaciones científicas (2025, 29 de abril) recuperado el 29 de abril de 2025 de https://techxplore.com/news/2025-04-explores-workers-large-language-science.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.