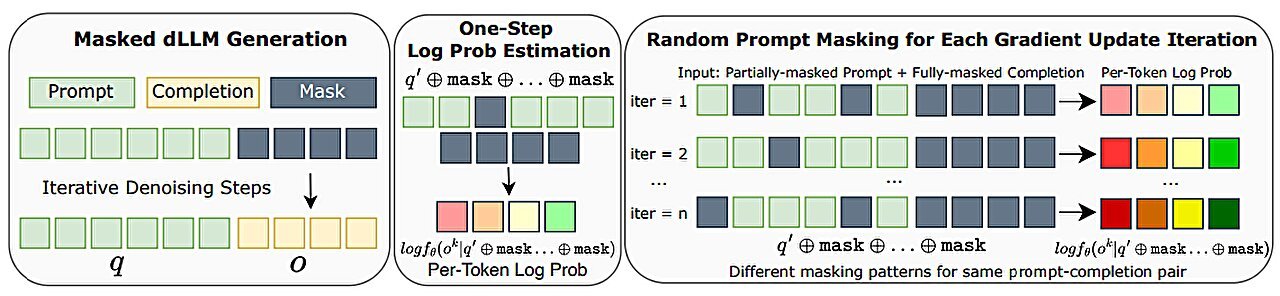

Estimación de probabilidad de registro en DIFFU-GRPO. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2504.12216

Un equipo de investigadores de IA en la Universidad de California, Los Ángeles, que trabaja con un colega de Meta AI, ha introducido D1, un marco basado en el modelo-lenguaje de difusión en general que se ha mejorado mediante el uso del aprendizaje de refuerzo. El grupo publicó un documento que describe su trabajo y características del nuevo marco en el servidor de preimpresión ARXIV.

En los últimos años, el uso de LLM se ha disparado, con millones de personas en todo el mundo utilizando aplicaciones de IA para una amplia variedad de aplicaciones. Esto ha llevado a una necesidad asociada de grandes cantidades de electricidad para alimentar los centros de datos que ejecutan las aplicaciones intensivas en computadora. Los investigadores han estado buscando otras formas de proporcionar servicios de IA a la comunidad de usuarios. Uno de estos enfoques implica el uso de DLLM como un enfoque de reemplazo o complementario.

Los LLM basados en difusión (DLLMS) son modelos AI que llegan a respuestas de manera diferente a las LLM. En lugar de adoptar el enfoque autorregresivo, usan la difusión para encontrar respuestas. Tales modelos se usaron originalmente para generar imágenes: se les enseñó cómo hacerlo agregando ruido abrumador a una imagen y luego entrenando el modelo para revertir el proceso hasta que no quedara nada más que la imagen original.

El uso de este enfoque para el texto implicó convertir letras o palabras a tokens como analógico para píxeles. El resultado fue un modelo que usó máscaras como análogo para que el ruido borre lentamente los tokens hasta que no quedara nada más que características de máscara, luego entrenando el modelo para revertir el proceso hasta que no hubo nada más que tokens. La ventaja de este enfoque es que puede requerir mucha menos potencia informática que las LLM.

En cuatro tareas de razonamiento matemático y lógico, D1-Llada, que sufre SFT seguido de nuestro Diffu-GRPO propuesto, supera constantemente el modelo base LLADA-8BINSTRUCT. Crédito: ARXIV (2025). Doi: 10.48550/arxiv.2504.12216

Mantener el uso de DLLM ha sido sus habilidades de razonamiento inferior. Ahí es donde entra el equipo en California. Han estado trabajando para agregar aprendizaje de refuerzo (donde los modelos aprenden mediante el uso de recompensas) a un DLLM como una forma de mejorar su capacidad de razonamiento.

Para construir D1, el equipo agregó un proceso de dos pasos. El primer paso involucró el ajuste fino supervisado del conjunto de datos de capacitación utilizando datos de alta calidad. El segundo utiliza el aprendizaje de refuerzo al agregar un algoritmo llamado Diffu-GRPO, que utiliza principios matemáticos para hacer estimaciones de alto nivel, junto con lo que el equipo llama “enmascaramiento rápido aleatorio”.

La prueba de D1 hasta ahora ha demostrado que el enfoque funciona: los modelos utilizando el marco superaron algunos puntos de referencia de razonamiento matemático y lógico. El equipo de investigación sugiere que su marco está listo para las pruebas de otras entidades que pueden optar por adaptar sus modelos de IA para incorporar los cambios que sugieren.

Más información: Siyan Zhao et al, D1: razonamiento de escala en modelos de lenguaje grande de difusión a través del aprendizaje de refuerzo, ARXIV (2025). Doi: 10.48550/arxiv.2504.12216

Información en el diario: ARXIV

© 2025 Science X Network

Cita: El aprendizaje de refuerzo aumenta las habilidades de razonamiento en el nuevo modelo de idioma basado en difusión D1 (2025, 30 de abril) Recuperado el 30 de abril de 2025 de https://techxplore.com/news/2025-04-poosts-skills-diffusion basado a base

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.