El agente de IA multimodal imita el pensamiento humano para el análisis y el razonamiento de videos largos

Crédito: Github: https://github.com/yeliudev/videomind

Mientras que la tecnología de inteligencia artificial (IA) está evolucionando rápidamente, los modelos de IA aún luchan por comprender videos largos. Un equipo de investigación de la Universidad Politécnica de Hong Kong (Polyu) ha desarrollado un nuevo agente en video en video, Videomind, que permite a los modelos de IA realizar largos razonamiento de videos y tareas de respuesta de preguntas al emular la forma de pensar de los humanos.

El marco de VideoMind incorpora una innovadora estrategia de adaptación de cadena de rango-rango (LORA) para reducir la demanda de recursos computacionales y energía, avanzando la aplicación de IA generativa en el análisis de video. Los hallazgos se han presentado a las conferencias de IA líderes mundiales.

Los videos, especialmente aquellos más de 15 minutos, llevan información que se desarrolla con el tiempo, como la secuencia de eventos, causalidad, coherencia y transiciones de escena. Para comprender el contenido de video, los modelos de inteligencia artificial, por lo tanto, necesitan no solo identificar los objetos presentes, sino también tener en cuenta cómo cambian a lo largo del video. A medida que las imágenes en los videos ocupan una gran cantidad de tokens, la comprensión de video requiere grandes cantidades de capacidad informática y memoria, lo que dificulta que los modelos de IA procesen videos largos.

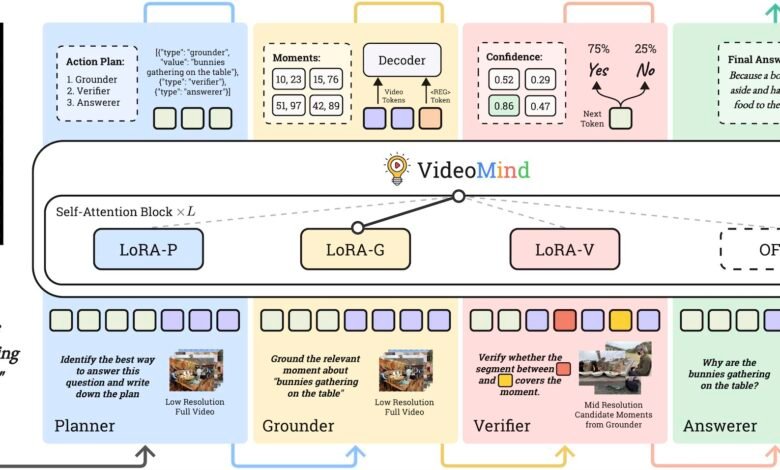

El profesor Changwen Chen, decano interino de la Facultad de Ciencias Matemáticas y Matemáticas de Polyu, y su equipo ha logrado un avance en la investigación sobre el razonamiento de video largo por IA. Al diseñar Videomind, hicieron referencia a un proceso de comprensión de video humano e introdujeron un flujo de trabajo basado en roles. Los cuatro roles incluidos en el marco son:

el planificador, para coordinar todos los demás roles para cada consulta; el terreno, para localizar y recuperar momentos relevantes; el verificador, para validar la precisión de la información de los momentos recuperados y seleccionar el más confiable; y el respondedor, para generar la respuesta consciente de la consulta.

Este enfoque progresivo para la comprensión de video ayuda a abordar el desafío del razonamiento de tierra temporal que enfrentan la mayoría de los modelos de IA.

Otra innovación central del marco Videomind radica en su adopción de una estrategia de cadena de lora. Lora es una técnica de sintonización que ha surgido en los últimos años. Adapta los modelos de IA para usos específicos sin realizar reentrenamiento de parámetro completo. La innovadora estrategia de cadena de lora pionera por el equipo implica aplicar cuatro adaptadores lora livianos en un modelo unificado, cada uno de los cuales está diseñado para llamar a un papel específico.

Crédito: VideoMind

Con esta estrategia, el modelo puede activar dinámicamente los adaptadores LORA específicos de roles durante la inferencia a través de la autocalación para cambiar sin problemas entre estos roles, eliminando la necesidad y el costo de implementar múltiples modelos al tiempo que mejora la eficiencia y la flexibilidad del modelo único.

Videomind es de código abierto en GitHub y Huggingface, y la investigación relacionada está disponible en el servidor ARXIV Preprint. Los detalles de los experimentos realizados para evaluar su efectividad en la comprensión de videos temporales en 14 puntos de referencia diversos también están disponibles. Comparando Videomind con algunos modelos de IA de última generación, incluidos GPT-4O y Gemini 1.5 Pro, los investigadores descubrieron que la precisión de la base de Videomind superó a todos los competidores en tareas desafiantes que involucran videos con una duración promedio de 27 minutos.

En particular, el equipo incluyó dos versiones de Videomind en los experimentos: uno con un modelo de parámetros más pequeño, 2 mil millones (2b), y otro con un modelo de parámetros más grande, 7 mil millones (7b). Los resultados mostraron que, incluso en el tamaño 2B, Videomind todavía produjo un rendimiento comparable con muchos de los otros modelos de tamaño 7B.

El profesor Chen dijo: “Los humanos cambian entre diferentes modos de pensamiento al comprender los videos: desglosar tareas, identificar momentos relevantes, volver a visitarlos para confirmar los detalles y sintetizar sus observaciones en respuestas coherentes. El proceso es muy eficiente con el cerebro humano usando solo unos 25 vatios de poder, que es un millón de veces más bajo que el de un supercomputador con una potencia informática equivalente.

“Inspirados por esto, diseñamos el flujo de trabajo basado en roles que permite a la IA comprender videos como humanos, al tiempo que aprovecha la estrategia de cadena de lora para minimizar la necesidad de calcular la potencia y la memoria en este proceso”.

La IA está en el núcleo del desarrollo tecnológico global. Sin embargo, el avance de los modelos de IA está limitado por una potencia informática insuficiente y un consumo excesivo de energía. Construido sobre un modelo unificado y de código abierto QWEN2-VL y aumentado con herramientas de optimización adicionales, el marco VideOmind ha reducido el costo tecnológico y el umbral para la implementación, ofreciendo una solución factible para el cuello de botella de reducir el consumo de energía en los modelos AI.

El Prof. Chen agregó: “VideoMind no solo supera las limitaciones de rendimiento de los modelos de IA en el procesamiento de videos, sino que también sirve como un marco de razonamiento multimodal modular, escalable e interpretable. Imaginamos que ampliará la aplicación de IA generativa a diversas áreas, como la vigilancia inteligente, el análisis de video deportivo y el entretenimiento, los motivos de búsqueda de video y más”.

Más información: Ye Liu et al, Videomind: un agente de cadena de lora para un razonamiento de video largo, ARXIV (2025). Doi: 10.48550/arxiv.2503.13444

Información en la revista: ARXIV proporcionado por la Universidad Politécnica de Hong Kong

Cita: el agente de IA multimodal imita el pensamiento humano para el análisis y el razonamiento de videos largos (2025, 10 de junio) Consultado el 10 de junio de 2025 de https://techxplore.com/news/2025-06-multi-modal-ai-agent-mimics.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.