Todos los ojos de IA podrían estar en GPT-5 esta semana, el último modelo de lenguaje grande de Openai. Pero mirando más allá de la exageración (y la decepción), hubo otro gran anuncio de Operai esta semana: GPT-OSS, un nuevo modelo de IA que puede ejecutar localmente en su propio dispositivo. Lo conseguí funcionando en mi computadora portátil y en mi iMac, aunque no estoy tan seguro de que te recomendaría que hagas lo mismo.

¿Cuál es el gran problema con GPT-OSS?

GPT-OSS es, como GPT-5, un modelo de IA. Sin embargo, a diferencia de la última y mejor LLM de Openai, GPT-OSS es “de peso abierto”. Eso permite a los desarrolladores personalizar y ajustar el modelo a sus casos de uso específicos. Sin embargo, es diferente del código abierto: OpenAI habría tenido que incluir tanto el código subyacente para el modelo como los datos en los que está entrenado el modelo. En cambio, la compañía simplemente está dando a los desarrolladores acceso a los “pesos” o, en otras palabras, los controles sobre cómo el modelo comprende las relaciones entre los datos.

No soy un desarrollador, así que no puedo aprovechar ese beneficio. Sin embargo, lo que puedo hacer con GPT-OSS que no puedo hacer con GPT-5 es ejecutar el modelo localmente en mi Mac. La gran ventaja allí, al menos para un usuario general como yo, es que puedo ejecutar un LLM sin conexión a Internet. Eso hace que esta quizás sea la forma más privada de usar un modelo Operai, teniendo en cuenta que la compañía aumenta todos los datos que genero cuando uso CHATGPT.

El modelo viene en dos formas: GPT-OSS-20B y GPT-OSS-120B. Este último es el LLM más potente y, como tal, está diseñado para funcionar en máquinas con al menos 80 GB de memoria del sistema. No tengo computadoras con casi esa cantidad de RAM, por lo que no 120b para mí. Afortunadamente, el mínimo de memoria de GPT-OSS-20B es de 16 GB: eso es exactamente cuánta memoria tiene mi M1 iMac, y dos gigabytes menos que mi M3 Pro MacBook Pro.

Instalación de GPT-oss en una Mac

La instalación de GPT-OSS es sorprendentemente simple en una Mac: solo necesita un programa llamado Ollamalo que le permite ejecutar a LLM localmente en su máquina. Una vez que descargue Ollama a su Mac, ábralo. La aplicación se parece esencialmente a cualquier otro chatbot que haya usado antes, solo que puede elegir entre una serie de diferentes LLM para descargar primero en su máquina. Haga clic en el selector de modelo junto al botón Enviar, luego busque “GPT-OSS: 20B”. Elija, luego envíe cualquier mensaje que desee activar una descarga. Necesitarás un poco más de 12 GB para la descarga, en mi experiencia.

Alternativamente, puede usar la aplicación Terminal de su Mac para descargar el LLM ejecutando el siguiente comando: Ollama Ejecutar GPT-OSS: 20B. Una vez que la descarga está completa, estás listo para comenzar.

Ejecutando GPT-oss en mis Macs

Con GPT-OSS-20B en mis dos Mac, estaba listo para ponerlos a prueba. Dejé casi todos mis programas activos para poner tantos recursos como sea posible para ejecutar el modelo. Las únicas aplicaciones activas fueron Ollama, por supuesto, pero también monitor de actividades, por lo que pude vigilar lo duro que se estaban ejecutando mis Mac.

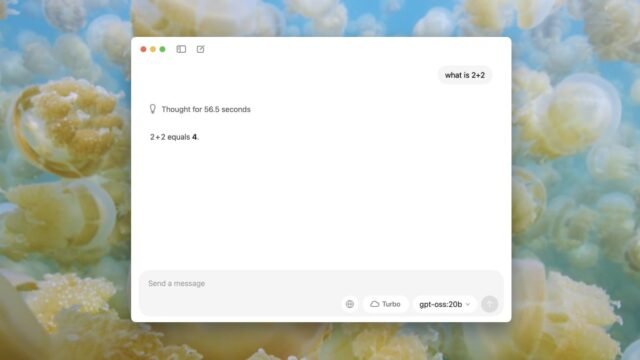

Empecé con uno simple: “¿Qué es 2+2?” Después de alcanzar el retorno de ambas palabras clave, vi burbujas de chat procesando la solicitud, como si Ollama estuviera escribiendo. También pude ver que el recuerdo de mis dos máquinas estaba siendo empujado al máximo.

Ollama en mi MacBook pensó en la solicitud de 5.9 segundos, escribiendo “El usuario pregunta: ‘Qué es 2+2’. Es una pregunta aritmética simple. La respuesta es 4. Debería responder simplemente. No se necesita más elaboración, pero podría responder cortésmente. Sin necesidad de un contexto adicional”. Luego respondió la pregunta. Todo el proceso tardó unos 12 segundos. Mi iMac, por otro lado, pensó durante casi 60 segundos, escribiendo: “El usuario pregunta: ‘Qué es 2+2’. Es una pregunta aritmética simple. La respuesta es 4. Debería responder simplemente. No se necesita más elaboración, pero podría responder cortésmente. Sin necesidad de un contexto adicional”. Tomó unos 90 segundos en total después de responder la pregunta. Eso es mucho tiempo para descubrir la respuesta a 2+2.

Luego, probé algo con lo que había visto a GPT-5 luchando: “¿Cuántas BS en Blueberry?” Una vez más, mi Macbook comenzó a generar una respuesta mucho más rápido que mi iMac, lo que no es inesperado. Si bien aún lento, se le ocurrió texto a un ritmo razonable, mientras mi iMac estaba luchando por sacar cada palabra. Me tomó mi MacBook aproximadamente 90 segundos en total, mientras que mi iMac tomó aproximadamente 4 minutos y 10 segundos. Ambos programas pudieron responder correctamente que hay, de hecho, dos BS en Blueberry.

Finalmente, le pregunté a ambos quién era el primer rey de Inglaterra. Es cierto que no estoy familiarizado con esta parte de la historia inglesa, así que supuse que esta sería una respuesta simple. Pero aparentemente es complicado, por lo que realmente hizo que el modelo pensara. Mi MacBook Pro tardó dos minutos en responder completamente la pregunta, es Æthelstan o Alfred el Grande, dependiendo de a quién le preguntes, mientras mi iMac tomó 10 minutos. Para ser justos, tardó un tiempo extra en nombrar a Kings de otros reinos antes de que Inglaterra se uniera bajo una sola bandera. Puntos por esfuerzo adicional.

¿Qué piensas hasta ahora?

GPT-OSS en comparación con chatgpt

Es evidente a partir de estas tres pruebas simples que el chip M3 Pro de mi MacBook y 2GB adicional de RAM aplastaron el chip M1 de mi iMac con 16 GB de RAM. Pero eso no debería darle demasiado crédito al MacBook Pro. Algunas de estas respuestas siguen siendo dolorosamente lentas, especialmente en comparación con la experiencia completa de ChatGPT. Esto es lo que sucedió cuando conecté estas mismas tres consultas en mi aplicación ChatGPT, que ahora ejecuta GPT-5.

Cuando se le preguntó “qué es 2+2”, Chatgpt respondió casi al instante.

Cuando se le preguntó “cuántas BS en Blueberry”, Chatgpt respondió en unos 10 segundos. (Parece que Operai ha solucionado el problema de GPT-5 aquí.)

Cuando se le preguntó “quién fue el primer rey de Inglaterra”, Chatgpt respondió en unos 6 segundos.

El bot tardó más en pensar a través de la pregunta de arándanos que considerar la compleja historia de la familia real de Inglaterra.

Probablemente no voy a usar mucho GPT-oss

No soy alguien que usa Chatgpt tanto en mi vida diaria, así que tal vez no soy el mejor tema de prueba para esta experiencia. Pero incluso si fuera un usuario ávido de LLM, GPT-OSS se ejecuta demasiado lento en mi hardware personal para que yo haya considerado usarlo a tiempo completo.

En comparación con mi iMac, GPT-OSS en mi MacBook Pro se siente rápido. Pero en comparación con la aplicación CHATGPT, GPT-oss se rastrea. En realidad, solo hay un área donde GPT-OSS brilla por encima de la experiencia completa de ChatGPT: la privacidad. No puedo evitar apreciar que, a pesar de que es lento, ninguna de mis consultas se envía a OpenAi, ni a nadie. Todo el procesamiento ocurre localmente en mi Mac, por lo que puedo estar seguro de todo lo que use el bot para los restos privados.

Eso en sí mismo podría ser una buena razón para recurrir a Ollama en mi MacBook Pro cada vez que siento la idea de usar IA. Realmente no creo que pueda molestarme en mi iMac, excepto quizás por revivir la experiencia de usar Internet en los años 90. Pero si su máquina personal es bastante poderosa, por ejemplo, una Mac con un chip Pro o Max y 32 GB de RAM o más, este podría ser lo mejor de ambos mundos. Me encantaría ver cómo GPT-OSS-20B escala en ese tipo de hardware. Por ahora, tendré que lidiar con lento y privado.

Divulgación: Ziff Davis, empresa matriz de Lifehacker, en abril presentó una demanda contra OpenAI, alegando que infringió los derechos de autor de Ziff Davis en la capacitación y la operación de sus sistemas de IA.