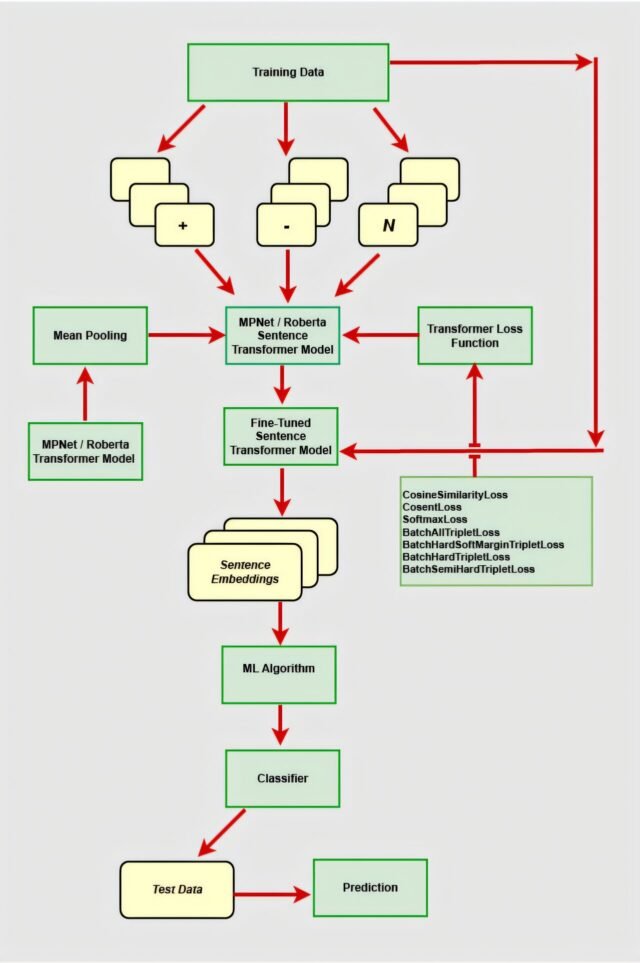

Esquema de nuestra tubería de análisis de sentimientos híbridos: los codificadores de transformadores generan incrustaciones de longitud fija que se alimentan en clasificadores de aprendizaje automático. Crédito: Procedia Computer Science (2025). Doi: 10.1016/j.procs.2025.03.161

La inteligencia artificial se está acelerando a la velocidad vertiginosa, con modelos más grandes que dominan la escena: más parámetros, más datos, más potencia. Pero aquí está la verdadera pregunta: ¿realmente necesitamos más grande para ser mejor? Desafiamos esa suposición haciendo una pregunta diferente: ¿cómo pueden las organizaciones extraer el sentimiento del cliente en tiempo real sin alquilar una granja de GPU? Cada tweet y revisión conlleva ideas procesables, pero ejecutar modelos de lenguaje masivo en cada entrada viene con costos computacionales y financieros empinados.

En nuestro reciente estudio publicado En Procedia Computer Science, preguntamos si las arquitecturas más delgadas podrían ofrecer una precisión comparable mientras reducía el tiempo de capacitación e inferencia. Descubrimos que los transformadores de oraciones ajustados combinados con clasificadores livianos no solo coinciden con el rendimiento de los modelos de idiomas grandes, a veces incluso excediéndolo, sino que también se ejecutan cómodamente en el hardware de los productos básicos. Este enfoque podría remodelar la economía del análisis de sentimientos.

Nuestro enfoque

Construimos nuestra tubería en dos potentes pero eficientes transformadores de transformadores: MPNET y Roberta-Large. Primero, convertimos cada oración de entrada en un vector de longitud fija mediante la medición media sobre sus incrustaciones de token. Esto transforma el texto en una representación semánticamente rica sin la sobrecarga del procesamiento de token-by-token. A continuación, ajustamos estos transformadores de oraciones directamente en los datos de sentimiento etiquetados.

Al aplicar las funciones de pérdida supervisadas, la cosinario y la cosencia para alinear pares de oraciones del mismo sentimiento, SoftmaxLoss para agudizar los límites de clase y las variantes de pérdida de triplete (Batchall, Batchhard, SoftMargin, Semihard) para empujar sentimientos diferentes, esculpimos el espacio incubado en el espacio abdido así tan positivo y negativo, lo que se cultiva naturalmente.

Con nuestros incrustaciones ajustadas en la mano, tratamos la clasificación de sentimientos como un problema clásico de aprendizaje automático. Alimentamos los vectores a clasificadores maduros (XGBOost (impulso de gradiente extremo), LightGBM (máquina de impulso de gradiente de luz) y SVM (máquinas de vectores de soporte)) se optimizan en el conjunto de entrenamiento para la precisión, precisión, recuperación y puntaje F.

Al desacoplar el transformador pesado ajustado de la clasificación rápida y tabular, minimizamos el tiempo de entrenamiento de extremo a extremo y reducimos los requisitos de memoria de tiempo de ejecución. Nuestro diseño modular permitirá a los investigadores cambiar su clasificador preferido sin reingeniería de la tubería de incrustación central.

Rendimiento de la evaluación comparativa

Para validar la tubería, la evaluamos en cuatro conjuntos de datos públicos. En el conjunto de datos de sentimientos de la aerolínea de Twitter de Twitter (TAS) de tres clases, nuestro mejor modelo, Roberta-Large con Cosinesimilarity, ajustado más xgboost, alcanzó el 88.4% de precisión y el recuerdo mejorado de la clase minoritaria por nueve puntos. En el conjunto de revisión de películas IMDB equilibrada, el mismo transformador: configuración de función de pérdida junto con SVM golpeó 95.9%. Luego probamos la generalización sin ajuste adicional: el modelo entrenado con TAS obtuvo un 88.5% en los tweets de Apple, y el modelo entrenado con IMDB logró un 94.8% en las revisiones Yelp.

Comparaciones con modelos de idiomas grandes

Benchando nuestro enfoque contra MetAllama-3-8B en la configuración sintonizada tanto en shot y Qlora (adaptador de bajo rango de bajo rango). En modo de disparo cero, Llama-3-8b logró solo aproximadamente un 50% de precisión, conjetura esencialmente aleatoria, en ambas tareas. Después de que Qlora ajuste a MetAllama-3-8B alcanzó una precisión del 85.9% en el conjunto de pruebas de la aerolínea y 97.1% en IMDB.

Mientras que LLAMA-3-8B superó nuestro modelo por 1.2 puntos en IMDB, requirió siete horas de tiempo de GPU en un Nvidia A100 y casi tres horas de inferencia para procesar los conjuntos de pruebas. Por el contrario, nuestra tubería completa entrenó de extremo a extremo en menos de cuatro horas y completó la inferencia en minutos en la misma configuración de hardware. En la tarea de la aerolínea, no solo superamos a LLAMA-3-8B por 2.5 puntos, sino que también entrenamos once veces más rápido.

Estos resultados subrayan que los transformadores de oraciones cuidadosamente ajustados más los clasificadores livianos pueden rivalizar con los LLM de parámetros pesados, a una fracción del costo computacional y financiero.

Democratización de AI

Al limitar el cálculo costoso a un solo paso de ajuste fino y aprovechar las bibliotecas maduras de ML (aprendizaje automático) para la clasificación, permitimos a los investigadores y desarrolladores hardware limitado para implementar un análisis de sentimientos de última generación. Ya sea que estemos ampliando el análisis de comentarios de los clientes o creando sistemas NLP ágiles para la implementación del mundo real, esta investigación muestra cómo las herramientas de código abierto y la ingeniería inteligente pueden democratizar el análisis de sentimientos utilizando inteligencia artificial.

Aún mejor, construimos una solución directa para distribuciones de sentimientos sesgados, no se requiere un aumento de datos adicional, por lo que el sistema equilibra naturalmente las clases minoritarias y ofrece un rendimiento confiable y escalable en la configuración del mundo real. Nuestro repositorio de código abierto hace que la replicación y la adaptación de dominio sean directas.

Conclusión

El análisis de sentimientos de alto rendimiento no necesita ser la provincia exclusiva de modelos de idiomas grandes enormes. A través del ajuste fino objetivo de los transformadores de oraciones y el uso juicioso de clasificadores livianos, hemos desbloqueado tuberías rápidas, precisas y generalizables que se ejecutan en hardware cotidiano. Mirando hacia el futuro, extenderemos este marco al modelado de temas y el resumen de temas, proporcionando a las organizaciones no solo con puntajes de sentimientos sino también con información concisa en tiempo real sobre las preocupaciones emergentes de los clientes, lo que realmente democratiza el análisis de sentimientos con IA.

Entonces, ¿qué significa esto para el futuro de AI? Modelos más inteligentes y eficientes que hacen que el análisis de sentimientos de alto rendimiento sea accesible, ya sea para información del cliente, moderación en tiempo real o IA ética.

Esta historia es parte de Diálogo de ciencias xdonde los investigadores pueden informar los resultados de sus artículos de investigación publicados. Visite esta página Para obtener información sobre el diálogo de Science X y cómo participar.

Más información: Agni Siddhanta et al, Sentiment Showdown – Los transformadores de oraciones se mantienen firmes contra los modelos de idiomas: Caso de clasificación de sentimientos utilizando incrustaciones de oraciones, Ciencias de la Computación de Procedimiento (2025). Doi: 10.1016/j. Procs. 20125.03.161

Agni Siddhanta es un reconocido científico de datos especializado en aprendizaje automático y IA. Tiene una EM en análisis de la Universidad Estatal de Georgia, EE. UU. Agni ha tenido roles significativos en organizaciones como Lexisnexis Risk Solutions y Mott MacDonald. Su reciente trabajo sobre transformadores de oraciones ajustados para la clasificación de sentimientos, publicado en Procedia Computer Science después de la aceptación en el 3er Taller Internacional sobre Innovación e Inteligencia Computacional Centucativa 2025, demuestra su talento para combinar tecnología de punta de corte con ideas centradas en el humano. Agni también contribuyó a la comunidad académica como revisor de Neurips 2024 y el Taller de Heal en Chi 2025, y como miembro del Comité Técnico para la 18ª Conferencia Internacional sobre Teoría e Ingeniería de Computaciones Avanzadas (Icacte 2025). Su liderazgo de la industria y su participación académica subrayan su compromiso de avanzar en la investigación de IA y la implementación de soluciones accesibles y escalables.

Cita: Análisis de sentimientos con pueblo democratizante (2025, 21 de julio) Recuperado el 21 de julio de 2025 de https://techxplore.com/news/2025-07-democratizating-ai-powered-sentiment-analysis.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.