Crédito: Actas de la 31ª Conferencia SIGKDD de ACM sobre Discovery de Conocimiento y Minería de Datos V.2 (2025). Doi: 10.1145/3711896.3736964

Junto con los modelos de idiomas grandes basados en texto (LLM), incluido el CHATGPT en campos industriales, los modelos de IA gráficos basados en GNN (red neuronal) que analizan datos no estructurados, como transacciones financieras, acciones, redes sociales y registros de pacientes en forma gráfica. Sin embargo, hay una limitación, en ese aprendizaje de gráfico completo, que capacita todo el gráfico a la vez, requiere memoria masiva y servidores GPU.

Un equipo de investigación de Kaist ahora ha logrado desarrollar tecnología de software que pueda capacitar a los modelos GNN a gran escala a una velocidad máxima utilizando solo un solo servidor de GPU. El estudio es publicado En las actas de la 31ª Conferencia SIGKDD de ACM sobre Discovery de Conocimiento y Minería de Datos V.2.

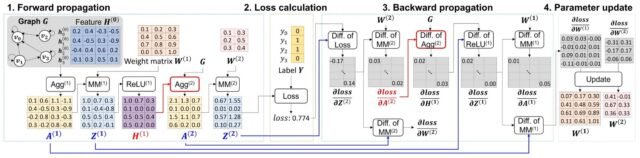

El equipo de investigación, dirigido por el profesor Min-Soo Kim de la Escuela de Computación, desarrolló FlexGnn, un sistema GNN que, a diferencia de los métodos existentes que utilizan múltiples servidores de GPU, pueden entrenar rápidamente e inferir modelos de IA de grifos a gran escala en un solo servidor de GPU. FlexGnn mejora la velocidad de entrenamiento hasta 95 veces en comparación con las tecnologías existentes.

Recientemente, en varios campos, como el clima, las finanzas, la medicina, los productos farmacéuticos, la fabricación y la distribución, ha habido un número creciente de casos en los que los datos se convierten en forma gráfica, que consiste en nodos y bordes, para análisis y predicción.

Si bien el enfoque de gráfico completo, que utiliza todo el gráfico para el entrenamiento, logra una mayor precisión, tiene el inconveniente de la memoria frecuente debido a la generación de datos intermedios masivos durante el entrenamiento, así como tiempos de entrenamiento prolongados causados por la comunicación de datos entre múltiples servidores.

Para superar estos problemas, FlexGnn realiza una capacitación de modelo AI óptima en un solo servidor de GPU utilizando SSD (unidades de estado sólido) y memoria principal en lugar de múltiples servidores de GPU.

A través de la capacitación en optimización de consultas AI, que optimiza la calidad de los sistemas de bases de datos, el equipo desarrolló una nueva tecnología de optimización de entrenamiento que calcula los parámetros del modelo, los datos de entrenamiento y los datos intermedios entre GPU, memoria principal y capas SSD en el momento y el método óptimos.

Como resultado, Flexgnn genera flexible planes de ejecución de capacitación óptimos de acuerdo con los recursos disponibles, como el tamaño de los datos, la escala de modelo y la memoria de GPU, logrando así una alta eficiencia de recursos y velocidad de capacitación.

En consecuencia, se hizo posible capacitar a los modelos GNN en datos que exceden con creces la capacidad de memoria principal, y la capacitación podría ser hasta 95 veces más rápido incluso en un solo servidor de GPU. En particular, la realización de AI de gráfico completo, capaz de un análisis más preciso que las supercomputadoras en aplicaciones como la predicción climática, se ha convertido en una realidad.

El profesor Kim declaró: “Como los modelos GNN de grano completo se utilizan activamente para resolver problemas complejos, como la predicción del clima y el nuevo descubrimiento de materiales, la importancia de las tecnologías relacionadas está aumentando”.

Agregó: “Dado que FlexGnn ha resuelto drásticamente los problemas de larga data de la escala de entrenamiento y la velocidad en los modelos de IA gráficos, esperamos que se use ampliamente en varias industrias”.

En esta investigación, Jeongmin Bae, un estudiante de doctorado en la Escuela de Computación de Kaist, participó como el primer autor, Dongyoung Han, CTO de Graprai Co. (fundado por el profesor Kim) participó como el segundo autor, y el profesor Kim se desempeñó como autor correspondiente.

Más información: Jeongmin Bae et al, Flexgnn: un sistema GNN de alto rendimiento y a gran escala completa con optimización del plan de entrenamiento de mejor esfuerzo, procedimientos de la 31ª Conferencia SIGKDD ACM sobre Discovery de Conocimiento y Minería de datos V.2 (2025). Doi: 10.1145/3711896.3736964

Proporcionado por el Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST)

Cita: el modelo de análisis de gráficos AI logra el entrenamiento hasta 95 veces más rápido en una sola GPU (2025, 15 de agosto) Recuperado el 15 de agosto de 2025 de https://techxplore.com/news/2025-08-graph-analysis-ai-faster-gu.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.