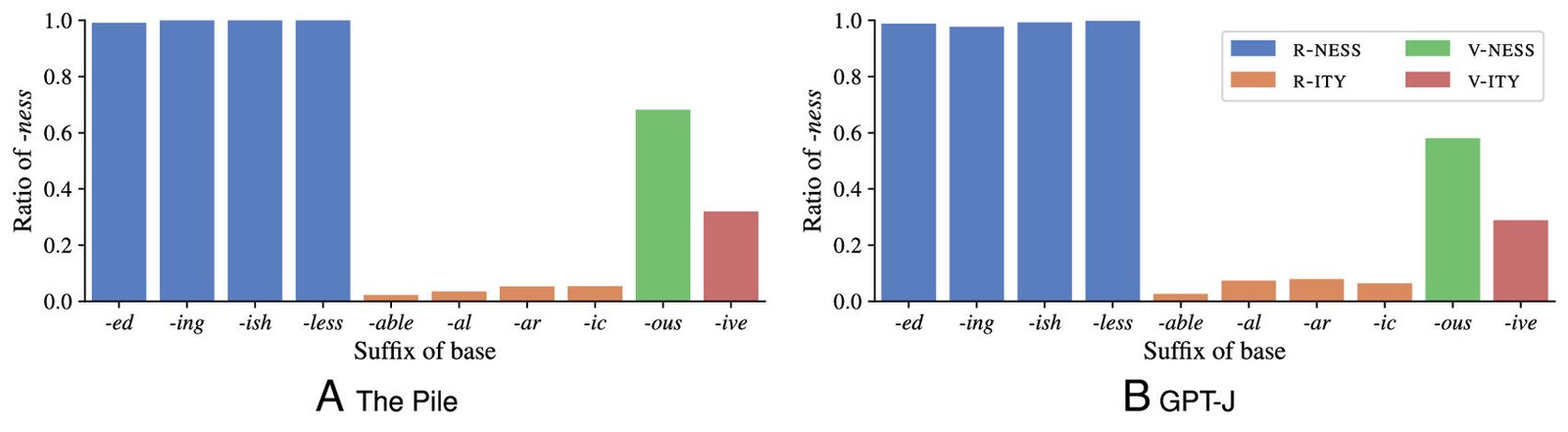

Ratio de bases que prefieren “-ness” en las predicciones de la pila (A) y GPT-J con un indicador de ejemplo (B). Los resultados son similares para las otras indicaciones. Los sufijos de la base (es decir, clases de adjetivos) se agrupan por grado de competencia entre “-ity” y “-ness”. Crédito: Actas de la Academia Nacional de Ciencias (2025). Doi: 10.1073/pnas.2423232122

Un nuevo estudio dirigido por investigadores de la Universidad de Oxford y el Instituto Allen para AI (AI2) ha encontrado que los modelos de idiomas grandes (LLM), los sistemas de IA detrás de los chatbots como ChatGPT, dennican los patrones de idiomas de una manera sorprendentemente humana: a través de la analogía, en lugar de las estrictas reglas gramaticales.

El trabajo se publica en la revista Actas de la Academia Nacional de Ciencias.

La investigación desafía una suposición generalizada sobre LLM: que aprenden a generar lenguaje principalmente inferiendo reglas de sus datos de capacitación. En cambio, los modelos dependen en gran medida de los ejemplos almacenados y dibujan analogías al tratar con palabras desconocidas, al igual que la gente.

Para explorar cómo las LLM generan el lenguaje, el estudio comparó los juicios realizados por los humanos con los realizados por GPT-J (un modelo de lenguaje grande de código abierto desarrollado por Eleutherai en 2021) en un patrón de formación de palabras muy común en inglés, que convierte los adjetivos en sustantivos al agregar el sufijo “-ness” o “-ity”. Por ejemplo, “feliz” se convierte en “felicidad” y “disponible” se convierte en “disponibilidad”.

El equipo de investigación generó 200 adjetivos ingleses inventados que el LLM nunca había encontrado antes, palabras como “Cormasive” y “Friquish”. Se le pidió a GPT -J que convirtiera a cada uno en un sustantivo eligiendo entre -ness y -ity (por ejemplo, decidiendo entre “cormasividad” y “cormasividad”). Las respuestas de la LLM se compararon con las opciones realizadas por las personas y con las predicciones hechas por dos modelos cognitivos bien establecidos. Un modelo se generaliza el uso de reglas, y otro utiliza razonamiento analógico basado en la similitud con los ejemplos almacenados.

Los resultados revelaron que el comportamiento de la LLM se parecía al razonamiento analógico humano. En lugar de usar las reglas, basó sus respuestas en similitudes con palabras reales que había encontrado durante el entrenamiento, al igual que la gente al pensar en nuevas palabras. Por ejemplo, “Friquish” se convierte en “frustres” sobre la base de su similitud con palabras como “egoísta”, mientras que el resultado de “cormasivo” está influenciado por pares de palabras como sensible, sensibilidad.

El estudio también encontró influencias generalizadas y sutiles de la frecuencia con la que los formularios de palabras habían aparecido en los datos de entrenamiento. Las respuestas de la LLM en casi 50,000 adjetivos ingleses reales fueron sondeadas, y sus predicciones coincidían con los patrones estadísticos en sus datos de entrenamiento con una precisión sorprendente. El LLM se comportó como si hubiera formado una traza de memoria de cada ejemplo individual de cada palabra que ha encontrado durante el entrenamiento. Basándose en estos recuerdos almacenados para tomar decisiones lingüísticas, parecía manejar cualquier cosa nueva preguntándose: “¿A qué me recuerda esto?”

El estudio también reveló una diferencia clave entre cómo los seres humanos y los LLM forman analogías sobre ejemplos. Los humanos adquieren un diccionario mental, una tienda mental de todas las formas de palabras que consideran palabras significativas en su idioma, independientemente de la frecuencia con la que ocurran. Reconocen fácilmente que las formas como Friquish y Cormasive no son palabras de inglés en este momento. Para lidiar con estos neologismos potenciales, hacen generalizaciones analógicas basadas en la variedad de palabras conocidas en sus diccionarios mentales.

Los LLM, en contraste, se generalizan directamente sobre todas las instancias específicas de palabras en el conjunto de entrenamiento, sin unificar instancias de la misma palabra en una sola entrada de diccionario.

La autora senior Janet Pierrehumbert, profesora de modelado de idiomas en la Universidad de Oxford, dijo: “Aunque los LLM pueden generar lenguaje de una manera muy impresionante, resulta que no piensan tan abstractamente como lo hacen los humanos. Esto probablemente contribuye al hecho de que su entrenamiento requiere muchos más datos de idiomas que los humanos que deben aprender un idioma”.

El co-líder, el Dr. Valentin Hofman (AI2 y la Universidad de Washington) dijo: “Este estudio es un gran ejemplo de sinergia entre la lingüística y la IA como áreas de investigación. Los resultados nos dan una imagen más clara de lo que está sucediendo dentro de las LLM cuando generan lenguaje, y apoyarán los avances futuros en la IA robusta, eficiente y explicable”.

El estudio también involucró a investigadores de LMU Munich y la Universidad Carnegie Mellon.

Más información: Valentin Hofmann et al, la morfología derivada revela una generalización analógica en modelos de idiomas grandes, Actas de la Academia Nacional de Ciencias (2025). Doi: 10.1073/pnas.2423232122

Proporcionado por la Universidad de Oxford

Cita: Al igual que los humanos, ChatGPT favorece ejemplos y ‘recuerdos’, no reglas, para generar lenguaje (2025, 12 de mayo) recuperado el 12 de mayo de 2025 de https://techxplore.com/news/2025-05-humans-chatgpt-favors-examples-memories.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.