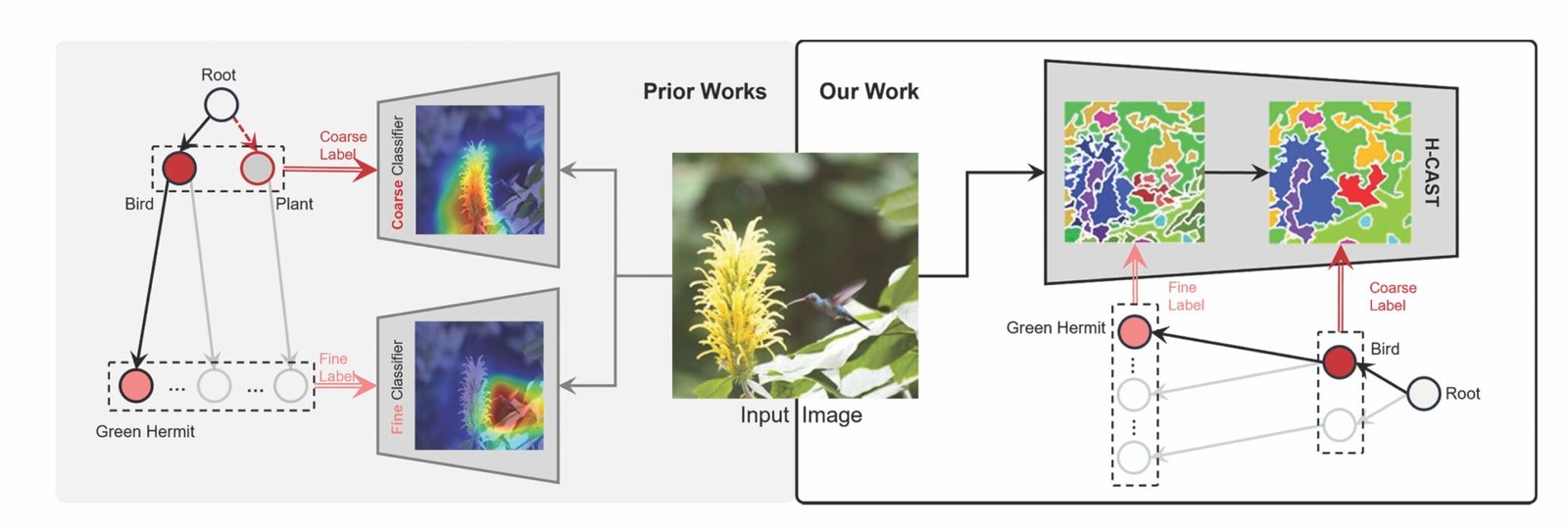

El nuevo modelo de visión por computadora, H-Cast, alinea clasificadores gruesos y de grano fino utilizando segmentación intraimagen. Los modelos anteriores tratan los niveles finos y gruesos como tareas separadas, lo que lleva a errores en los que el clasificador fino predice una especie de aves, mientras que el clasificador grueso predice “planta”. Crédito: Park et al., 2025

Un nuevo modelo de IA, H-Cast, agrupa detalles finos en conceptos a nivel de objeto a medida que la atención se mueve de capas más bajas a altas, produciendo un árbol de clasificación, como pájaro, águila, águila calva, en lugar de centrarse solo en el reconocimiento de grano fino.

La investigación se presentó en la Conferencia Internacional sobre Representaciones de Aprendizaje en Singapur y se basa en el modelo anterior del equipo, el elenco, la contraparte para la clasificación de nivel único visualmente fundamental. El documento también se publica en el servidor ARXIV Preprint.

Si bien algunos argumentan que el aprendizaje profundo puede proporcionar una clasificación de grano fino e inferir categorías más amplias, esta táctica solo funciona con imágenes claras.

“Las aplicaciones del mundo real implican muchas imágenes imperfectas. Si un modelo solo se centra en la clasificación de grano fino, se da por vencido antes de que incluso comience en imágenes que no tienen suficiente información para respaldar ese nivel de detalle”, dijo Stella Yu, profesora de informática e ingeniería en UM y autor contribuyente del estudio.

La clasificación jerárquica supera este problema, proporcionando clasificación en múltiples niveles de detalle para la misma imagen. Sin embargo, hasta este punto, los modelos jerárquicos han luchado con inconsistencias que conlleva el tratamiento de cada nivel como su propia tarea de clasificación.

Por ejemplo, al identificar un ave, la clasificación de grano fino a menudo depende de detalles locales como la forma del pico o el color de las plumas, mientras que las etiquetas gruesas requieren características globales como la forma general. Cuando estos dos niveles se desconectan, puede dar como resultado un clasificador fino que predice el “periquito verde”, mientras que el clasificador grueso predice “planta”.

En cambio, el nuevo modelo enfoca todos los niveles en el mismo objeto en diferentes niveles de detalle al alinear las predicciones finas a coarses a través de la segmentación intraimagen.

Modelos jerárquicos anteriores entrenados de grueso a específico, centrándose en la lógica del etiquetado semántico que fluye de general a específico (por ejemplo, pájaro, colibrí, ermitaño verde). H-CAST en su lugar, entrena en el espacio visual donde el reconocimiento comienza con detalles finos como picos y alas que están compuestas de estructuras más gruesas, lo que lleva a una mejor alineación y precisión.

“La mayoría del trabajo previo en la clasificación jerárquica se centró solo en la semántica, pero descubrimos que la base visual consistente a través de los niveles puede marcar una gran diferencia. Al alentar a los modelos a” ver “la jerarquía de una manera visualmente coherente, esperamos que este trabajo inspire un cambio hacia los sistemas de reconocimiento más integrados e interpretables”, dijo Seulki Park, un compañero de Investigación PostDoctoral de la Universidad de la Universidad de la Universidad de Michigan y lidera a los sistemas de reconocimiento de Seulki.

A diferencia de los métodos anteriores, el equipo de investigación aprovechó la segmentación no supervisada, utilizada típicamente para identificar estructuras dentro de una imagen más grande, para apoyar la clasificación jerárquica. Demuestran que su mecanismo de agrupación visual se puede aplicar de manera efectiva a la clasificación sin requerir etiquetas a nivel de píxel y ayuda a mejorar la calidad de la segmentación.

Para demostrar la efectividad del nuevo modelo, H-CAST se probó en cuatro conjuntos de datos de referencia y se comparó con modelos jerárquicos (FGN, HRN. TransHP, Hier-VIT) y de base (Vit, Cast, HIE).

“Nuestro modelo superó a un clip de disparo cero y líneas de base de última generación en puntos de referencia de clasificación jerárquica, logrando una mayor precisión y predicciones más consistentes”, dijo Yu.

Por ejemplo, en el conjunto de datos de las razas, la precisión de H-Cast de H-Cast fue un 6% más alta que el estado de arte anterior y un 11% más alto que las líneas de base.

El análisis de vecinos más cercanos a nivel de características también muestra muestras de H-Cast, semántica y visualmente consistente a través de los niveles de jerarquía, a diferencia de los modelos anteriores que a menudo recuperan muestras visualmente similares pero semánticamente incorrectas.

Este trabajo podría aplicarse a cualquier situación que requiera una comprensión de las imágenes de varios niveles. Podría beneficiar particularmente al monitoreo de la vida silvestre, identificando especies donde sea posible, pero recurrir a predicciones más gruesas. H-CAST también puede ayudar a los vehículos autónomos a interpretar la entrada visual imperfecta como peatones ocluidos o vehículos distantes, lo que ayuda al sistema a tomar decisiones seguras y aproximadas en niveles de detalle más gruesos.

“Los humanos naturalmente recurren a conceptos más gruesos. Si no puedo decir si una imagen es de un corgi de Pembroke, todavía puedo decir con confianza que es un perro. Pero los modelos a menudo fallan en ese tipo de razonamiento flexible. Esperamos eventualmente construir un sistema que pueda adaptar su nivel de predicción como lo hacemos”, dijo Park.

H-CAST fue entrenado y probado utilizando la computación de alto rendimiento de ARC en UM.

UC Berkeley, MIT y fundaciones escaladas también contribuyeron a esta investigación.

Más información: Seulki Park, et al. Clasificación de imagen jerárquica visualmente consistente. Conferencia internacional sobre representaciones de aprendizaje (2025).

Seulki Park et al, clasificación de imágenes jerárquicas visualmente consistentes, ARXIV (2024). Doi: 10.48550/arxiv.2406.11608

Información en la revista: ARXIV proporcionado por la Universidad de Michigan College of Engineering

Cita: la visión por computadora identifica imágenes con un árbol de clasificación, que incluye categorías amplias y específicas (2025, 14 de mayo) recuperada el 14 de mayo de 2025 de https://techxplore.com/news/2025-05-vision-images-classification-tree-broad.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.