Crédito: dominio público Unsplash/CC0

El problema es simple: es difícil saber si una foto es real o no. Las herramientas de manipulación de fotos son tan buenas, tan comunes y fáciles de usar, que la veracidad de una imagen ya no está garantizada.

La situación se volvió más complicada con la aceptación de la inteligencia artificial generativa. Cualquier persona con conexión a Internet puede cocinar casi cualquier imagen, plausible o fantasía, con calidad fotorrealista, y presentarla como real. Esto afecta nuestra capacidad de discernir la verdad en un mundo cada vez más influenciado por las imágenes.

Enseño e investigo la ética de la inteligencia artificial (AI), incluida la forma en que usamos y entendemos las imágenes digitales.

Muchas personas preguntan cómo podemos saber si se ha cambiado una imagen, pero eso se está volviendo demasiado difícil. En cambio, aquí sugiero un sistema donde los creadores y usuarios de imágenes indican abiertamente qué cambios han realizado. Cualquier sistema similar servirá, pero se necesitan nuevas reglas si las imágenes de IA se implementarán éticamente, al menos entre los que desean ser confiables, especialmente los medios de comunicación.

No hacer nada no es una opción, porque lo que creemos sobre los medios afecta cuánto confiamos entre nosotros y nuestras instituciones. Hay varias maneras hacia adelante. El etiquetado claro de las fotos es una de ellas.

Deepfakes y noticias falsas

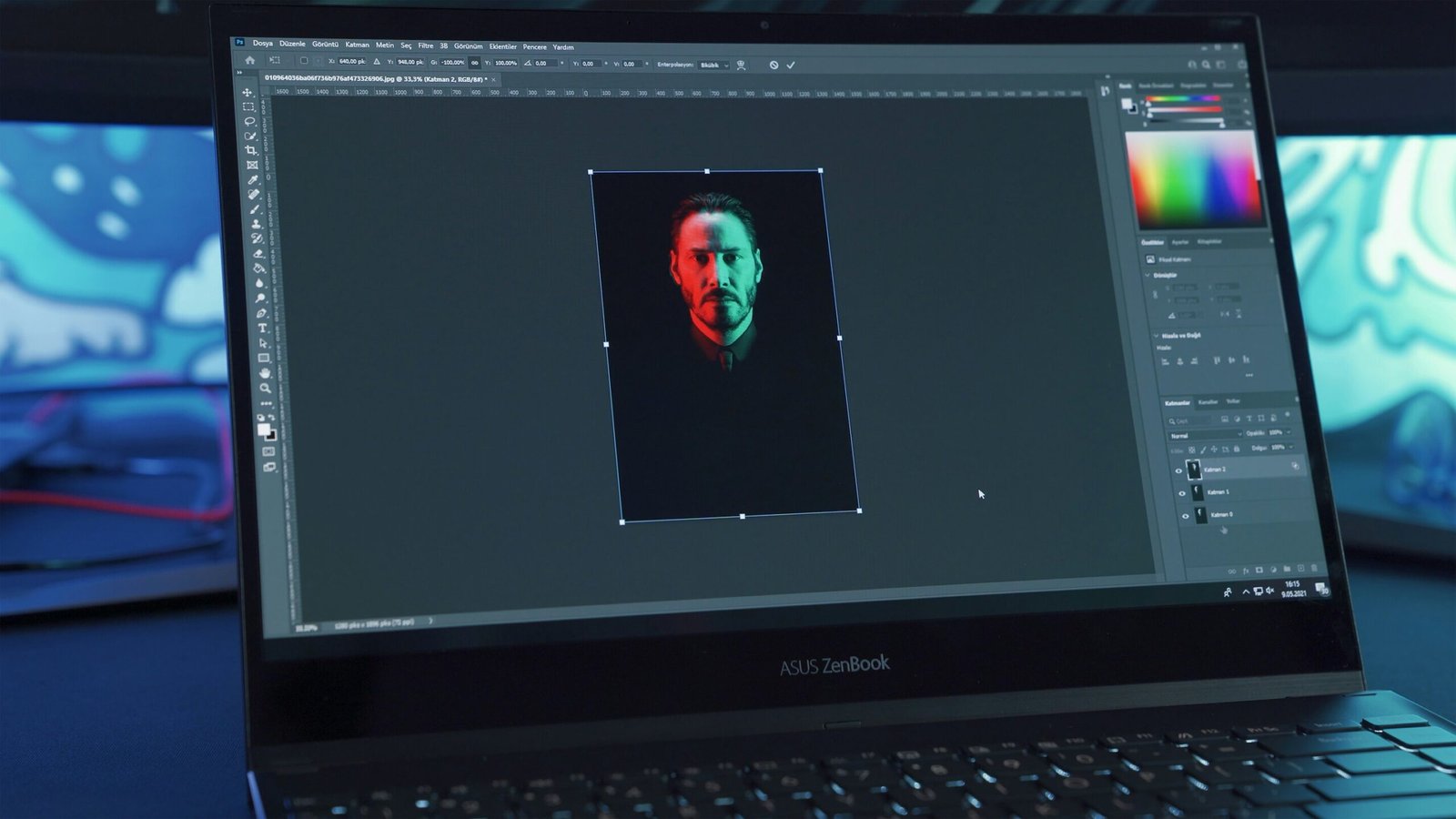

La manipulación de fotos fue una vez la reserva de los equipos de propaganda gubernamental, y más tarde, usuarios expertos de Photoshop, el software popular para editar, alterar o crear imágenes digitales.

Hoy, las fotos digitales se someten automáticamente a filtros de corrección de colores en teléfonos y cámaras. Algunas herramientas de redes sociales “prettifiquen” las imágenes de las caras de los usuarios. ¿Una foto ya tomada de uno mismo por uno mismo es real?

La base de la comprensión social compartida y el consenso, la confianza con respecto a lo que se ve, se está erosionando. Esto se acompaña del aparente ascenso de informes de noticias poco confiables (y a menudo maliciosos). Tenemos un nuevo lenguaje para la situación: noticias falsas (informes falsos en general) y defensores (imágenes manipuladas deliberadamente, ya sea para librar la guerra o obtener más seguidores en las redes sociales).

Las campañas de información errónea que utilizan imágenes manipuladas pueden influir en las elecciones, profundizar las divisiones, incluso incitar a la violencia. El escepticismo hacia los medios confiables no ha atado a la gente común de la contabilidad basada en hechos de los eventos, y ha alimentado teorías de conspiración y grupos marginales.

Preguntas éticas

Otro problema para los productores de imágenes (personales o profesionales) es la dificultad de saber lo que está permitido. En un mundo de imágenes manipuladas, ¿es aceptable prettificarse? ¿Qué tal editar a un ex pareja de una foto y publicarla en línea?

¿Sería importante si un periódico occidental muy respetado publicara una foto del presidente ruso Vladimir Putin tirando de su rostro con disgusto (una expresión que seguramente ha hecho en algún momento, pero de la cual no se ha capturado ninguna imagen real, por ejemplo) usando IA?

Los límites éticos se difuminan aún más en contextos altamente cargados. ¿Importa si los anuncios políticos de la oposición contra el entonces candidato presidencial Barack Obama en los Estados Unidos oscurecieron deliberadamente su piel?

¿Las imágenes generadas de cadáveres en Gaza serían más sabrosos, quizás más morales, que las fotografías reales de humanos muertos? ¿Una portada de la revista muestra un modelo alterado digitalmente a los estándares de belleza inalcanzables, sin declarar el nivel de manipulación de fotos, poco ético?

Una solución

Parte de la solución a este problema social exige dos acciones simples y claras. Primero, declare que ha tenido lugar la manipulación de fotos. En segundo lugar, revele qué tipo de manipulación de fotos se realizó.

El primer paso es sencillo: de la misma manera, las imágenes se publican con créditos de autor, un “reconocimiento de mejora” claro y discreto debe agregarse a las líneas de subtítulos.

El segundo es sobre cómo se ha alterado una imagen. Aquí pido cinco “categorías de manipulación” (no muy diferente a una calificación de película). La responsabilidad y la claridad crean una base ética.

Las cinco categorías podrían ser:

C – corregido

Ediciones que preservan la esencia de la foto original mientras refinan su claridad general o atractivo estético, como el equilibrio de color (como el contraste) o la distorsión de la lente. Dichas correcciones a menudo se automatizan (por ejemplo, por las cámaras de teléfonos inteligentes) pero se pueden realizar manualmente.

E – mejorado

Alteraciones que se tratan principalmente de ajustes de color o tono. Esto se extiende a un ligero retoque cosmético, como la eliminación de imperfecciones menores (como el acné) o la adición artificial de maquillaje, siempre que las ediciones no remodelen las características u objetos físicos. Esto incluye todos los filtros que involucran cambios en el color.

B – cuerpo manipulado

Esto se marca cuando se altera una característica física. Los cambios en la forma del cuerpo, como los brazos adelgazantes o los hombros en agrandamiento, o la alteración del color de la piel o el cabello, caen en esta categoría.

O – Objeto manipulado

Esto declara que se ha cambiado la posición física de un objeto. Se movió un dedo o una extremidad, un jarrón, una persona editada, un elemento de fondo agregado o eliminado.

G – Generado

Las representaciones totalmente fabricadas pero fotorrealistas, como una escena que nunca existió, deben marcarse aquí. Entonces, todas las imágenes creadas digitalmente, incluso por IA generativa, pero limitadas a representaciones fotográficas. (Se excluiría una caricatura generada por IA del Papa, pero una imagen fotográfica del pontífice en una chaqueta de tope está clasificada G.)

Las categorías sugeridas son daltón de valor: están (o deberían ser) desencadenadas simplemente por la ocurrencia de cualquier manipulación. Entonces, los filtros de color se aplican a una imagen de un político desencadenan una categoría E, si la alteración hace que la persona parezca más amigable o aterradora. Una característica crítica para aceptar un sistema de calificación como este es que es transparente e imparcial.

Las categorías CEBOG anteriores no están fijas, puede haber superposición: B (Manipulada del cuerpo) a menudo podría implicar E (mejorado), por ejemplo.

Factibilidad

El software de manipulación de fotos responsable puede indicar automáticamente a los usuarios la clase de manipulación de fotos llevada a cabo. Si es necesario, podría marcarlo, o simplemente podría capturarlo en los metadatos de la imagen (como con los datos sobre la fuente, el propietario o el fotógrafo). La automatización podría garantizar la facilidad de uso y quizás reducir el error humano, fomentando la aplicación constante en todas las plataformas.

Por supuesto, mostrar la calificación será en última instancia una decisión editorial, y los buenos usuarios, como los buenos editores, lo harán de manera responsable, con suerte mantener o mejorar la reputación de sus imágenes y publicaciones. Mientras que uno esperaría que las redes sociales compren este tipo de ideal editorial y fomenten imágenes etiquetadas, queda mucho espacio para la ambigüedad y el engaño.

El éxito de una iniciativa como esta depende de desarrolladores de tecnología, organizaciones de medios y formuladores de políticas que colaboren para crear un compromiso compartido con la transparencia en los medios digitales.

Proporcionado por la conversación

Este artículo se vuelve a publicar de la conversación bajo una licencia Creative Commons. Lea el artículo original.

Cita: ¿Cómo saber si una foto es falsa? Probablemente no puedas. Es por eso que se necesitan nuevas reglas (2025, 8 de mayo) recuperadas el 8 de mayo de 2025 de https://techxplore.com/news/2025-05-photo-fake.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.