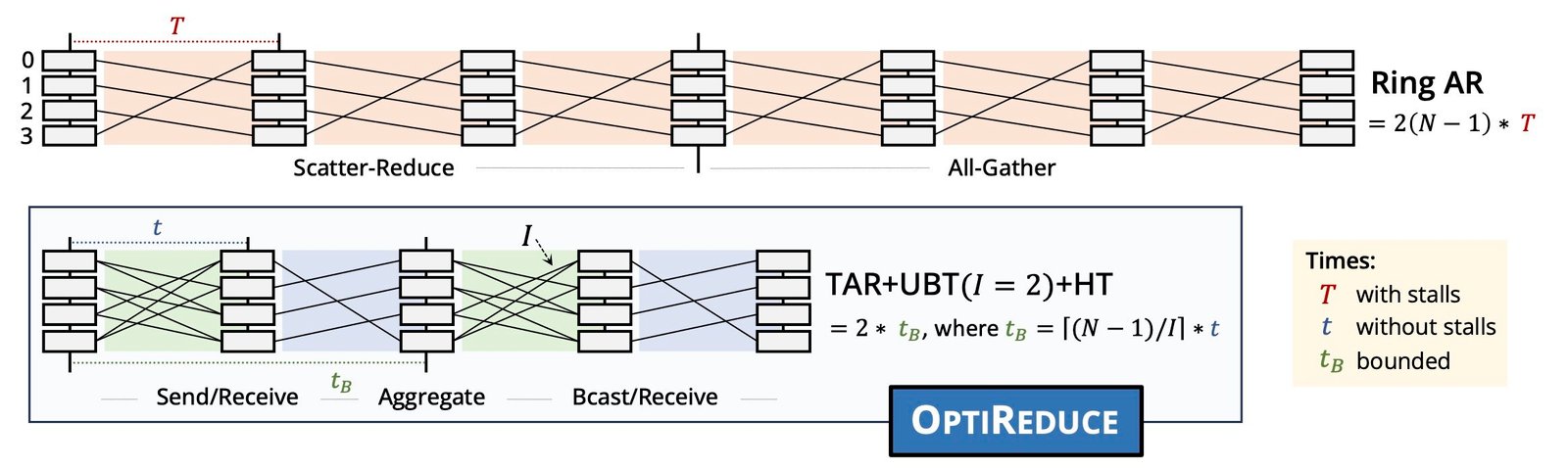

Optireduce mejora la latencia en comparación con los métodos anteriores como el anillo alreduce al reducir el número de rondas con parámetros incastentes y establecer límites al retraso de la ruta. Crédito: Laboratorio Shahbaz

Un nuevo sistema de comunicación colectiva, Optireduce, acelera la capacitación en AI y aprendizaje automático en múltiples servidores en la nube estableciendo límites de tiempo en lugar de esperar a que cada servidor se ponga al día, según un estudio dirigido por un investigador de la Universidad de Michigan.

Si bien algunos datos se pierden en los tiempos de espera, OptIleduce se aproxima a los datos perdidos y alcanza la precisión del objetivo más rápido que los competidores. Los resultados se presentaron hoy en el Simposio de Usenix sobre diseño e implementación de sistemas en red en Filadelfia, Pensilvania.

A medida que el tamaño de la IA y los modelos de aprendizaje automático continúan aumentando, la capacitación requiere que varios servidores o nodos trabajen juntos en un proceso llamado aprendizaje profundo distribuido. Al realizar capacitación dentro de los centros de computación en la nube, la congestión y los retrasos surgen a medida que se procesan múltiples cargas de trabajo a la vez dentro del entorno compartido.

Para superar esta barrera, el equipo de investigación sugiere un enfoque que es análogo al cambio de las CPU de uso general, que no pudieron manejar la IA y el entrenamiento de aprendizaje automático, a GPU específicas de dominio con mayor eficiencia y rendimiento en la capacitación.

“Hemos estado cometiendo el mismo error con la comunicación mediante el uso del transporte de datos de propósito más general. Lo que NVIDIA ha hecho para la informática, estamos tratando de hacer para la comunicación, moviendo desde el propósito general hasta el dominio específico para evitar cuellos de botella”, dijo Muhammad Shahbaz, profesor asistente de ciencias de la informática e ingeniería en UM y el autor correspondiente del estudio.

Hasta este punto, los sistemas de aprendizaje profundo distribuidos han requerido una comunicación perfecta y confiable entre los servidores individuales. Esto conduce a desaceleraciones al final de la cola porque el modelo esperaría a que todos los servidores se pongan al día antes de continuar.

En lugar de esperar a los rezagados, Opteduce introduce límites de tiempo para la comunicación del servidor y continúa sin esperar a que cada servidor complete su tarea. Para respetar los límites del tiempo al maximizar la comunicación útil, los límites se acortan adaptativamente durante los períodos de red tranquilos y se alargan durante los períodos de ocupación.

Si bien se pierde cierta información en el proceso, Opteduce aprovecha la resistencia de los sistemas de aprendizaje profundo mediante el uso de técnicas matemáticas para aproximar los datos perdidos y minimizar el impacto.

“Estamos redefiniendo la pila informática para la IA y el aprendizaje automático al desafiar la necesidad de una confiabilidad del 100% requerida en las cargas de trabajo tradicionales. Al adoptar la confiabilidad limitada, las cargas de trabajo de aprendizaje automático funcionan significativamente más rápido sin comprometer la precisión”, dijo Ertza Warraich, una estudiante de doctorado de la ciencia de la computadora en la Universidad de Purdue y el primer autor del estudio.

El equipo de investigación probó a Opteduce contra los modelos existentes dentro de un clúster virtualizado local (servidores netados que comparten recursos) y una prueba de prueba pública para aplicaciones de nubes compartidas, CloudLab. Después de entrenar múltiples modelos de redes neuronales, midieron la rapidez con que los modelos alcanzaron la precisión del objetivo, conocida como tiempo de precisión y cuántos datos se perdieron.

Optireduce los modelos existentes superados, logrando un 70% de tiempo de tiempo más rápido en comparación con GLOO, y fue un 30% más rápido en comparación con NCCL cuando se trabaja en un entorno de nube compartido.

Al probar los límites de la cantidad de datos que se podrían perder en los tiempos de espera, descubrieron que los modelos podrían perder aproximadamente el 5% de los datos sin sacrificar el rendimiento. Los modelos más grandes, incluido Llama 4, Mistral 7b, Falcon, Qwen y Gemini, fueron más resistentes a la pérdida, mientras que los modelos más pequeños eran más susceptibles.

“Optireduce fue un primer paso para mejorar el rendimiento y aliviar los cuellos de botella de comunicación al aprovechar las propiedades específicas del dominio del aprendizaje automático. Como el siguiente paso, ahora estamos explorando cómo pasar del transporte basado en software al transporte a nivel de hardware en la NIC para impulsar cientos de gigabits por segundo”, dijo Shahbaz.

Nvidia, VMware Research y Feldera también contribuyeron a esta investigación.

More information: Full citation: “OptiReduce: Resilient and tail-optimal AllReduce for distributed deep learning in the cloud,” Ertza Warraich, Omer Shabtai, Khalid Manaa, Shay Vargaftik, Yonatan Piasetzky, Matty Kadosh, Lalith Suresh, and Muhammad Shahbaz, USENIX Symposium on Networked Systems Design and Implementation (2025). www.usenix.org/conference/nsdi … Resentation/Warraich

Proporcionado por la Universidad de Michigan College of Engineering

Cita: Perfect es el enemigo del bien para el aprendizaje profundo distribuido en la nube (2025, 29 de abril) recuperado el 29 de abril de 2025 de https://techxplore.com/news/2025-04-enemy-mood-deep cloud.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.