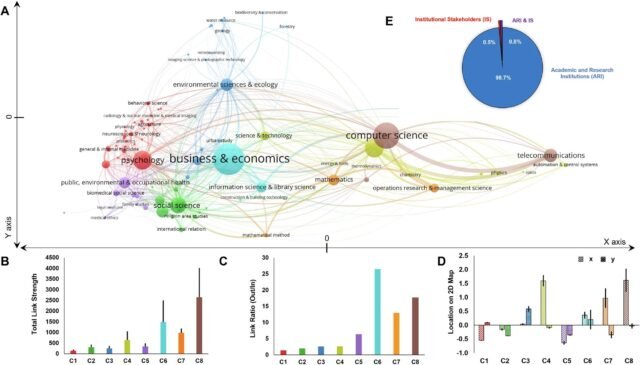

Evaluación de investigación de confianza multi-inter y transdisciplinaria. Crédito: Comunicaciones de Humanidades y Ciencias Sociales (2025). Doi: 10.1057/s41599-025-05481-9

Un equipo internacional de investigadores ha presentado un marco que argumenta que puede usarse para responder una de las preguntas más importantes que enfrentan las tecnologías de inteligencia artificial (IA): ¿se puede confiar en AI? El marco ofrece un enfoque organizado para abordar un tema complejo que se basa en una amplia variedad de disciplinas de investigación.

“Las empresas, los gobiernos y las personas comunes están adoptando herramientas de inteligencia artificial para realizar una amplia variedad de funciones, pero todavía no está claro si esta es una tecnología que es realmente confiable”, dice Roger Mayer, coautor de un documento sobre el trabajo y un profesor de liderazgo en la Facultad de Gestión de la Universidad Estatal de Carolina del Norte.

“Si vamos a usar la IA para tomar decisiones significativas, o incluso para informar decisiones importantes, la confianza es una consideración crítica. Si vamos a verter dinero en aplicaciones de IA, la confianza es una consideración vital. Por lo tanto, desarrollar un enfoque que nos permita abordar la confiabilidad de la IA de una manera significativa, tanto científica como prácticamente, es un gran paso hacia adelante”.

“Nuestra colaboración global se sumerge en la psicología, la ética y el impacto social de la confianza en la IA, que propone un” marco de redes de confianza “transdisciplinario para comprender y reforzar la confianza en la IA para abordar grandes desafíos en áreas como amplias y urgentes como una información errónea, discriminación y guerra”, dice Frank Krueger, Profesor de Neurocience Social de Sistemas en la Escuela de Sistemas Biología en la Universidad de Masonía George de la Masonía.

El Marco de Trustnet se basa en ideas desarrolladas por primera vez en un taller de confianza en Viena, Austria, que atrajo a un equipo interdisciplinario de investigadores de todo el mundo.

La IA tiene el potencial de mejorar nuestras vidas de manera significativa. Por ejemplo, los compañeros de IA pueden ofrecer apoyo emocional en el cuidado de ancianos, mientras que las herramientas de IA pueden generar contenido y automatizar tareas que aumentan la productividad. Sin embargo, los riesgos persisten. Los investigadores consideraron varios escenarios: los algoritmos utilizados en la contratación pueden llevar sesgos ocultos, tal como lo hacen los humanos. Y cuando se trata de información errónea, ¿cómo podemos saber si alguna IA es mejor que nosotros para distinguir los hechos de la ficción?

A medida que AI media cada vez más, las decisiones de alto riesgo, la confianza y la responsabilidad deben convertirse en preocupaciones centrales. En última instancia, lo que está en juego es la confianza, no solo en los sistemas de IA, sino en las personas e instituciones que diseñan, desplegan y supervisan. Para desarrollar el marco de la red de confianza, los investigadores analizaron 34,459 artículos de investigación de confianza múltiples, inter y transdisciplinarias. El análisis concluyó que se necesitan más estudios transdisciplinarios sobre el tema.

El marco de confianza de la confianza alienta a los equipos de investigación a considerar tres componentes:

Transformación del problema, incluida la conexión del “gran desafío” de si debemos confiar en la IA con conocimiento científico; Producir nuevos conocimientos que nos permitan abordar temas como aclarar los roles de los investigadores y otras partes interesadas, y diseñar un concepto de integración que nos permita abordar un desafío desde la perspectiva múltiple simultáneamente; e integración transdisciplinaria, evaluando los resultados para generar resultados útiles para la sociedad y para la ciencia, las preguntas de investigación inspiradora de una manera que promueva nuestra comprensión y tiene utilidad práctica.

“Los marcos de confianza futuros deben considerar no solo cómo los humanos confían en la IA, sino también cómo los sistemas de IA podrían evaluar y responder a la confiabilidad humana, y cómo la IA establece formas de confianza en AI a AI en entornos en red y automatizados”, explica René Riedl, coautor del documento que fue instrumental para convocar al grupo inicial de investigadores en el trabajo de confianza. RIEDL también es jefe del Programa de Master de Gestión de Empresas Digitales en la Universidad de Ciencias Aplicadas, Upper Austria y Johannes Kepler University Linz, Austria.

El papel “Un llamado a la investigación de confianza transdisciplinaria en la era de la inteligencia artificial“se publica en Comunicaciones de Humanidades y Ciencias Sociales.

“Aquellos que trabajan en IA, políticas, ética o diseño tecnológico encontrarían esta (documento) una lectura valiosa para comprender y combatir los desafíos emergentes de la confianza social de IA utilizando un marco común”, agregó Krueger. “La confianza es la base de todas las relaciones saludables, entre personas y tecnologías. La IA reestera la sociedad, pero la confianza, entre personas, sistemas e instituciones, debe guiar cómo la construimos y usamos”.

“He estudiado confianza durante más de 30 años, y uno de los elementos clave de este marco de confianza de la red que realmente me gusta es el hecho de que es transdisciplinario”, dice Mayer. “Un enfoque interdisciplinario se basa en investigadores de múltiples disciplinas.

“Pero un enfoque transdisciplinario va más allá, incorporando aportes de otras partes interesadas, como los usuarios de IA, aquellos afectados por el uso de IA, y los responsables políticos que tienen autoridad sobre aplicaciones de IA específicas, como los vehículos autónomos. Cualquier enfoque que quiera proporcionar un análisis significativo de la confianza que es de alto valor a la sociedad necesita incorporar perspectivas transdisciplinarias, una razón es que este marco es un análisis significativo que tiene mucho valor.

Más información: Frank Krueger et al, un llamado a la investigación de confianza transdisciplinaria en la era de la inteligencia artificial, las comunicaciones de humanidades y ciencias sociales (2025). Dos: 10.1057/S41599-025-05481-9

Proporcionado por la Universidad Estatal de Carolina del Norte

Cita: ¿Podemos confiar en AI? Los investigadores ofrecen un marco para abordar esta pregunta (2025, 25 de agosto) Consultado el 25 de agosto de 2025 de https://techxplore.com/news/2025-08-aiframework-tackling.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.