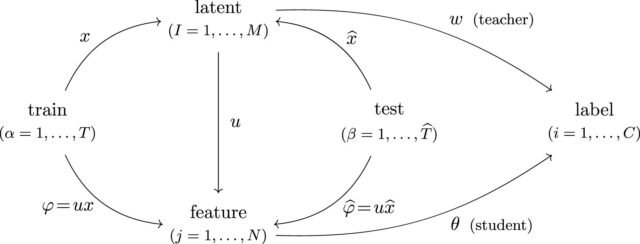

Representación gráfica del modelo. Las variables de matriz se pueden ver como mapas lineales entre los espacios vectoriales, que están representados por flechas en la figura. Crédito: Aprendizaje automático: ciencia y tecnología (2025). Doi: 10.1088/2632-2153/ADC872

Desde automóviles autónomos hasta reconocimiento facial, la vida moderna se está volviendo más dependiente del aprendizaje automático, un tipo de inteligencia artificial (IA) que aprende de conjuntos de datos sin programación explícita.

A pesar de su omnipresencia en la sociedad, apenas estamos comenzando a comprender los mecanismos que impulsan la tecnología. En un estudio reciente, Zhengkang (Kevin) Zhang, profesor asistente en el Departamento de Física y Astronomía de la Universidad de Utah, demostró cómo los físicos pueden desempeñar un papel importante en desentrañar sus misterios.

“La gente solía decir que el aprendizaje automático es una caja negra: ingresa muchos datos y, en algún momento, razona y habla y toma decisiones como los humanos. Se siente como magia porque realmente no sabemos cómo funciona”, dijo Zhang. “Ahora que estamos usando IA en muchos sectores críticos de la sociedad, tenemos que entender lo que realmente están haciendo nuestros modelos de aprendizaje automático: por qué algo funciona o por qué algo no funciona”.

Como físico teórico de partículas, Zhang explica el mundo que lo rodea entendiendo cómo se comportan los componentes más pequeños y fundamentales de la materia en un mundo infinitesimal. En los últimos años, ha aplicado las herramientas de su campo para comprender mejor los modelos masivamente complejos de Machine Learning.

Escalar mientras reduce los costos

La forma tradicional de programar una computadora es con instrucciones detalladas para completar una tarea. Digamos que quería software que pueda detectar irregularidades en una tomografía computarizada. Un programador tendría que escribir protocolos paso a paso para innumerables escenarios potenciales.

En cambio, un modelo de aprendizaje automático se entrena. Un programador humano proporciona datos relevantes (textos, números, fotos, transacciones, imágenes médicas) y permite que el modelo encuentre patrones o haga predicciones por su cuenta.

A lo largo del proceso, un humano puede ajustar los parámetros para obtener resultados más precisos sin saber cómo el modelo usa la entrada de datos para entregar la salida.

El aprendizaje automático es intensivo en energía y muy caro. Para maximizar las ganancias, la industria capacita modelos en conjuntos de datos más pequeños antes de escalarlos en escenarios del mundo real con volúmenes mucho más grandes de datos.

“Queremos poder predecir cuánto mejor hará el modelo a escala. Si duplica el tamaño del modelo o duplica el tamaño del conjunto de datos, ¿el modelo se vuelve dos veces mejor? ¿Cuatro veces mejor?” dijo Zhang.

Una parte de los diagramas de Feynman utilizados para resolver un modelo de aprendizaje automático. Crédito: Universidad de Utah

La caja de herramientas de un físico

Un modelo de aprendizaje automático se ve simple: datos de entrada—> cuadro negro de computación—> salida que es una función de la entrada.

La caja negra contiene una red neuronal, que es un conjunto de operaciones simples conectadas en una web para aproximar funciones complicadas. Para optimizar el rendimiento de la red, los programadores se han basado convencionalmente en la prueba y el error, ajustan y re-captan la red y acumulan costos.

“Al ser entrenado como físico, me gustaría entender mejor lo que realmente está sucediendo para evitar confiar en el juicio y el error”, dijo Zhang. “¿Cuáles son las propiedades de un modelo de aprendizaje automático que le dan la capacidad de aprender a hacer cosas que queríamos que hiciera?”

En un nuevo papel Publicado en la revista Machine Learning: Science and Technology, Zhang resolvió las leyes de escala de un modelo propuesto, que describen cómo el sistema funcionará a escalas cada vez más grandes. No es fácil: los cálculos requieren sumarse a un número infinito de términos.

Zhang aplicó un método que los físicos usan para rastrear cientos de miles de términos, llamados diagramas de Feynman. Richard Feynman inventó la técnica en la década de 1940 para lidiar con cálculos irremediablemente complicados de partículas elementales en el ámbito cuántico. En lugar de escribir ecuaciones algebraicas, Feynman dibujó diagramas simples: cada línea y vértice en el diagrama representa un valor.

“Es mucho más fácil para nuestros cerebros comprender, y también más fácil realizar un seguimiento de qué tipo de términos ingresan su cálculo”, dijo Zhang.

Zhang usó diagramas de Feynman para resolver un modelo planteado en la investigación publicada de 2022. En eso papelLos físicos estudiaron su modelo en un límite particular. Zhang pudo resolver el modelo más allá de ese límite, obteniendo leyes de escala nuevas y más precisas que rigen su comportamiento.

A medida que la sociedad se dirige de cabeza a IA, muchos investigadores están trabajando para garantizar que las herramientas se usen de manera segura. Zhang cree que los físicos pueden unirse a los ingenieros, informáticos y otros que trabajan para usar AI de manera responsable.

“Los humanos estamos construyendo máquinas que ya nos están controlando: algoritmos de Youtube que recomiendan videos que absorben a cada persona en sus propias esquinas e influyan en nuestro comportamiento”, dijo Zhang. “Ese es el peligro de cómo AI va a cambiar la humanidad: no se trata de robots colonizando y esclavizando a los humanos. Es que los humanos construimos máquinas que estamos luchando por entender, y nuestras vidas ya están profundamente influenciadas por estas máquinas”.

Más información: Zhengkang Zhang, Leyes de escala neuronal de la teoría de campo grande de N: modelo solucionable más allá del límite sin limitación, aprendizaje automático: ciencia y tecnología (2025). Doi: 10.1088/2632-2153/ADC872

Proporcionado por la Universidad de Utah

Cita: El físico teórico de partículas aborda la caja negra del aprendizaje de la máquina (2025, 13 de agosto) Recuperado el 13 de agosto de 2025 de https://techxplore.com/news/2025-08-theoretic–particle-physicist-tackles-machine.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.