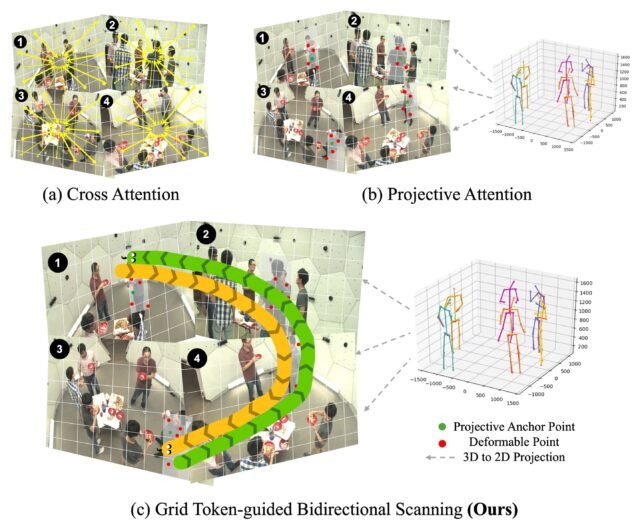

Motivación: Comparación de diferentes métodos de escaneo de tokens. (a) La atención cruzada actúa en todos los tokens de imagen. (b) La atención proyectiva obtiene anclajes con proyección en perspectiva y atiende selectivamente tokens de muestra que rodean los puntos de anclaje. (c) El escaneo bidireccional (GTBS) guiado por tokens de cuadrícula (GTBS) codifica el contexto local y la secuencia espacial conjunta en la característica visual y los niveles de punto clave de la persona. Crédito: los autores

La estimación de la pose humana con precisión fue una de las primeras tareas abordadas por el aprendizaje profundo. Modelos tempranos como Maniobra abierta centrado en localizar las articulaciones humanas como puntos clave 2D en coordenadas de imágenes. Más tarde, a Google se le ocurrió Calzoncilloseguido de Yoloposeque ganó gran atención y se adoptó ampliamente debido a su eficiencia y precisión.

Naturalmente, la siguiente frontera fue estimar poses humanas en 3D, prediciendo las ubicaciones (x, y, z) de las articulaciones en un marco de referencia global. Dado que la imagen única a 3D es un problema mal plenado, la tarea prometió ser más fácil utilizando múltiples cámaras. Sin embargo, a pesar de los años de investigación, la estimación de pose de varias personas 3D de visión múltiple sigue siendo sorprendentemente difícil.

Desglosando el rompecabezas de visión múltiple

La estimación de pose multiperson 3D multi-visión es una colección de múltiples subproblemas. Hasta hace poco, la mayoría de los estudios primero estimaban los puntos clave 2D de forma independiente de todas las imágenes de visión múltiple usando MediaPipe o Yolopose, luego coincidían con las juntas correspondientes a través de las vistas, seguidas de la coincidencia de personas, y luego usaron los parámetros de la cámara para triangular los puntos clave 2D para finalmente obtener el 3D.

Sin embargo, una deficiencia importante de tales tuberías de varias etapas es que los errores en cada etapa se multiplican. Además, tales enfoques no lograron aprovechar las señales visuales de las imágenes de visión múltiple, ya que el primer paso en sí descartó la mayor parte de la información del píxel, y toda la tubería restante simplemente descansó sobre los puntos clave 2D estimados a partir de un detector listo para usar.

Aprendizaje de extremo a extremo: un cambio de paradigma

Recientemente, algunos investigadores cambiaron su enfoque a una pregunta importante: ¿Se puede supervisar toda la tarea de extremo a extremo? Veamos cuáles serán los desafíos en tal enfoque.

Primero, dicha configuración requerirá que el modelo procese entradas completas de imágenes de visión múltiple, lo que lleva a altos gastos computacionales, a diferencia de los enfoques anteriores que guardaron el cálculo simplemente descartando la mayoría de la información visual. En segundo lugar, ¿cómo puede el modelo aprender triangulación geométrica en un marco diferencial de extremo a extremo? Por último, dado que este modelo retrocedería directamente las juntas 3D, ¿cómo se generalizaría a nuevas configuraciones?

Arquitectura del modelo: MV-SSM propone imágenes de visión múltiple a través de la columna vertebral de resnet-50 para extraer características a escala múltiple, que se refinan por bloques apilados de espacio de estado proyectivo (PSS). Estos bloques aprovechan la atención proyectiva y el modelado de espacio de estado para refinar progresivamente los puntos clave, con puntos clave 3D finales estimados a través de la triangulación geométrica. Crédito: los autores

Algunos estudios recientes, incluyendo Triangulación aprendida, MVPy Mvgormhan explorado este problema. La triangulación aprendible propuso dos enfoques de triangulación: un algebraico y un volumétrico. De manera crucial, ambos enfoques son diferenciables de extremo a extremo, lo que permite la optimización directa de la métrica objetivo.

MVP utilizó este método y retrocedió directamente las posturas humanas 3D múltiples vistas sin depender de tareas intermedias. Específicamente, MVP representa las articulaciones del esqueleto como incrustaciones de consultas aprendizables y les permite asistir progresivamente y razonar sobre la información de visión múltiple de las imágenes de entrada para retroceder directamente las ubicaciones de las juntas 3D reales. Una contribución clave es el mecanismo de atención geométricamente guiado, llamado atención proyectiva, para fusionar con mayor precisión la información de la visión cruzada para cada articulación.

Recientemente, MVGFormer planteó una preocupación importante con respecto a los modelos de regresión como MVP, que tienen una generalización muy baja.

Exposado: la crisis de generalización

MVGFormer demostró que los modelos anteriores se sobrefiaban en los conjuntos de datos de entrenamiento, es decir, si el número de cámaras se reduce o aumenta durante las pruebas, los puntajes AP25 mostraron una gran caída, lo que indica que incluso una ganancia en la información visual no podría ser utilizada efectivamente por estos modelos. En segundo lugar, a medida que se cambian las posiciones u orientaciones de la cámara, o cuando estos modelos se evalúan en los datasets cruzados, también muestran un alto acompañamiento.

MVGFormer abordó esto utilizando transformadores que combinaban la triangulación geométrica en un entorno basado en el aprendizaje, con sus módulos de apariencia utilizando efectivamente la información visual que se descartaba en tuberías de varias etapas anteriores.

Arquitectura de bloque: arquitectura del (a) bloque de mamba, (b) VSS Bloque y (c) el bloque PSS propuesto. El bloque PSS captura las relaciones espaciales conjuntas a través de la atención proyectiva y el modelado de espacio estatal, refinando progresivamente los resultados. Crédito: las comparaciones visuales de los autores: presentamos una comparación visual contra MVGFormer en CMU Panoptic Benchmark. Las posturas humanas de la verdad del suelo se muestran en rojo y la pose predicha se superpone para mostrar una comparación precisa. MV-SSM logra posturas precisas, especialmente en escenarios difíciles, lo que demuestra un rendimiento superior. Como se ilustra en la primera fila, MV-SSM está mejor capaz de predecir, por ejemplo, el pie izquierdo de la persona. Tenga en cuenta que los colores de las personas son diferentes, ya que no realizamos una coincidencia de identificación. Crédito: los autores

Generalización fuerte: la métrica ganadora de MV-SSM

Sobre la base de este problema de investigación y para abordar mejor el problema de generalización, propusimos MV-SSM, un modelo novedoso para la estimación de pose humana 3D utilizando modelos de espacio de estado múltiple. MV-SSM fue presentado en la conferencia IEEE/CVF sobre visión por computadora y reconocimiento de patrones (CVPR 2025) celebrado en Nashville, del 11 al 15 de junio. MV-SSM modela explícitamente la secuencia espacial conjunta en dos niveles distintos: el nivel de características de las imágenes de visión múltiple y el nivel de punto clave de la persona.

Proponemos un bloque de espacio de estado proyectivo (PSS) para aprender una representación generalizada de los arreglos espaciales articulares utilizando el modelado de espacio de estado. Además, modificamos el escaneo tradicional de Mamba en un escaneo bidireccional (GTBS) guiado por tokens de cuadrícula efectivo, que es parte integral del bloque PSS.

Múltiples experimentos demuestran que MV-SSM logra una fuerte generalización, superando a los modelos de última generación: +24% en el desafiante entorno de tres cámaras en la panóptica de CMU, +13% en arreglos de cámara variables y +38% en el campus A1 en evaluaciones de dataset cruzados.

Calibración conocida: el talón de Aquiles de la estimación de pose 3D

Sin embargo, como los modelos anteriores, una limitación importante de MV-SSM supone que se conocen los parámetros de la cámara. Aunque es impresionante, la estimación de posturas humanas 3D que no están limitadas a una disposición específica de la cámara, vinculadas a escenas específicas en los datos de capacitación, o requieren un número fijo de cámaras sigue siendo un gran desafío, uno que, si se resuelve, tiene una tremenda utilidad industrial.

Esta historia es parte de Diálogo de ciencias xdonde los investigadores pueden informar los resultados de sus artículos de investigación publicados. Visite esta página Para obtener información sobre el diálogo de Science X y cómo participar.

Más información: Aviral Chharia, etc. MV-SSM: modelado de espacio de estado múltiple para estimación de pose humana 3DActas de la Conferencia de Reconocimiento de Visión y Patrones de la Computadora (CVPR) (2025).

Aviral Chharia es un estudiante graduado en la Universidad Carnegie Mellon. Ha sido galardonado con la beca Atk-Nick G. Vlahakis Graduate Fellowship en CMU, la Comunidad de Graduados de Investigación de Pregrado de Estudiantes (Surge) en IIT Kanpur, India, y la Beca de Investigación Mitacs Globalink en la Universidad de Columbia Británica. Además, recibió dos veces la beca de la lista del decano durante su licenciatura. Sus intereses de investigación incluyen visión por computadora, gráficos por computadora y aprendizaje automático.

Cita: ¿Más cámaras, más problemas? Por qué el aprendizaje profundo todavía lucha con la detección humana 3D (2025, 12 de agosto) recuperado el 12 de agosto de 2025 de https://techxplore.com/news/2025-08-cameras-problems-deep-stuggles-3d.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.