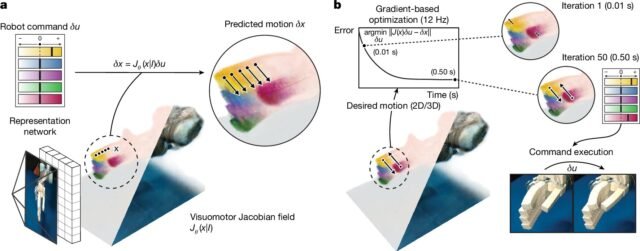

A, Reconstrucción del campo visuomotor jacobiano y predicción de movimiento. A partir de una sola imagen, un modelo de aprendizaje automático infiere una representación 3D del robot en la escena, que nombramos el campo jacobiano visuomotor. Codifica la geometría y la cinemática del robot, lo que nos permite predecir los movimientos 3D de los puntos de superficie del robot en todos los comandos posibles. Los colores indican la sensibilidad de ese punto a los canales de comando individuales. B, control de circuito cerrado de la visión. Dadas las trayectorias de movimiento deseadas en el espacio de píxeles o en 3D, utilizamos el campo jacobiano visuomotor para optimizar para el comando robot que generaría el movimiento prescrito a una velocidad interactiva de aproximadamente 12 Hz. La ejecución del comando robot en el mundo real confirma que se han logrado los movimientos deseados. Crédito: Naturaleza (2025). Doi: 10.1038/s41586-025-09170-0

Los robots convencionales, como los utilizados en la industria y los entornos peligrosos, son fáciles de modelar y controlar, pero son demasiado rígidos para operar en espacios confinados y terrenos desiguales. Los robots suaves y bioinspirados son mucho mejores para adaptarse a sus entornos y maniobrar en lugares inaccesibles.

Sin embargo, estas capacidades más flexibles normalmente requerirían una variedad de sensores a bordo y modelos espaciales adaptados de forma exclusiva para cada diseño de robot individual.

Tomando un enfoque nuevo y menos demandante de recursos, un equipo de investigadores del MIT ha desarrollado un sistema de control de aprendizaje profundo mucho menos complejo que enseña robots suaves y bioinspirados para mover y seguir comandos de una sola imagen.

Sus resultados son publicado En el diario de la naturaleza.

Al entrenar una red neuronal profunda en dos o tres horas de visión múltiple de video de varios robots que ejecutan comandos aleatorios, los investigadores capacitaron a la red para reconstruir tanto la forma como el rango de movilidad de un robot a partir de una sola imagen.

Los diseños anteriores de control de aprendizaje automático requerían personalización experta y costosos sistemas de captura de movimiento. Esta falta de un sistema de control de uso general limitó sus aplicaciones y hizo que la prototipos rápidos fuera mucho menos práctico.

“Nuestro método desembolsa el diseño de hardware de robots de nuestra capacidad para modelarlos manualmente, lo que en el pasado ha dictado la fabricación de precisión, materiales costosos, capacidades de detección extensas y dependencia de bloques de construcción convencionales y rígidos”, señalan los investigadores en su artículo.

El nuevo enfoque de aprendizaje automático de una sola cámara permitió un control de alta precisión en las pruebas en una variedad de sistemas robóticos, incluida una mano neumática impresa en 3D, una muñeca auxética suave, una mano Allegro de 16 dOF y un brazo robot de amapola de bajo costo.

Estas pruebas lograron lograr menos de tres grados de error en el movimiento de la junta y menos de 4 milímetros (aproximadamente 0.15 pulgadas) de error en el control de la punta de los dedos. El sistema también pudo compensar el movimiento del robot y los cambios en el entorno circundante.

“Este trabajo apunta a un cambio de robots de programación a robots de enseñanza”, señala Ph.D. Estudiante Sizhe Lester Li en un MIT función web.

“Hoy, muchas tareas de robótica requieren ingeniería y codificación extensas. En el futuro, imaginamos mostrar un robot qué hacer y dejar que aprenda a lograr el objetivo de forma autónoma”.

Dado que este sistema se basa solo en la visión, puede no ser adecuado para tareas más ágiles que requieren detección de contacto y manipulación táctil. Su rendimiento también puede degradarse en los casos en que las señales visuales son insuficientes.

Los investigadores sugieren que la adición de sensores táctiles y otros podría permitir que los robots realicen tareas más complejas. También existe el potencial de automatizar el control de una gama más amplia de robots, incluidos aquellos con sensores mínimos o no integrados.

Escrito para usted por nuestro autor Charles Blueeditado por Sadie Harleyy verificado y revisado por Robert Egan—Este artículo es el resultado de un trabajo humano cuidadoso. Confiamos en lectores como usted para mantener vivo el periodismo científico independiente. Si este informe le importa, considere un donación (especialmente mensual). Obtendrá una cuenta sin anuncios como agradecimiento.

Más información: Sizhe Lester Li et al, controlando diversos robots inferiendo campos jacobianos con redes profundas, naturaleza (2025). Dos: 10.1038/s41586-025-09170-0

© 2025 Science X Network

Cita: el sistema de aprendizaje profundo enseña robots suaves inspirados en biografías para moverse usando solo una cámara (2025, 9 de julio) recuperado el 9 de julio de 2025 de https://techxplore.com/news/2025-07-deep-soft-bio-bio–bobots-camera.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.