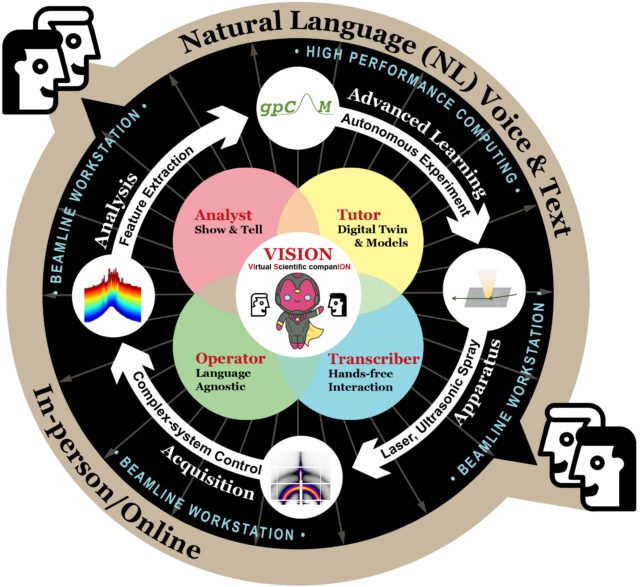

Vision tiene como objetivo liderar la expedición científica controlada por el idioma natural con la fuerza conjunta de Human-AI para el descubrimiento científico acelerado en las instalaciones de los usuarios. Crédito: Laboratorio Nacional de Brookhaven

Un equipo de científicos del Laboratorio Nacional del Departamento de Energía de los Estados Unidos (DOE) Brookhaven ha soñado, desarrollado y probado un nuevo asistente de inteligencia artificial (AI) controlada por voz diseñada para romper las barreras cotidianas para los científicos ocupados.

Conocida como el Compañero Científico Virtual, o Visión, la herramienta AI generativa, desarrollada por los investigadores del Centro de Nanomateriales Funcionales (CFN) del Laboratorio con el apoyo de expertos en la fuente de luz Nacional de Sincronos II (NSLS-II), ofrece una oportunidad para unir a los instrumentos complejos de los instrumentos complejos, llevar a cabo más eficientes experimentos, salvar el tiempo de los científicos, y en general, acelerados, acelerados científicos.

La idea es que un usuario simplemente tiene que decirle a Vision en lenguaje sencillo lo que le gustaría hacer en un instrumento y el compañero de IA, adaptado a ese instrumento, asumirá la tarea, ya sea que esté ejecutando un experimento, lanzar un análisis de datos o visualizar resultados. El equipo de Brookhaven recientemente compartió detalles sobre la visión en un artículo publicado En el aprendizaje automático: ciencia y tecnología.

“Estoy realmente entusiasmado con cómo la IA puede impactar la ciencia y es algo que nosotros, como comunidad científica, definitivamente deberíamos explorar”, dijo Esther Tsai, científica del grupo de nanociencia acelerada de AI-AI en CFN. “Lo que no podemos negar es que los científicos brillantes pasan mucho tiempo en el trabajo de rutina. La visión actúa como asistente con el que los científicos y los usuarios pueden hablar para obtener respuestas a preguntas básicas sobre la capacidad y la operación del instrumento”.

Visión destaca la estrecha asociación entre CFN y NSLS-II, dos instalaciones de usuarios de la Oficina de Ciencias del DOE en Brookhaven Lab. Juntos colaboran con los usuarios de las instalaciones en la configuración, la planificación científica y el análisis de datos de experimentos en tres líneas de haz NSLS-II, herramientas de medición altamente especializadas que permiten a los investigadores explorar la estructura de materiales utilizando vigas de rayos X.

TSAI, inspirado para aliviar los cuellos de botella que conlleva el uso de las líneas de vigas en demanda de NSLS-II, recibió un premio de carrera temprana del DOE en 2023 para desarrollar este nuevo concepto. TSAI ahora lidera el equipo de CFN detrás de Vision, que ha colaborado con los científicos de línea de haz NSLS-II para lanzar y probar el sistema en la línea de haz de dispersión de materiales complejas (CMS) en NSLS-II, lo que demuestra el primer experimento controlado por voz en una línea de haz de dispersión de rayos X y un progreso en el progreso hacia el descubrimiento mundial de AI-AI-AI-AI-AI-AI-AI-AI-AI-AI-AI-AI-AI-AI-AI-AI-A-A-A-A-A-A-A-Augmented Discovery.

“En Brookhaven Lab, no solo estamos liderando en la investigación de este concepto de compañía virtual científica fronteriza, también estamos siendo prácticos, desplegando esta técnica de IA en el piso experimental en NSLS-II y explorando cómo puede ser útil para los usuarios”, dijo Tsai.

Hablando con AI para flujos de trabajo flexibles

Vision aprovecha las crecientes capacidades de los modelos de idiomas grandes (LLM), la tecnología en el corazón de los populares asistentes de IA como ChatGPT.

Un LLM es un programa expansivo que crea texto modelado en lenguaje humano natural. La visión explota este concepto, no solo para generar texto para responder preguntas, sino también para generar decisiones sobre qué hacer y el código de computadora para impulsar un instrumento. Internamente, la visión se organiza en múltiples “bloques cognitivos” o engranajes, cada uno comprende una LLM que maneja una tarea específica. Se pueden elaborar múltiples engranajes para formar un asistente capaz, con los engranajes que realizan trabajo de manera transparente para el científico.

“Un usuario puede ir a la línea de luz y decir:” Quiero seleccionar ciertos detectores “o” Quiero tomar una medida cada minuto durante cinco segundos “o” Quiero aumentar la temperatura “y la visión traducirá ese comando en código”, dijo Tsai.

Esos ejemplos de entradas de lenguaje natural, ya sean el habla, el texto o ambos, se alimentan primero con el engranaje “clasificador” de Vision, que decide qué tipo de tarea está preguntando el usuario. El clasificador enruta al COG adecuado para la tarea, como un COG “operador” para el control de instrumentos o el COG “analista” para el análisis de datos.

Luego, en solo unos segundos, el sistema traduce la entrada al código que se ha transmitido a la estación de trabajo de la línea de luz, que el usuario puede revisar antes de ejecutar. En el back -end, todo se ejecuta en “HAL”, un servidor CFN optimizado para ejecutar cargas de trabajo de IA en las unidades de procesamiento de gráficos.

El uso del lenguaje natural de Vision, es decir, cómo las personas hablan normalmente, es su ventaja clave. Dado que el sistema se adapta al instrumento que el investigador está utilizando, se libera de pasar tiempo configurando parámetros de software y, en cambio, puede centrarse en la ciencia que están buscando.

“La visión actúa como un puente entre los usuarios y la instrumentación, donde los usuarios pueden hablar con el sistema y el sistema se encarga de los experimentos de conducción”, dijo Noah van der Vleuten, coautor que ayudó a desarrollar la capacidad de generación de código de Vision y el marco de pruebas. “Podemos imaginar que esto haga que los experimentos sean más eficientes y brindan a las personas mucho más tiempo para concentrarse en la ciencia, en lugar de convertirse en expertos en el software de cada instrumento”.

La capacidad de hablar con la visión, no solo el mensaje tipo A, podría hacer que los flujos de trabajo sean aún más rápido, señalaron los miembros del equipo.

En el mundo de IA de ritmo rápido y en constante evolución, los creadores de Vision también se propusieron construir una herramienta científica que pueda mantener la mejora de la tecnología, incorporar nuevas capacidades de instrumentos y escalar según sea necesario para navegar sin problemas múltiples tareas.

“Un principio guía clave es que queríamos ser modulares y adaptables, por lo que podemos intercambiar rápidamente o reemplazar con nuevos modelos de IA a medida que se vuelven más poderosos”, dijo Shray Mathur, primer autor en el periódico que trabajó en las capacidades de audio de audio y la arquitectura general. “A medida que los modelos subyacentes mejoran, la visión mejora. Es muy emocionante porque trabajamos en algunas de las tecnologías más recientes y la implementamos de inmediato. Estamos creando sistemas que realmente pueden beneficiar a los usuarios en su investigación”.

Este trabajo se basa en una historia de herramientas de IA y aprendizaje automático (ML) desarrolladas por CFN y NSLS-II para ayudar a los científicos de las instalacionesincluso para Experimentos autónomosanálisis de datos, y robótica. Las versiones futuras de la visión podrían actuar como una interfaz natural para estas herramientas avanzadas de IA/ML.

El equipo detrás de la visión en la línea de luz CMS. De izquierda a derecha, coautores y Centro de Científicos de Nanomateriales Funcionales, Shray Mathur, Noah van der Vleuten, Kevin Yager y Esther Tsai. Crédito: Kevin Coughlin/Brookhaven National Laboratory

Una visión para la asociación humana-ai

Ahora que se desarrolla la arquitectura de visión y en una etapa en la que tiene una demostración activa en la línea de haz de CMS, el equipo tiene como objetivo probarla aún más con los científicos y usuarios de línea de haz y, finalmente, llevar el compañero de IA virtual a líneas de vigas adicionales.

De esta manera, el equipo puede tener discusiones reales con los usuarios sobre lo que es realmente útil para ellos, dijo Tsai.

“La colaboración CFN/NSLS-II es realmente única en el sentido de que estamos trabajando juntos en este desarrollo de IA fronteriza con modelos de idiomas en el piso experimental, en los usuarios de compra de primera línea”, dijo Tsai. “Estamos recibiendo comentarios para comprender mejor lo que necesitan los usuarios y cómo podemos apoyarlos mejor”.

Tsai ofreció un gran agradecimiento al científico de la línea de luz principal de CMS Ruipeng Li por su apoyo y apertura a las ideas para la visión.

La línea de haz CMS ya ha sido un campo de pruebas para capacidades AI/ML, incluidos experimentos autónomos. Cuando surgió la idea de traer visión a la línea de vigas, Li la vio como una oportunidad emocionante y divertida.

“Hemos sido colaboradores y socios cercanos desde que se construyó la línea de vigas hace más de ocho años”, señaló Li. “Estos conceptos nos permiten construir sobre el potencial de nuestra línea de luz y continuar empujando los límites de las aplicaciones AI/ML para la ciencia. Queremos ver cómo podemos aprender de este proceso porque ahora estamos montando la ola AI”.

En la imagen más grande de la investigación científica acuática de AI, el desarrollo de la visión es un paso hacia la realización de otros conceptos de IA en todo el complejo DOE, incluido un exocorteza científica.

Kevin Yager, el líder del Grupo de Nanociencia AI-AI-AI en el coautor de CFN y Vision, imagina la exocorteza como una extensión del cerebro humano con el que los investigadores pueden interactuar a través de la conversación para generar inspiración e imaginación para el descubrimiento científico.

“Cuando imagino el futuro de la ciencia, veo un ecosistema de agentes de IA que trabajan en coordinación para ayudarme a avanzar en mi investigación”, dijo Yager. “El sistema de visión es un ejemplo temprano de este futuro: asistente de AI que lo ayuda a operar un instrumento. Queremos construir más asistentes de IA y conectarlos a una red realmente poderosa”.

Más información: Shray Mathur et al, Visión: un asistente de IA modular para la interacción natural del instrumento humano en las instalaciones científicas de los usuarios, aprendizaje automático: ciencia y tecnología (2025). Dos: 10.1088/2632-2153/add9e4

Proporcionado por el Laboratorio Nacional de Brookhaven

Cita: Compañero virtual interactivo para acelerar los descubrimientos en las instalaciones de usuario científico (2025, 26 de junio) Recuperado el 26 de junio de 2025 de https://techxplore.com/news/2025-06-interactive-virtual-companion-discoveries-scientific.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.