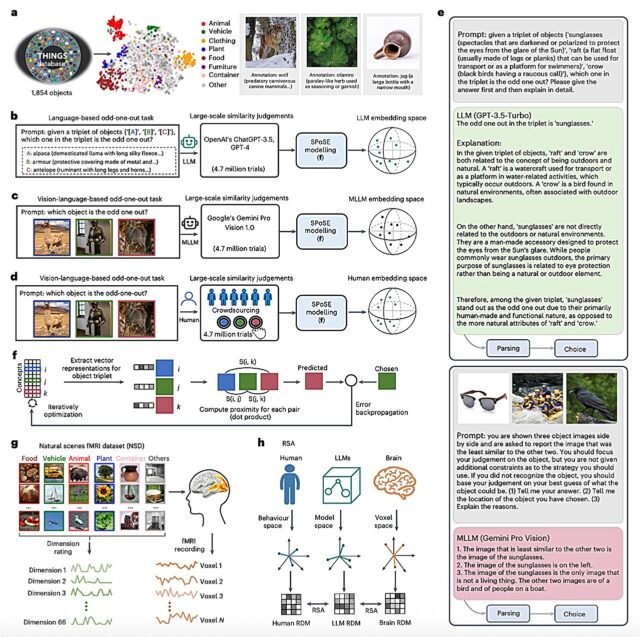

Esquemas de los métodos de experimento y análisis. A, Base de datos de cosas y ejemplos de imágenes de objetos con sus descripciones de lenguaje dadas en la parte inferior. B-D, tuberías de aprendizaje de incrustación mental bajo el paradigma de triplete impar-one-out para LLM (B), MLLMS (C) y humanos (D). E, ejemplos de indicaciones y respuestas para LLM y MLLMS. F, Ilustración del enfoque de modelado de SPOSSE. G, Ilustración del conjunto de datos NSD con clasificaciones de dimensiones para imágenes de estímulo. H, descripción general de las comparaciones entre el espacio de los LLM, el comportamiento humano y la actividad cerebral. Todas las imágenes fueron reemplazadas por imágenes similares de Pixabay y Pexels bajo una licencia Creative Commons CC0. Crédito: Nature Machine Intelligence (2025). Doi: 10.1038/s42256-025-01049-z

Una mejor comprensión de cómo el cerebro humano representa objetos que existen en la naturaleza, como rocas, plantas, animales, etc., podría tener implicaciones interesantes para la investigación en varios campos, incluida la psicología, la neurociencia y la informática. Específicamente, podría ayudar a arrojar nueva luz sobre cómo los humanos interpretan la información sensorial y completan diferentes tareas del mundo real, lo que también podría informar el desarrollo de técnicas de inteligencia artificial (IA) que emulan de cerca procesos biológicos y mentales.

Se ha encontrado que los modelos multimodales de lenguaje grande (LLM), como los últimos modelos que sustentan el funcionamiento del popular plataforma conversacional ChatGPT, son técnicas computacionales altamente efectivas para el análisis y la generación de textos en varios idiomas humanos, imágenes e incluso videos cortos.

Como los textos e imágenes generados por estos modelos a menudo son muy convincentes, hasta el punto de que podrían parecer contenido creado por humanos, las LLM multimodales podrían ser herramientas experimentales interesantes para estudiar las bases de las representaciones de objetos.

Investigadores de la Academia de Ciencias de China llevaron a cabo un estudio destinado a comprender mejor cómo los LLM multimodales representan objetos, al tiempo que intentan determinar si las representaciones de objetos que surgen en estos modelos se parecen a los observados en humanos. Sus hallazgos son publicado In Nature Machine Intelligence.

“Comprender cómo los humanos conceptualizan y clasifican los objetos naturales ofrecen información crítica sobre la percepción y la cognición”, escribieron Changde du, Kaicheng Fu y sus colegas en su artículo. “Con el advenimiento de los grandes modelos de idiomas (LLM), surge una pregunta clave: ¿pueden estos modelos desarrollar representaciones de objetos similares a los humanos a partir de datos lingüísticos y multimodales?

“Combinamos análisis de comportamiento y neuroimagen para explorar la relación entre las representaciones conceptuales de objetos en LLM y la cognición humana”.

Dimensiones de objetos que ilustran su interpretabilidad. Crédito: Nature Machine Intelligence (2025). Doi: 10.1038/s42256-025-01049-z

Como parte de su estudio, los investigadores examinaron específicamente las representaciones de objetos que emergen en el LLM ChatGPT-3.5 creado por Open AI, y en el MultiModal LLM Geminipro Vision 1.0 desarrollado en Google Deepmind. Pidieron a estos modelos que completen tareas simples conocidas como juicios de triplete. Para cada una de estas tareas, se les presentó tres objetos y se les pidió que seleccionaran los dos que se parecían más.

“Recolectamos 4,7 millones de juicios de triplete de LLM y LLM multimodales para derivar incrustaciones de baja dimensión que capturan la estructura de similitud de 1.854 objetos naturales”, escribió Du, Fu y sus colegas. “Las incrustaciones resultantes 66 dimensionales fueron estables, predictivos y exhibieron agrupaciones semánticas similares a las representaciones mentales humanas. Sorprendentemente, las dimensiones subyacentes a estas incrustaciones fueron interpretables, lo que sugiere que los LLM y los LLM multimodales desarrollan representaciones conceptuales de objetos humanos”.

Utilizando el gran conjunto de datos de los juicios de triplete que recolectaron, los investigadores calcularon incrustaciones de baja dimensión. Estas son representaciones matemáticas que describen la similitud entre los objetos sobre varias dimensiones, colocando objetos similares más cerca entre sí en un espacio abstracto.

En particular, los investigadores observaron que las integridades de baja dimensión que alcanzaron de manera confiable se agruparon objetos en categorías significativas, como “animales”, “plantas”, etc. Por lo tanto, concluyeron que los LLM y los LLM multimodales organizan naturalmente objetos de manera similar a cómo se representan y clasifican en la mente humana.

“Un análisis más detallado mostró una fuerte alineación entre los insertos del modelo y los patrones de actividad neuronal en regiones cerebrales, como el área del cuerpo extra estriada, el área de lugar para-hipocampo, la corteza retro-splenial y el área de la cara fusiforme”, escribió el equipo. “Esto proporciona evidencia convincente de que las representaciones de objetos en LLM, aunque no son idénticas a las humanas, comparten similitudes fundamentales que reflejan aspectos clave del conocimiento conceptual humano”.

En general, los resultados recopilados por DU, FU y sus colegas sugieren que las representaciones de objetos naturales similares a los humanos podrían surgir inherentemente en LLM y LLM multimodales después de que se entrenan en grandes cantidades de datos. En el futuro, este estudio podría inspirar a otros equipos de investigación a explorar cómo los LLM representan objetos, al tiempo que potencialmente contribuyen al avance adicional de los sistemas de IA inspirados en el cerebro.

Escrito para usted por nuestro autor Ingrid Fadellieditado por Lisa Lock

y verificado y revisado por Robert Egan —Este artículo es el resultado de un trabajo humano cuidadoso. Confiamos en lectores como usted para mantener vivo el periodismo científico independiente. Si este informe le importa, considere un donación (especialmente mensual). Obtendrá una cuenta sin anuncios como agradecimiento.

Más información: Changde du et al, representaciones conceptuales de objetos humanos emergen naturalmente en modelos multimodales de lenguaje grande, inteligencia de la máquina de la naturaleza (2025). Doi: 10.1038/s42256-025-01049-z

© 2025 Science X Network

Cita: las LLM multimodales y el cerebro humano crean representaciones de objetos de manera similar, Study Halla (2025, 25 de junio) recuperó el 25 de junio de 2025 de https://techxplore.com/news/2025-06-multimodal-llms-human-brain-representations.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.